给机器人装上“预见未来”的副驾

| 基于预测的决策

真正的自主导航,尤其在未知或部分可见的环境中,从来不是单一模态的任务。它是一场多模态推理的终极挑战:

智能体必须将视觉感知、语言理解与空间推理无缝融合,构建一个动态的、可预测的内心世界模型。

这正是 Astra 与 CogniPlan 作为双系统架构的突破性所在。它们不再将“感知”与“规划”视为独立的流水线,而是构成了一个协同推理引擎:基于预测的决策。

Astra确保了智能体对当下环境的精准理解,而CogniPlan赋予了它“穿透墙壁”思考未来的能力。

两者结合,使得智能体不仅能响应指令,更能主动推理、预测并优化其行动策略,从而在复杂的、前所未有的真实世界中实现真正鲁棒和高效的导航。

Astra

我们首先介绍字节跳动的研究成果Astra,用于解决移动机器人在多样、复杂室内环境中的导航难题。

核心思想与创新

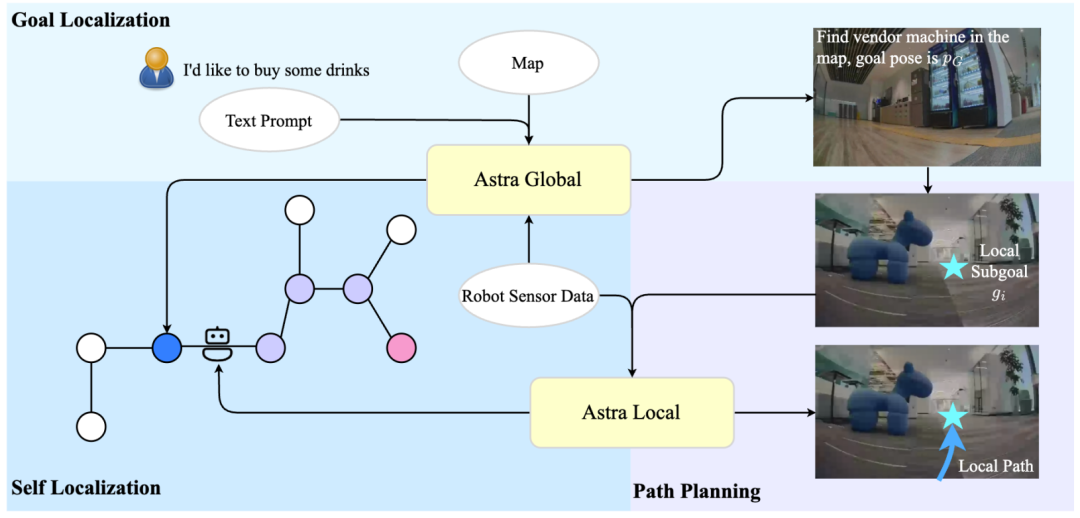

与传统导航系统依赖多个小型模块或规则系统不同,Astra提出了一个双模型架构,将核心导航任务整合到两个高度智能的模型中。

双模型架构由以下两方面构成:

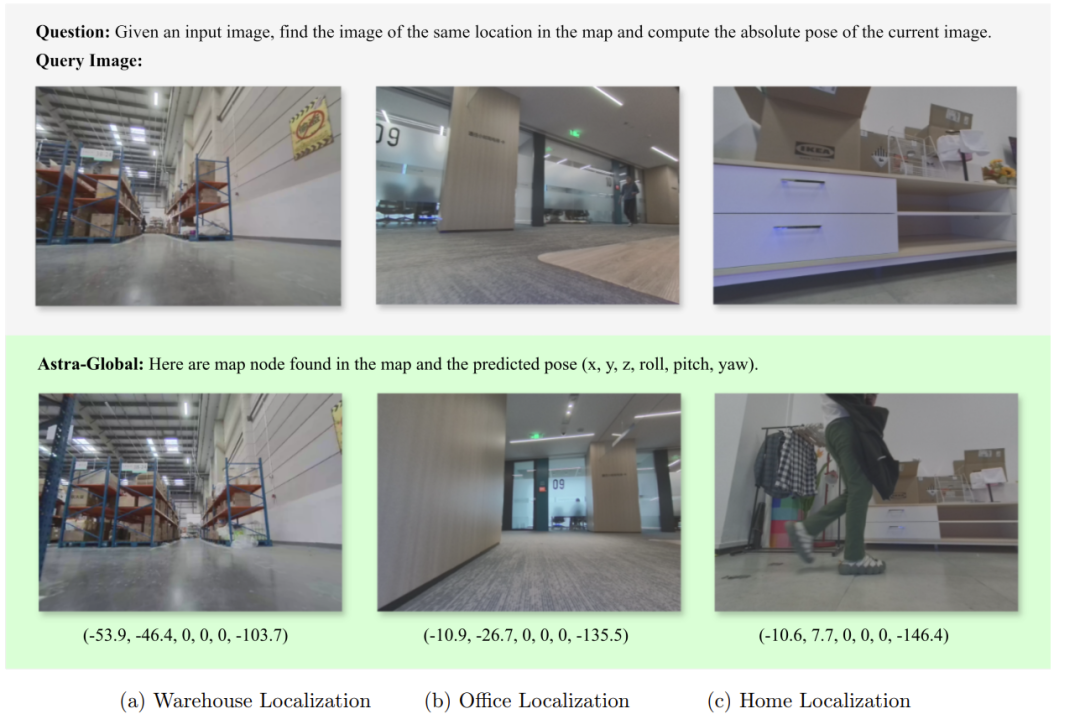

Astra-Global:一个多模态大语言模型(MLLM),扮演“战略大脑”。

它负责处理低频次但需要高级语义理解的任务,即目标定位(根据用户语言指令找到目标地点)和机器人自定位(判断“我在哪里”)。

Astra-Local:一个多任务网络,扮演“战术小脑”。

它负责处理高频次的实时任务,包括局部路径规划(避开障碍物、驶向子目标)和里程计估计(融合多传感器数据精确推算自身运动)。

这种分工借鉴了人类的“系统1/系统2”思维模式,兼顾了深思熟虑的语义推理和快速反应的实时控制,是其最根本的创新。

系统详解

(1)Astra-Global(全局战略大脑)

功能:

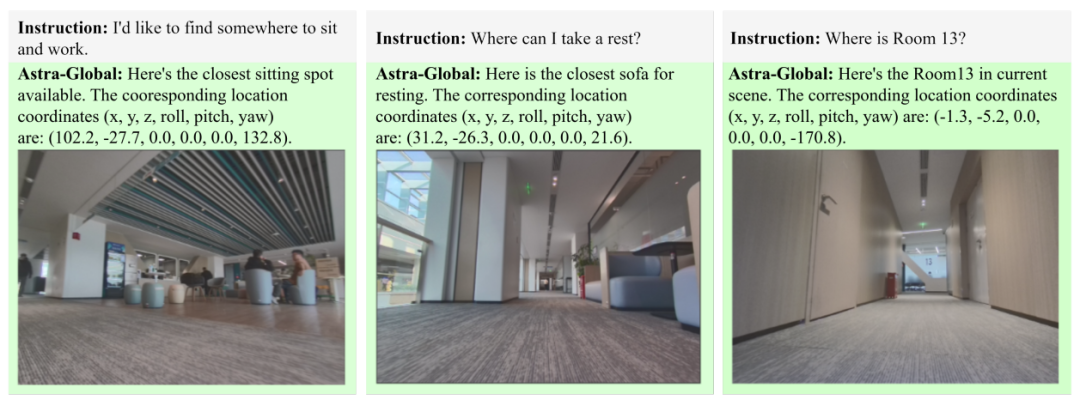

理解用户的语言指令(如“我想找个地方休息”),并在预先构建的混合拓扑-语义地图中找到目标的位置;同时,也能根据机器人当前看到的图像,确定机器人自身在地图中的精确位置。

关键技术:

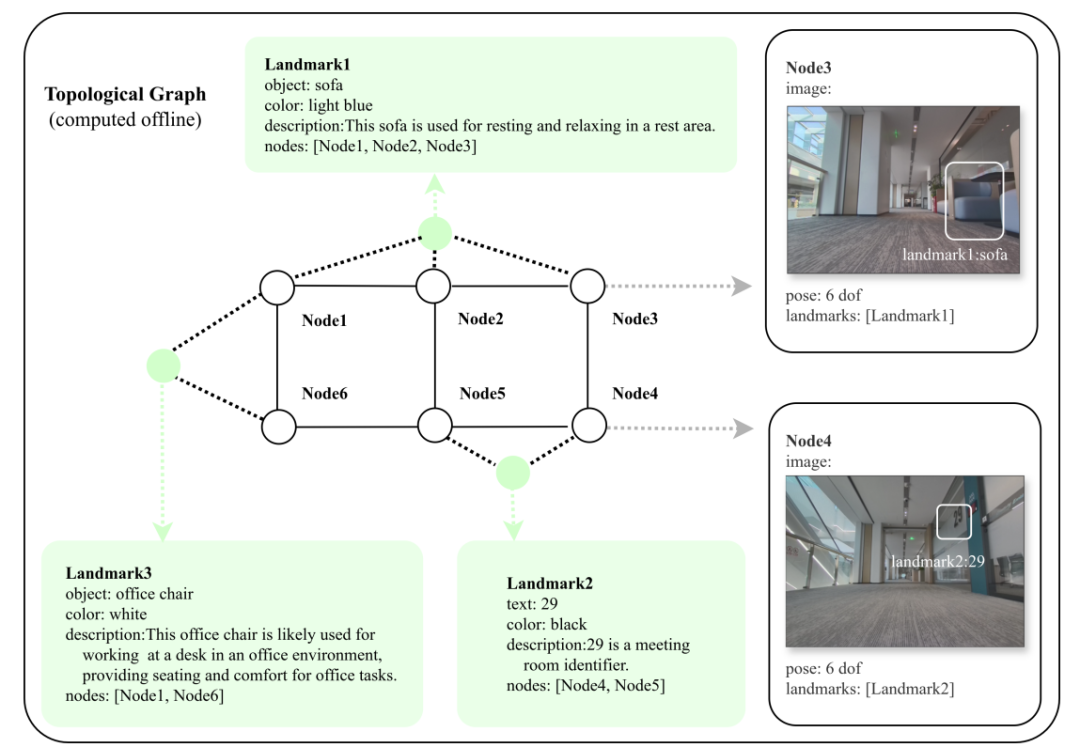

① 混合地图构建:

离线阶段,系统会根据环境的演示视频,自动构建一张独特的地图。

这张地图不仅包含环境的几何拓扑结构(像传统地图一样有节点和连接关系),还为每个关键地点赋予了丰富的语义标签(例如:“这是一个用于休息的灰色沙发”、“这是A-001号门”)。

这使得地图既能用于路径规划,也能理解高级语义。

② 两阶段定位:

粗定位:

模型先分析当前图像,识别出其中的语义地标(如沙发、门牌),然后在地图库中搜索匹配这些地标描述的区域,快速缩小可能的位置范围。

精定位:

在粗定位选出的几个候选地点附近,模型会进行更精细的图像对比和推理,最终输出一个精确的6自由度位姿(位置和朝向)。

③ 模型训练:

基于Qwen2.5-VL大模型,采用监督微调(SFT) 和强化学习(GRPO) 结合的方式训练。强化学习的引入显著提升了模型的泛化能力和数据利用效率,使其在未见过的新环境中(如从仓库切换到家庭环境)也能表现优异(零样本能力)。

(2)Astra-Local(局部战术小脑)

功能:

接收来自多相机的图像、IMU、轮速计等传感器数据,实时输出局部避障路径和精确的里程计信息。

关键技术:

① 4D时空编码器:

这是Astra-Local的“眼睛”。它通过自监督学习方式预训练,能将从多相机、多帧图像中提取的2D特征,直接构建成一种时空一致的4D体素特征(可理解为对周围环境及其动态变化的稠密编码)。

这种方式无需昂贵的3D标注数据,成本效益极高。这个编码器不仅能感知当前环境,还能预测未来几秒的环境状态,为规划提供前瞻性信息。

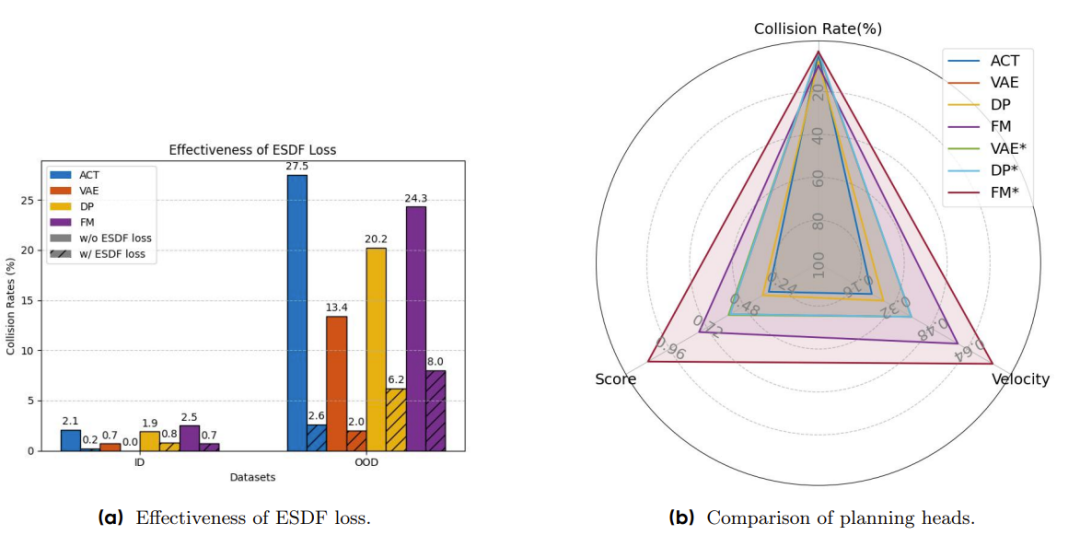

② 规划头:

采用流匹配(Flow Matching) ,根据4D特征、子目标点和机器人状态,生成平滑、多样的局部轨迹。

其核心创新是提出了掩码ESDF损失函数。该损失能有效引导模型生成远离障碍物的轨迹,同时不会偏离全局目标方向。实验表明,该损失能大幅降低碰撞率,且几乎不增加计算开销。

③ 里程计头:

采用Transformer架构,巧妙地融合了视觉4D特征、IMU和轮速计数据。

这种多传感器融合策略弥补了单一传感器的不足,相比纯视觉方法,能提供更稳定、更精确的相对位姿估计,显著降低了运动估计的累积误差。

实验结果与性能

Astra系统已在真实机器人上部署和测试,覆盖仓库、办公楼和家庭等多种室内环境。

端到端任务成功率:

仓库:84.2%在仓库中,部分失败源于启动位置缺乏显著地标导致自定位失败,若排除这些极端点,成功率可升至91.2%。

办公楼:成功率高达99.1%。

Astra-Global 优势:

(1)在目标定位和自定位任务上成功率极高(>98%)。

(2)远超传统视觉地点识别(VPR)方法:

细节捕捉能力更强(能识别门牌号等细微特征)、对视角变化更鲁棒、定位精度更高。

(3)展现出强大的零样本泛化能力:

在仅使用仓库和办公室数据训练后,直接用于家庭环境,定位精度仍超过80%,经少量数据微调后可达到91.1%。

(4)强化学习(GRPO)的加入显著提升了泛化性和数据效率。

Astra-Local 优势:

(1)规划方面:

流匹配(FM)方法在轨迹质量和效率上优于其他生成方法(如ACT、Diffusion Policy)。新提出的掩码ESDF损失有效将碰撞率降低了约30%-50%。

(2)里程计方面:

多传感器融合的Transformer方案将轨迹误差从基线方法的5.46%降低到了1.92%,精度提升显著。

(3)4D编码器:

其预训练权重能显著提升下游任务(如3D占据栅格预测)的性能,且其预测未来环境的能力有助于规划更安全的路径。

小结

Astra引入创新的双模型架构:

Astra-Global解决了“去哪里”和“我在哪”的语义问题。

对于这一架构来说,探索更高效的地图压缩表示方法以保留更多语义;从单帧定位升级为主动探索和多帧时序推理,以应对无特征或高度重复的极端环境。

Astra-Local解决了“怎么去”的控制问题。

对于这一架构来说,持续提升模型在分布外(OOD)场景的鲁棒性,以减少对后备传统规划器的依赖;计划引入指令跟随能力,使机器人能更好地在动态、人机共融的环境中与人类交互。

Astra的成功标志着大型基础模型(LLM/VLM)与经典机器人技术深度融合的巨大潜力,为迈向真正通用的移动机器人迈出了坚实的一步。

Cogniplan

而接下来我们将介绍新加坡国立大学&同济大学在CoRL25的最新工作——CogniPlan,它通过生成式预测模型,像人类一样构建认知地图,推断未知区域的布局,并在多重假设中做出最优路径决策。

背景

路径规划是机器人的一项基本功能,它使移动机器人能够计算出到达指定目标的有效路径来完成任务。然而,在实际场景中,环境通常是事先未知的,这给决策带来了固有的挑战。

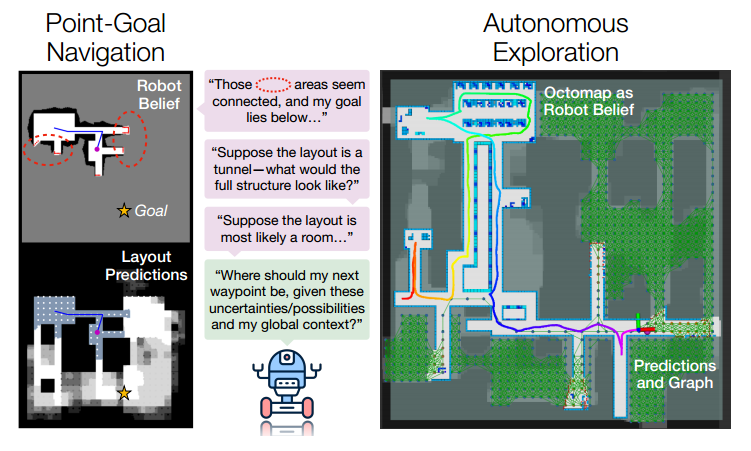

这项工作侧重于两个基本的耦合任务:自主探索和点目标导航,其中机器人必须在未知环境中规划,要么完全绘制空间地图,要么通过最短的可能路径到达特定目标。

在这种不确定性下进行有效推理,机器人必须基于部分且动态更新的地图信念行动,同时评估潜在信息增益,因为一些表面相似的选择可能带来截然不同的长期结果。

受到人类在导航中构建“认知地图”的能力启发,作者提出了 CogniPlan:一个由多种可能布局预测引导的全学习型路径规划框架。

整体框架

该框架首先采用轻量化 Wasserstein 生成对抗网络(WGAN) 在真实布局类型的条件下生成多种可能预测,捕捉布局不确定性,并输出二值化的自由空间/障碍物地图。

在前向推理时,通过输入多组布局条件向量生成多假设预测,每个假设对应部分观测环境的不同结构推测。

随后,CogniPlan 的图注意力网络利用这些假设进行推理,结合不确定性与信息增益,实时决定下一步的探索或导航目标点。

条件生成式图像修补

假设:

只要能生成一组多样化的布局预测,即便单次预测不完全准确。

多样且合理的布局预测也可以帮助规划器(planner)更好地权衡探索(exploration) 和利用(exploitation),并进行更长远(non-myopic)的路径规划。

带梯度惩罚的 Wasserstein GAN

作者在三类地图数据集(房间、隧道、室外)上训练了带梯度惩罚的 Wasserstein GAN。每个样本配有真实布局类型的条件向量(采用 one-hot 编码)。

该条件向量被扩展到与输入地图相同的空间尺寸,并与机器人的占据地图信念及未知区域掩码拼接后输入生成器。生成器输出预测的自由空间与障碍物分布。

损失函数:

生成器的损失函数包含一个对抗损失(来自判别器)和三个重构损失项:

① 整个预测图的L1损失。

② 使用空间折扣掩码加权的L1损失。该掩码给靠近已知区域的像素分配更高权重,因为这些区域的不确定性更低,且对机器人可通行性更为关键。

③ Dice损失(F1-score),用于衡量预测区域与真实值之间的重叠精度。

④ 推理与不确定性量化

生成器参数量<0.35M,这使得它即使在CPU上运行也能进行实时多次前向推理以进行不确定性估计。

条件生成式图像修补不确定性感知图规划(Uncertainty-Guided Planner)

图构建:

在预测布局中均匀采样节点并建立可见性边。节点特征包含:

① 是否位于已知/预测区域;

② 自由概率(多预测平均);

③ 前沿效用(可观测前沿数归一化);

④ 引导标记(是否位于至最近前沿的最短路径上)。

导航任务中额外引入朝向目标的方向向量。

规划网络:

基于图注意力的策略网络,由编码器和解码器组成:

编码器:通过多层掩码自注意力聚合邻居节点信息,获得全局上下文;

解码器:以上一步机器人位置为查询,通过注意力选择下一个航点。

价值网络:

结构与策略网络相同,但输出 Q 值,用于策略优化。训练中采用特权学习,将真实环境图作为输入,提升值函数估计精度。

训练流程

生成模型训练数据:在 Dungeon 环境中生成 3000 张随机地图,均匀覆盖三类布局。

探索规划器训练:在 6000 张地图上训练,利用 SAC 算法,节点采样间隔 9px,连边半径 26px。

导航规划器训练:在 2000 张地图上训练,设定起点与目标。

条件向量集合:通常采用 7 个布局条件向量。

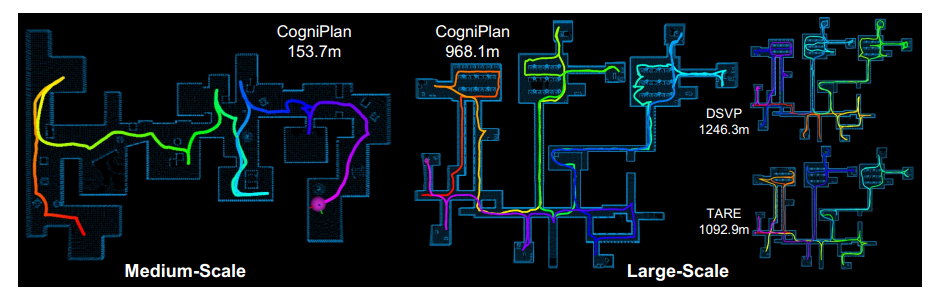

实验结果(Experiments)

模拟环境评估

(1)探索任务:

在 150 张未见过的地图上评估(房间/隧道/室外各 50 张)。与NBVP、TARE、ARiADNE+、Inpaint+TARE 等对比。

结论:CogniPlan 平均路径长度 306.4m,较次优方法缩短约 7–17.7%;在隧道与室外场景中优势尤为明显,表现为更少回溯与更连贯的路径。

(2)导航任务:

在 100 张地图上评估,对比 BIT*、DLite、CA、Inpaint+A。

结论:CogniPlan 平均路径长度 222.1m,优于大多数基线,并略超接近最优的 D*Lite。

(3)多预测数量影响:

当预测数从 1 增加到 4 或 7 时,性能显著提升,但收益逐渐饱和,说明少量多样化预测已足够。

真实平面图(KTH 数据集)

零样本评估:与 ARiADNE+ 和 MapEx 对比。

早期探索:MapEx 因直接最大化信息增益而占优。

后期覆盖率 >90%:CogniPlan 保持线性增长,避免冗余路径,整体优于基线。

鲁棒性测试:在不同初始位置下,CogniPlan 平均路径长度和标准差均最低,表明全局一致性更强。

硬件实验

在 30m×10m 实验室中部署,机器人配备 Livox Mid-360 激光雷达,最大速度 0.75 m/s。

平均探索时间约 6 分钟,路径长度约 100m。预测布局能实时辅助规划,轨迹平滑无明显回溯。

仿真验证(Gazebo)

中尺度场景(54×34m):与 Frontier、TDLE、TARE、HPHS 对比,CogniPlan 平均路径最短(170.9m),效率最高。

大尺度场景(130×100m):与 DSVP、TARE 对比,CogniPlan 探索体积效率提升至 5.25 m³/m,显著优于基线。

总结

Astra与CogniPlan虽然源自不同的技术路径,一个专注于视觉-语言多模态融合,一个致力于空间布局生成与图注意力规划。但它们共同指向——

构建具备人类式认知能力的自主导航系统。

无论是通过语言理解环境,还是通过生成式预测推断未知,多模态推理都是实现真正智能导航的必经之路。

Astra让机器人“听懂人话、看懂世界”,CogniPlan让机器人“想得远、走得稳”。

它们的结合,将为下一代具身智能系统提供可解释、可推理、可泛化的导航能力,最终让机器人在复杂、动态、未知的环境中,像人一样自由而高效地行动。

编辑|无意

审编|具身君

Ref:

1. Astra: Toward General-Purpose Mobile Robots via Hierarchical Multimodal Learning

2. CogniPlan: Uncertainty-Guided Path Planning with Conditional Generative Layout Prediction

工作投稿|商务合作|转载

:SL13126828869(微信号)

>>>现在成为星友,特享99元/年<<<

【具身宝典】具身智能主流技术方案是什么?搞模仿学习,还是强化学习?|看完还不懂具身智能中的「语义地图」,我吃了!|你真的了解无监督强化学习吗?3 篇标志性文章解读具身智能的“第一性原理”|解析|具身智能:大模型如何让机器人实现“从冰箱里拿一瓶可乐”?|盘点 | 5年VLA进化之路,45篇代表性工作!它凭什么成为具身智能「新范式」?动态避障技术解析!聊一聊具身智能体如何在复杂环境中实现避障

【技术深度】具身智能30年权力转移:谁杀死了PID?大模型正在吃掉传统控制论的午餐……|全面盘点:机器人在未知环境探索的3大技术路线,优缺点对比、应用案例!|照搬=最佳实践?分享真正的 VLA 微调高手,“常用”的3大具身智能VLA模型!机器人开源=复现地狱?这2大核武器级方案解决机器人通用性难题,破解“形态诅咒”!|视觉-语言-导航(VLN)技术梳理:算法框架、学习范式、四大实践|盘点:17个具身智能领域核心【数据集】,涵盖从单一到复合的 7 大常见任务类别||90%机器人项目栽在本地化?【盘点】3种经典部署路径,破解长距自主任务瓶颈!|VLA模型的「核心引擎」:盘点5类核心动作Token,如何驱动机器人精准操作?

【先锋观点】周博宇 | 具身智能:一场需要谦逊与耐心的科学远征|许华哲:具身智能需要从ImageNet做起吗?|独家|ICRA冠军导师、最佳论文获得者眼中“被低估但潜力巨大”的具身智能路径|独家解读 | 从OpenAI姚顺雨观点切入:强化学习终于泛化,具身智能将不只是“感知动作”人形机器人赛道:“爆单”是假,“饥饿”是真。

【非开源代码复现】非开源代码复现 | 首个能抓取不同轻薄纸类的触觉灵巧手-臂系统PP-Tac(RSS 2025)|独家复现实录|全球首个「窗口级」VLN系统:实现空中无人机最后一公里配送|不碰真机也不仿真?(伪代码)伯克利最新:仅用一部手机,生成大规模高质量机器人训练数据!

我们开设此账号,想要向各位对【具身智能】感兴趣的人传递最前沿最权威的知识讯息外,也想和大家一起见证它到底是泡沫还是又一场热浪?

欢迎关注【深蓝具身智能】👇

【深蓝具身智能】的内容均由作者团队倾注个人心血制作而成,希望各位遵守原创规则珍惜作者们的劳动成果。

投稿|商务合作|转载:SL13126828869(微信)

点击❤收藏并推荐本文

![2025年中国力矩传感器行业发展现状、竞争格局及趋势研判:下游机器人技术快速发展,带动力矩传感器规模达9.5亿元[图]](https://xtechcon-static.oss-cn-chengdu.aliyuncs.com/xtimes/xtimes/images/2025-11-22/69210b9e140b8.jpeg)