摘要

Abstract

Project Go-Big:互联网规模的人形预训练。 Figure 正在构建世界上最大、最多样化的人形预训练数据集,并通过与 Brookfield 的前所未有的合作伙伴关系加速,Brookfield 在全球拥有超过 100,000 个住宅单元。

项目地址:

https://www.figure.ai/news/project-go-big

在家庭中实现人类级智能的道路需要能够大规模地向世界学习的机器人。近日,Figure宣布 Helix 的两项关键进步,Figure 的视觉-语言-动作 (VLA) 模型用于通用人形控制:

Project Go-Big:互联网规模的人形预训练。 Figure 正在构建世界上最大、最多样化的人形预训练数据集,并通过与 Brookfield 的前所未有的合作伙伴关系加速,Brookfield 在全球拥有超过 100,000 个住宅单元。

零样本人类视频到机器人传输。Helix 实现了一个新的学习里程碑:在专门针对以自我为中心的人类视频进行训练后,Figure 机器人现在可以通过“去冰箱”等自然语言命令在杂乱的现实世界空间中导航——这在人形机器人技术中尚属首次。

互联网规模的人形预训练

机器学习的最大突破来自在大量、多样化的数据集上预训练大型神经网络:用于视觉的 ImageNet、用于语言的 Wikipedia 或用于生成视频模型的 YouTube。与视觉或语言不同,机器人技术缺乏大规模的等价物——没有“机器人行为的 YouTube”。

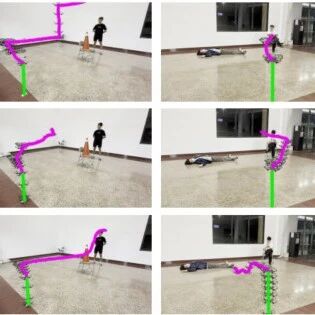

传统上,教授机器人新技能需要昂贵的演示、手工编码的程序或无法捕捉现实世界的混乱的紧凑舞台环境。然而,人形机器人具有独特的结构优势:它们的视角和运动学反映了我们自己的视角和运动学,从而可以直接从日常人类视频中传递知识(视频 1)

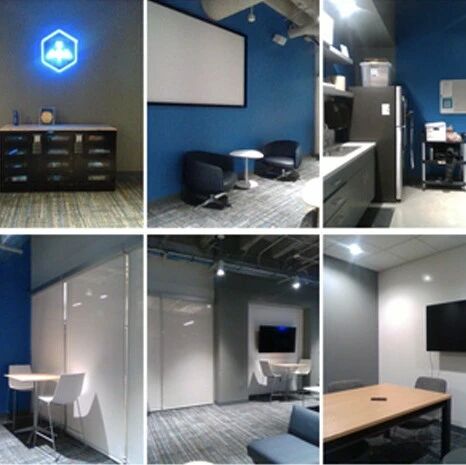

这就是 Project Go-Big 背后的愿景,即 Figure 的大规模人形预训练数据收集计划(视频 2)。昨天,我们宣布与布鲁克菲尔德资产管理公司建立史无前例的合作伙伴关系。Brookfield 1 万亿美元的全球资产基础—— 超过 100,000 个多样化的住宅单元 、5 亿平方英尺的商业办公空间和 1.6 亿平方英尺的物流空间——将通过以前所未有的规模和多样化的现实环境捕捉人类目标导向的行为,帮助加速 Project Go-Big。

Figure 已经开始在布鲁克菲尔德环境中收集数据,并将在未来几个月内继续扩大该计划的规模。

直接将人类视频传输到机器人

Helix 以前专注于上半身作任务,例如衣物折叠 、洗碗机装载和包裹重新定位 。但除了纵之外,人形机器人还需要能够智能导航才能在家中发挥作用——在杂乱中寻找路径、重新定位任务以及在人和物体周围流畅地移动。我们很高兴地与大家分享,Project Go-Big 已经为 Helix 带来了一个有希望的初步学习成果: 从人类视频直接转移到机器人行为 。我们使用 100%以自我为中心的人类视频数据,这些数据是人们在真实的布鲁克菲尔德家庭中行为时被动收集的,我们训练了 Helix 将人类导航策略直接转化为机器人控制。值得注意的是,这种方法不需要任何机器人演示 。

结果

语音导航 :Helix 现在可以直观地响应对话命令,例如“走到厨房的桌子前”或“去给植物浇水”,从像素自动生成闭环控制,以导航复杂、杂乱的家庭环境(视频 3)。

单一、统一的模型 :One Helix 网络现在可以输出高速率灵巧的作和导航命令,无需单独的、特定于任务或特定于数据源的系统(图 1)。

零样本人到机器人传输 :据我们所知,这是人形机器人第一次仅使用人类视频进行端到端学习——从图像和语言到低级 SE(2) 速度命令。不需要特定于机器人的数据或训练。

结论

我们正在迅速接近一个人形机器人以人类基本方式理解家庭并与之交互的未来——以自然语言为主要界面在复杂的环境中导航、纵物体和推理。

我们与 Brookfield 的合作使我们能够探索互联网规模的具身数据集在运动和纵方面的全部潜力。我们已经看到了好处:这是史无前例的、零样本的交叉实施,从人类视频转移到现实世界中的机器人导航。

如果您想帮助构建数据管道、模型和系统,将 Helix 扩展到数百万个机器人,请加入我们。 人形机器人的未来始于家庭,我们现在正在建设这个未来。

往期文章