点击下方卡片,关注“具身智能之心”公众号

作者丨Xiaomeng Ye等

编辑丨具身智能之心

本文只做学术分享,如有侵权,联系删文

>>

更多干货,欢迎加入国内首个具身智能全栈学习社区:(戳我),这里包含所有你想要的。

研究背景与核心问题

具身AI的sim-to-real困境

具身AI(如导航机器人)的训练高度依赖仿真环境,但现有方案始终面临保真度与成本的矛盾:

全合成环境(如HSSD)虽易获取,但缺乏真实世界的细节与复杂性,导致策略在真实场景中性能骤降; 高保真真实场景重建(如HM3D、Matterport3D)依赖昂贵专业设备(如Matterport相机),且重建流程繁琐,无法覆盖多样化的部署环境(如大学教室、社区休息室)。

这种矛盾直接导致sim-to-real迁移难——仿真中表现优异的策略,在真实机器人上往往无法落地,成为具身AI实用化的核心瓶颈。

现有技术的未被挖掘潜力

3D高斯Splatting(GS)技术近年在场景重建中展现突破:能从普通设备捕获的图像生成高保真3D表征,且渲染速度快(如DN-Splatter通过深度和法向量正则化进一步提升网格质量)。但此前相关研究(如SplatNav、GaussNav)存在明显局限:

SplatNav仅针对无人机的点/语言目标导航,未实现端到端训练,也未在真实环境验证; GaussNav聚焦仿真环境下的图像目标导航,缺乏真实机器人评估与sim-to-real迁移能力。

该研究是首个针对室内图像目标导航,实现端到端策略训练、真实机器人评估、明确sim-to-real迁移的GS-based方案,填补了低成本真实场景重建与具身导航结合的空白。

核心方法:EmbodiedSplat的四阶段Pipeline

研究设计了从真实场景捕获到机器人部署的完整流程,核心是通过手机低成本捕获+3D GS高保真重建,构建与真实环境对齐的仿真训练场景,最终实现策略的个性化微调与高效sim-to-real迁移(参考Figure 2)。

阶段1:场景捕获(Scene Capture)

硬件与工具:使用iPhone 13 Pro Max,通过Polycam应用记录RGB-D数据——Polycam提供辅助界面确保场景覆盖完整,无需云台等额外设备,降低操作门槛(单一场景捕获仅需20-30分钟)。 数据处理:用Nerfstudio筛选1000张低模糊的对齐RGB-D帧,同时提取相机姿态;保留Polycam生成的网格(记为POLYCAM mesh),用于后续与GS重建网格对比。

阶段2:网格重建(Mesh Reconstruction)

核心技术:采用DN-Splatter实现3D GS训练与网格生成,关键优势是通过深度正则化(λd=0.2) 和法向量正则化(选用Metric3D-V2编码器,比Omnidata生成更高质量网格)维持几何一致性,减少重建漏洞。 流程细节:GS训练迭代30000次后,通过泊松重建将3D高斯转换为.ply网格,再用Blender转换为Habitat-Sim支持的.glb格式(需关闭+Y Up转换以符合仿真规范),最终生成的网格记为DN mesh。 两种网格差异:POLYCAM mesh视觉保真度更高(色彩真实、表面平滑),DN mesh因依赖GS学习的颜色,可能存在色彩暗淡或局部漏洞(参考Figure 16、17)。

阶段3:仿真训练(Training with Habitat-Sim)

ImageNav Episode生成

导航区域筛选:选择场景中最大的navmesh岛(避免将桌子、床等物体误判为可导航区,确保覆盖主要活动空间)。 Episode数量设计:由于Captured场景(大学教室、休息室)规模小于HM3D(公寓场景),每个场景仅生成1000个训练Episode和100个评估Episode(HM3D为每个场景10000个训练Episode)。 有效性校验:确保起点与目标点可达、距离非零,且navmesh岛半径超2m,避免无效导航路径。

策略训练与微调

基础架构: 视觉编码器:采用VC-1-Base,输入图像 resize 至160×120,通过压缩层(2D卷积+组归一化)生成特征嵌入; 策略网络:2层LSTM,输入包括前一动作嵌入、观测图像嵌入、目标图像嵌入,输出4个离散动作(前进、左转、右转、停止); 优化框架:用DD-PPO训练,AdamW优化器(权重衰减1e-6),每个rollout生成64帧,2个PPO epoch(每epoch含2个mini-batch)。 奖励函数:采用多组件复合奖励(参考公式1),平衡成功导向、路径效率与碰撞规避:

其中,(成功奖励)、(角度奖励)、(碰撞惩罚)、(步长惩罚),确保策略优先选择短路径且避免碰撞。

微调策略:预训练策略(HM3D或HSSD预训练)额外训练20M步,LSTM学习率2.5e-6,视觉编码器学习率6e-7——低学习率设计避免覆盖预训练的通用导航能力,仅适配当前场景。

阶段4:真实部署(Real-World Deployment)

硬件与推理架构:使用Stretch机器人(无内置GPU),通过Flask服务器连接远程集群进行策略推理——机器人将实时观测图像与目标图像发送至集群,接收动作指令(参考Figure 13)。

评估流程:

随机选择起点与目标点,在目标点拍摄目标图像,用彩色胶带标记位置; 机器人从起点出发,Episode终止条件为输出停止动作或达到100步(真实场景中步数限制严于仿真的1000步); 成功判定:用卷尺测量机器人最终位置与目标点距离,≤1m即为成功(参考Figure 14、15)。

实验设计与关键结果

研究围绕三个核心问题展开实验,数据集涵盖预训练场景(HM3D、HSSD)与评估场景(Captured大学场景、MuSHRoom室内场景),核心验证“零样本性能-微调提升-sim-to-real迁移”的完整链路。

问题1:预训练策略在新场景的零样本性能如何?

零样本性能指预训练策略不微调,直接在Captured/MuSHRoom场景的仿真评估结果,核心发现如下:

场景规模主导性能:HM3D预训练策略在小场景(如conf a、conf b会议室)表现优异(DN mesh 85%-88%,POLYCAM mesh 79%-82%),但在大场景(如classroom、lounge)性能骤降(DN mesh 50%-53%,POLYCAM mesh 42%-76%)(参考Figure 4)——原因是HM3D以公寓场景为主,与大学环境分布差异大,策略无法适配新场景的布局与视觉特征。 合成数据集泛化更差:HSSD预训练策略零样本性能远低于HM3D,如classroom场景成功率仅1%(DN/POLYCAM均如此),lounge场景POLYCAM mesh仅14%(参考Figure 5)——印证合成环境缺乏真实细节,导致策略难以泛化到真实世界结构。

MuSHRoom场景的特殊性:HM3D预训练在MuSHRoom的小场景(sauna、honka)成功率达95%(仅DN mesh),但大场景(activity)性能下降,说明场景规模对零样本性能的影响具有普适性。

问题2:微调是否提升策略性能?

针对预训练策略在Captured/MuSHRoom场景进行20M步微调后,结果显示:

全场景性能跃升:HM3D预训练策略微调后,所有场景成功率达90%+(如conf a DN mesh 99%,classroom POLYCAM mesh 96%)(参考Figure 6);HSSD预训练策略微调后,多数场景成功率达80%+(如lounge DN mesh 84%,conf b POLYCAM mesh 99%)(参考Figure 7)。

大场景提升最显著:classroom、lounge等与预训练数据分布差异大的场景,微调后性能提升幅度远超小场景——说明微调能有效修正策略对“新场景布局-视觉特征”的认知,填补分布外场景的适配缺口。 效率优势:微调仅需20M步,远少于从头训练的100M+步,且能保留预训练的通用导航能力(如避障、路径规划),兼顾效率与泛化。

问题3:仿真性能能否迁移到真实世界?

在lounge场景用Stretch机器人评估,结果直接验证sim-to-real迁移效果(参考Figure 8):

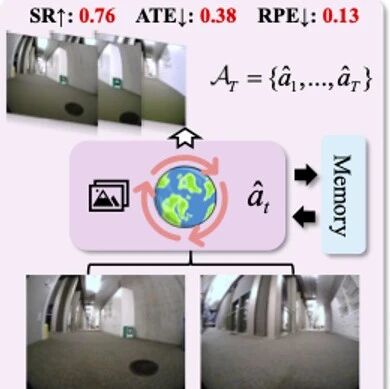

零样本迁移有限:HM3D预训练策略真实世界成功率仅50%(低于其在仿真中的零样本性能),HSSD仅10%——进一步凸显sim-to-real差距,仿真中的“完美环境”无法覆盖真实世界的光照变化、传感器噪声与机器人误差。 微调显著提升迁移能力:HM3D预训练策略微调后(DN/POLYCAM mesh)真实成功率达70%;HSSD微调后(POLYCAM mesh 50%,DN mesh 40%),性能提升4-5倍——证明基于重建场景的微调,能让策略学习到与真实环境对齐的特征,缩小sim-to-real差距。 sim-to-real相关性高:重建网格的sim-to-real相关系数(SRCC)达0.87-0.97(参考Figure 1)——说明仿真中的性能可有效预测真实世界表现,验证了3D GS重建场景的保真度足以作为sim-to-real的桥梁。

消融实验与深度分析

大规模预训练是否必要?

通过“过拟合”实验(策略从头训练,仅在单个Captured/MuSHRoom场景的网格上训练~100M步)发现:

仿真性能优异但真实泛化差:过拟合策略在仿真中成功率接近100%(参考Figure 9),但真实lounge场景中,仅POLYCAM mesh训练的策略达50%成功率,DN mesh仅10%——说明视觉保真度(POLYCAM更优) 比预训练更影响真实性能,且过拟合策略仅适配单一场景,缺乏泛化能力。

预训练的不可替代性:预训练策略微调后,既能适配新场景,又能应对真实环境的光照、噪声干扰,而过拟合策略无法迁移到其他场景——证明大规模预训练能提供通用导航知识,是个性化微调的基础。

场景规模与PSNR如何影响性能?

对HM3D零样本性能与场景属性的相关性分析显示(参考Figure 10):

场景规模负相关:零样本成功率随起点-目标点平均最短距离(场景规模指标)增大而下降——大场景导航路径更长、决策节点更多,策略更易因“布局记忆偏差”失败。 PSNR正相关:零样本成功率随3D GS的验证PSNR(保真度指标)升高而提升——PSNR越高,场景细节越丰富(如纹理、物体轮廓),策略越易通过视觉特征匹配目标位置。 捕获稳定性的影响:MuSHRoom场景因使用云台捕获,PSNR普遍高于Captured场景,对应零样本性能更优——提示优化捕获设备稳定性(如添加云台)可进一步提升重建质量与策略性能。

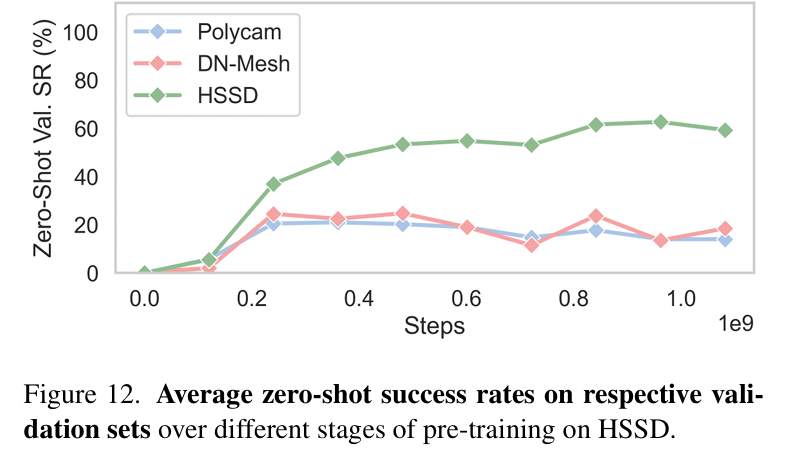

持续预训练是否持续提升泛化能力?

跟踪预训练步数与零样本性能的关系发现(参考Figure 11、12):

性能Plateau现象:HM3D预训练至400M步后,Captured场景零样本性能停止提升甚至下降;HSSD预训练至300M步后,性能也进入平台期——说明过度训练会导致策略过拟合预训练数据分布,反而损害对新场景的泛化能力。 预训练数据的导向性:HM3D预训练时,POLYCAM mesh的零样本性能略高于DN mesh;HSSD预训练时趋势相反——证明预训练数据的场景属性(真实vs合成)会影响策略对不同重建网格的适配性,真实预训练数据更偏好高保真网格(POLYCAM)。

参考

[1]EmbodiedSplat: Personalized Real-to-Sim-to-Real Navigation with Gaussian Splats from a Mobile Device