智猩猩Robot整理

在具身智能的宏伟蓝图下,视觉-语言导航(Vision-Language Navigation, VLN)是连接虚拟与现实的关键一环。它要求智能体不仅能“看懂”世界,更能依据人类指令“行动”于其中。尽管多模态大语言模型(MLLM)为VLN注入了前所未有的活力,但其记忆机制却日益成为发展的桎梏。传统的显式记忆——无论是文本拓扑图还是历史图像序列——都面临着空间信息失真、计算开销巨大和记忆无限膨胀的“三座大山”。

为彻底打破这一瓶颈,阿里巴巴高德地图与西安交通大学联合团队从人类认知科学中汲取灵感,重磅推出全新的VLN框架——JanusVLN。该框架首次提出双重隐式记忆(Dual Implicit Memory)范式,通过将语义理解与空间感知解耦,并将其编码为两个高效、恒定大小的神经记忆表征,引领VLN研究迈入一个崭新的阶段。JanusVLN仅需单目RGB视频流,便能实现卓越的三维空间推理,在性能上全面超越现有SOTA方法,为构建更接近人类认知能力的具身智能体铺平了道路。

论文标题:《JanusVLN: Decoupling Semantics and Spatiality with Dual Implicit Memory for Vision-Language Navigation》

论文链接:https://arxiv.org/abs/2509.22548

项目主页:

https://miv-xjtu.github.io/JanusVLN.github.io/

代码地址:

https://github.com/MIV-XJTU/JanusVLN

1

挑战:当前VLN记忆机制的根本局限

长时序、连续的导航任务对智能体的记忆能力提出了严苛的挑战。然而,当前基于MLLM的VLN方法在记忆设计上存在根本性的缺陷:

1. 空间感知的缺失:将三维视觉观测压缩为离散文本描述(如“前方有一张桌子”),会不可逆地丢失物体间的精确方位、距离等连续几何关系,导致智能体“知其然,而不知其所以然”。

2. 计算效率的瓶颈:依赖历史图像帧的方法,在每一步决策时都需对不断增长的观测序列进行重复编码和推理。这种随步数线性增长的计算负担,严重阻碍了模型的实时应用潜力。

3. 记忆的无限膨胀:无论是文本还是图像,显式记忆的规模会随着导航轨迹的延长而持续累积,形成“记忆泥潭”,使得从中高效检索关键信息变得异常困难。

究其根源,在于现有模型大多沿用为2D图文任务设计的视觉编码器,忽视了RGB图像作为三维世界投影所蕴含的丰富几何线索,导致模型“精于语义,拙于空间”。

2

破局:JanusVLN的双重隐式记忆范式

受人脑左右半球分别处理语义与空间信息并形成高效隐式记忆的启发,JanusVLN构建了一套全新的记忆系统,其核心在于“解耦”与“隐式”。

- 语义与空间解耦:JanusVLN创新地将记忆系统一分为二:语义记忆(Semantic Memory)负责回答“这是什么”,空间几何记忆(Spatial-Geometric Memory)负责回答“它在哪里”。二者协同工作,为智能体提供全面而精准的环境认知。

- 高效的隐式表征:JanusVLN摒弃了存储原始高维数据(如图像、文本)的显式做法。它将两种记忆均建模为经过神经网络深度处理后的键值(KV)缓存。这种紧凑、定长的神经表征构成了高效的隐式记忆,从根本上解决了记忆膨胀问题。

- 低成本的3D感知:JanusVLN集成了一个预训练的3D视觉几何基础模型(VGGT),使其仅通过普通的单目RGB视频流,就能推断出场景的三维结构信息。这极大地降低了对昂贵传感器(如LiDAR、深度相机)的依赖,提升了方案的普适性和经济性。

3

三大创新驱动性能飞跃

JanusVLN的卓越性能源于其三大紧密耦合的创新设计:

1. 解耦的感知编码器:框架采用双编码器架构。其中,强大的2D视觉语义编码器(基于Qwen2.5-VL)专注于提取高级语义特征,而新颖的3D空间几何编码器(基于VGGT)则从RGB视频中挖掘深层的三维结构信息,二者为后续的记忆构建提供了高质量的输入。

2. 双重隐式神经记忆:我们将语义与空间几何编码器中注意力模块的键值对(KV)缓存直接作为隐式记忆的载体。这种经深度网络提炼的神经表征,以极低的存储成本,高效地编码了历史观测中的关键信息。

3. 恒定开销的增量更新:为实现记忆的恒定大小,我们设计了一种混合增量更新策略。该策略巧妙地结合了保留近期信息的“滑动窗口”与锚定全局起点的“初始窗口”。在导航的每一步,模型仅需处理当前帧,并通过注意力机制与固定的隐式记忆高效交互,实现了对历史信息的“零重复计算”复用,大幅提升了推理速度。

4

实验验证:全面领先的SOTA性能

我们在两大权威VLN基准VLN-CE和RxR-CE上对JanusVLN进行了全面评估,实验结果充分证明了其优越性。

定量分析亮点:

- 降维打击:相较于依赖全景图、深度图等多种昂贵输入的多模态方法,JanusVLN仅凭单目RGB输入,就在关键的成功率(SR)指标上实现了10.5%至35.5%的惊人提升。

- 范式优越性:与同样使用RGB输入但采用显式记忆(如历史帧、文本地图)的SOTA方法(如NaVILA, StreamVLN)相比,JanusVLN在SR指标上取得了3.6%至10.8%的显著优势,且使用了更少的辅助训练数据。

- 卓越的泛化能力:在更具挑战性、指令更复杂的RxR-CE数据集上,JanusVLN同样刷新了SOTA记录,SR指标领先此前最佳方法3.3%至30.7%,展现了其强大的跨场景适应性。

定性分析洞察:

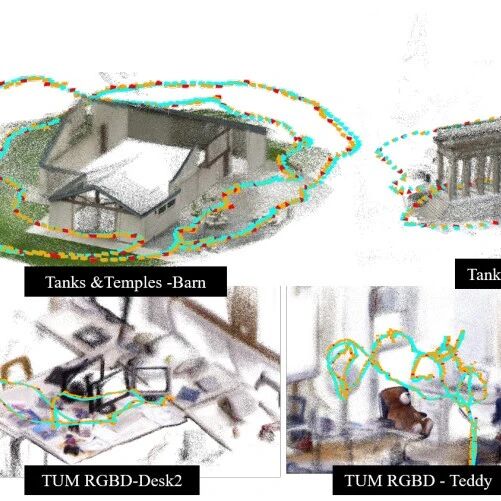

在需要精细空间推理的复杂任务中(如下图所示),例如分辨“最远的黄色凳子”或理解“停在绿色盆栽旁边而非前方”等指令,JanusVLN凭借其强大的空间几何记忆,展现出对三维环境精准的理解和决策能力,成功完成挑战。

5

总结与展望

本文提出的JanusVLN框架,通过引入开创性的双重隐式神经记忆范式,从根本上解决了传统VLN方法在记忆机制上的核心弊病。通过将语义与空间感知解耦,并结合高效的增量更新策略,JanusVLN在仅使用单目RGB视频的情况下,实现了前所未有的三维空间推理能力和计算效率。

JanusVLN的成功,不仅是在VLN基准上刷新了SOTA纪录,更重要的是,它推动了VLN研究范式从“2D语义主导”向“3D空间与语义协同”的深刻变革。我们相信,这一全新的记忆范式将为开发下一代具备高级空间认知能力的具身智能体提供坚实的基础和清晰的指引。

END

智猩猩矩阵号各专所长,点击名片关注