作者简介:本文第一作者为卡耐基梅隆大学机器人所研究生 Tonghe Zhang,主要研究方向为机器人操作大模型和全身控制算法。合作者为德克萨斯大学奥斯汀分校博士生 Sichang Su, 研究方向为强化学习和通用机器人策略。指导教师是清华大学和北京中关村学院的 Chao Yu 教授以及清华大学 Yu Wang 教授。

今年,流匹配无疑是机器人学习领域的大热门:作为扩散模型的一种优雅的变体,流匹配凭借简单、好用的特点,成为了机器人底层操作策略的主流手段,并被广泛应用于先进的 VLA 模型之中 —— 无论是 Physical Intelligence 的  ,LeRobot 的 SmolVLA, 英伟达的 GR00T 和近期清华大学发布的 RDT2。

,LeRobot 的 SmolVLA, 英伟达的 GR00T 和近期清华大学发布的 RDT2。

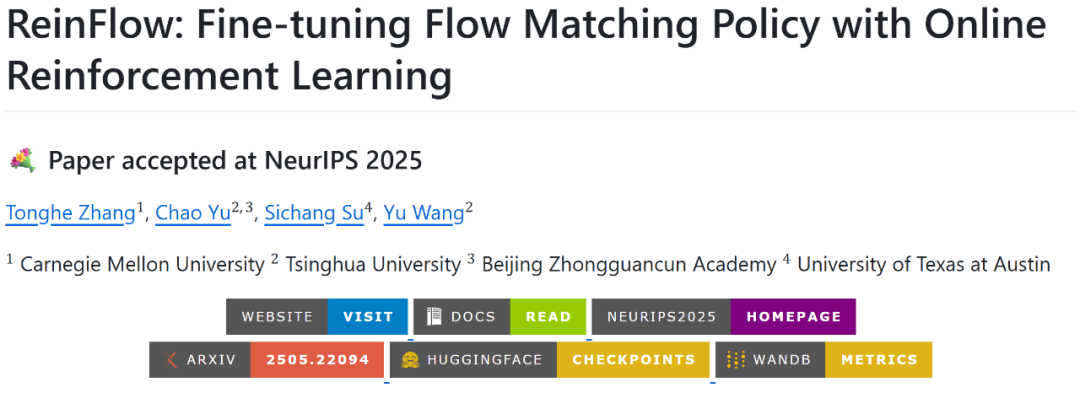

想要进一步增强开源 VLA 模型的能力,除了增加数据多样性,强化学习也是一种高度有效的方法。来自卡内基梅隆大学、清华大学和德克萨斯大学奥斯汀分校的研究团队提出了一个用于微调流匹配策略的在线强化学习框架 ReinFlow, 该工作已被 NeurIPS 2025 接收,并开源了详细的复现教程,包括代码、训练权重、和训练结果。

论文标题:ReinFlow: Fine-tuning Flow Matching Policy with Online Reinforcement Learning

论文链接:https://arxiv.org/abs/2505.22094

项目主页:https://reinflow.github.io

开源资源(代码、模型、数据、W&B 训练记录)https://github.com/ReinFlow/ReinFlow

ReinFlow 的算法特点

理论基础:基于策略梯度理论推导,将确定性流转换为离散时间马尔可夫过程,直接优化整条流匹配链;

训练高效:相比 DPPO 节省 60% 以上训练时间,支持少步甚至单步推理;

实验验证:在多个基准任务上相较预训练模型取得了显著性能提升;

复现友好:提供完整训练教程、数据集、检查点、WandB 指标,支持许多 legged locomotion 和 manipulation benchmark, 以及在 SimplerEnv 中使用规模化并行仿真微调

模型。

模型。

ReinFlow 核心原理

ReinFlow 是一个针对常微分方程策略的通用策略梯度算法。想要进行策略梯度优化,首先要设法获取动作的边缘概率分布  。对于流匹配模型而言,这与推理时动作生成的机理相关。流匹配策略每一步推理时进行了如下步骤:

。对于流匹配模型而言,这与推理时动作生成的机理相关。流匹配策略每一步推理时进行了如下步骤:

流匹配模型推理公式:

第一步动作

来自高斯噪声;

来自高斯噪声; 对速度积分得到中间动作;

对速度积分得到中间动作;最后一步动作

与环境交互。

与环境交互。

如果使用流匹配的理论公式,我们可以计算流策略的最终动作的似然函数。但是由于流匹配动作通过积分来定义,这个方法计算相当复杂,而且存在估计噪声,并不适合于强化学习。那么有没有办法可以简单获得流匹配策略推理时候的似然函数呢?其实可以, 但是要做一些小改动……

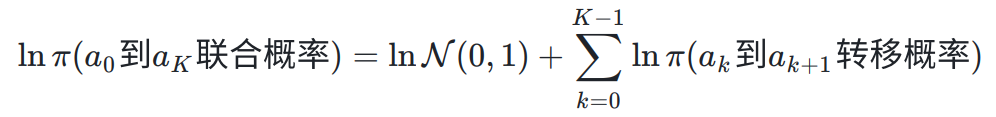

流匹配模型的推理是一个马尔科夫过程。如果我们贮存所有的中间动作,虽然难以获得最终动作的最终动作的边缘分布,但是可以用链式法则获得扩散链条的联合概率分布:

但是由于使用常微分方程进行积分,预训练流匹配模型的每步转移概率都是狄拉克函数, 据此仍然无法导出数值稳定的计算公式。因此,在 ReinFlow 中,我们向流策略的确定性路径中注入少量可学习的噪声,将其转移过程改回一个随机的扩散过程:

其中,第一项是预训练得到的速度,对应随机微分方程的漂移项;第二项是端到端训练的噪声注入网络,对应微分方程的扩散项。这样,由于相邻扩散步的转移概率都是高斯分布,流匹配的联合概率便可以被严格计算出来:

好消息是,我们的研究表明利用联合概率也可以进行策略梯度优化。根据如下定理,我们可以使用多种经典的策略梯度方法对流匹配策略进行强化学习。

虽然引入噪声改变了流匹配模型的轨迹,但是我们把噪声控制到较小范围内,以减少与预训练策略的偏离,防止微调时性能大幅受损。但同时,我们也为噪声设置强度下限,以鼓励适当的探索。另外,ReinFlow 虽然引入了额外的噪声网络,但是其参数量远小于预训练的速度场,并且与之共用视觉特征:这样可以减少微调时带来的额外开销。

任务评测

ReinFlow 是一个通用的框架。原理上,ReinFlow 可以适用于所有常微分方程定义的策略,比如 Rectified Flow 和 Shortcut Models,甚至支持极少步数下,如 1,2,4 步时的推理。而且,更新公式可以适用于几乎所有强化学习梯度算法,比如 PPO。

足式运动控制

在 D4RL 足式运动控制任务中,ReinFlow 微调后的 Rectified Flow 策略取得了平均 135.36% 的净性能增长。与当前的扩散 RL 微调方法 DPPO 相比,ReinFlow 在保持类似性能的同时,可以极大减少扩散步骤,从而节省了微调所用的 82.63% 的墙钟时间。

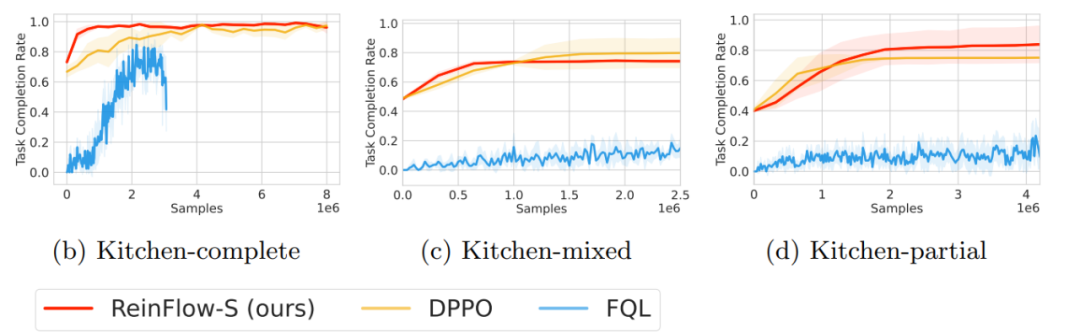

长程操作任务

在接收稀疏奖励和高维输入的操作任务中(Franka Kitchen、Robomimic) ,ReinFlow 微调的 Shortcut Model 策略在 4 步甚至 1 步去噪的情况下,比预训练模型平均净增了 40.34% 的成功率。其性能与使用 DPPO 微调的 DDIM 策略相当,但训练时间平均节省 23.20%。

VLA + 大规模并行强化学习

除了标准基准,研究团队还成功地使用 ReinFlow 利用 ManiSkill3 框架在 SimplerEnv 环境中微调了  模型。 在包含 25 种不同物品和、十余种桌面设置和上百种初始化位姿的高度随机化场景中,ReinFlow 可以大幅提高

模型。 在包含 25 种不同物品和、十余种桌面设置和上百种初始化位姿的高度随机化场景中,ReinFlow 可以大幅提高  模型的抓取成功率。

模型的抓取成功率。

消融实验

研究团队进行了详细的消融研究,研究以下因素对训练结果的影响:

1. 数据扩展 vs RL 微调:实验显示仅靠增加数据或推理步数较快达到性能瓶颈,而 RL 微调能进一步提升性能。

2. 时间采样策略:ReinFlow 对均匀、Logit-normal 和 Beta 分布等多种时间采样方式都表现良好的性能。

3. 噪声条件和大小:同时以状态和时间为条件生成噪声,有助于产生更多样化的动作。噪声过小训练会陷入瓶颈,一定阈值后可以探索的新策略。

4. 熵正则化:可以进一步促进探索。

保姆级开源

ReinFlow 的 GitHub 项目已经全面开源,并在积极维护中。欢迎通过邮件或 GitHub 与作者交流。项目包含了:

完整代码库

支持 Rectified Flow、Shortcut Models 等多种流模型;

涵盖 OpenAI Gym(D4RL)、Franka Kitchen、Robomimic 等多个经典 RL 环境;

详细的安装指南和使用教程。

模型 Checkpoints

提供所有实验的预训练模型;

包含行为克隆和 RL 微调后的权重;

支持一键加载和评估。

WandB 指标

公开所有实验的训练曲线(损失、奖励、学习率等);

可直接访问:https://wandb.ai/reinflow/projects;

便于社区下载基线和本方法测试结果,进行公平验证和对比。

详尽文档

完整复现实验的步骤:https://github.com/ReinFlow/ReinFlow/blob/release/docs/ReproduceExps.md

复现论文图表的指南:https://github.com/ReinFlow/ReinFlow/blob/release/docs/ReproduceFigs.md

关键超参数说明:https://github.com/ReinFlow/ReinFlow/blob/release/docs/Implement.md

添加自定义数据集 / 环境:https://github.com/ReinFlow/ReinFlow/blob/release/docs/Custom.md

常见问题解答:https://github.com/ReinFlow/ReinFlow/blob/release/docs/KnownIssues.md

未来展望

ReinFlow 将在未来公布更多结果,包括:

发布更多大型视觉语言模型微调结果;

支持用在线 RL 微调 Mean Flow;

研究如何使用该方法进行 sim2real 和真机强化学习微调。

欢迎大家关注!

© THE END

转载请联系本公众号获得授权

投稿或寻求报道:liyazhou@jiqizhixin.com