上周具身智能之心和大家聊到大多数同学没有真机测试的问题(),但其实现在具身VLA模型爆发的速度非常快,各个高校、研究所和企业基本上都是在自己重复造轮子,互相验证起来非常麻烦。尤其是在做论文复现的时候,服务器上要配很多环境,自己复现的模型往往还达不到原算法的性能,数据也要备份很多份供不同的框架使用,这种重复低效的问题我们也收到过很多同学的反馈。

另一个现实的问题是,个人开发者和小规模的科研团队没有能力开发和维护一套成熟的通用算法框架,所以一般需要工业界或者顶尖的科研团队来推进。近日Dexmal原力灵机就推出了Dexbotic — 一个集成了主流VLA模型的通用易扩展的开源工具箱,向着解决通用具身大脑迈出了关键的一步。

Dexbotic涵盖Manipulation Policy和Navigation Policy等主流的预训练模型,且支持云端&本地一体化训练及全链路机器人的训练部署,开箱即用!此外,Dexbotic统一了具身智能的操作和导航,已经为机器人全身控制做了预留。

官网:https://dexbotic.com/ Paper:https://dexbotic.com/dexbotic_tech_report.pdf GitHub:https://github.com/Dexmal/dexbotic Hugging Face:https://huggingface.co/collections/Dexmal/dexbotic-68f20493f6808a776bfc9fc4

1. VLA开发缺少成熟的统一开源框架

当前,VLA推动具身智能领域取得显著进展,但研究落地却受限于严重的碎片化问题。不同团队采用各异的深度学习框架与模型架构,模型对比时需重复配置多套实验环境与数据格式,开发流程繁琐且效率低下;更关键的是,多数现有VLA模型(如OpenVLA、CogACT)基于Llama2等基座VLM构建,无法充分利用Qwen3等最新LLM的强大表征能力,导致 “具身大脑” 能力受限,直接限制了算法上限;此外,不同策略的优化程度难以统一,也造成了不公平的性能对比,这些痛点共同催生了对成熟统一开源VLA框架的迫切需求。基于此,Dexbotic应运而生。

下图是Dexbotic的整体示意图,有几个重要的feature:

引入了Dexdata格式来统一不同的实施例。 在模型层,Dexbotic通过统一的模块化VLA框架集成了开源视觉编码器、LLM和Action Head。 基于提供的DexboticVLM,开发人员可以开发现有的VLA策略和自定义策略。 基于已有策略,我们进一步提出了实验层以实现快速验证。 一些云服务和客户GPU都支持训练管道和推理服务。

2. 具身领域VLA统一框架:Dexbotic正式推出

很多从CV时代过来的同学,一定对mmdetection的印象非常深刻。在2018年以前,开源的检测算法框架五花八门,和当下具身领域面临的问题非常相似。所以mmdetection一经推出便迅速得到青睐。如今,Dexmal原力灵机推出的Dexbotic以“统一VLA架构”为核心,成为具身智能领域的“mmdet时刻”,构建了从数据处理到模型开发再到实验落地的全链路解决方案。

Dexbotic的核心架构则是三大数据层、模型层与实验层,相比开源的一些框架,实验层的设计的进一步做了补充和升级 —— 不再依赖 yaml 文件进行全局配置,修改需调整完整文件,而 Dexbotic 以 “基础脚本 + 差异参数” 为核心,完全贴合开发者视角,大幅降低操作门槛。下面我们来一一拆解:

数据层:Dexdata格式实现多源数据统一

为解决不同本体机器人数据格式不兼容、存储成本高的问题,Dexbotic设计了Dexdata格式,实现多源数据的高效统一。

该格式由“视频目录+jsonl目录”组成:视频目录存储mp4格式的机器人任务视频,jsonl目录则对应每个任务片段的详细数据——单个jsonl文件记录单段机器人episode的信息,包含多视角图像、机器人状态、文本指令等帧级别细节,且自动生成index_cache.json文件用于快速检索元数据。

相较于其他框架的数据格式,Dexdata格式大幅节省了模型训练的存储成本,同时为多机器人的训练与部署提供了统一数据基础,这种设计对个人开发者非常友好,省去了非常繁琐的数据准备工程。下图是Dexdata数据的示意图:

模型层:DexboticVLM 构筑核心基础

模型层以DexboticVLM为核心基础模型,采用“视觉编码器+投影器+LLM”的经典结构:

选用CLIP作为视觉编码器生成视觉token; 通过两层MLP投影器将视觉令牌对齐至文本空间; 再以Qwen2.5作为LLM处理视觉与文本token。

其训练流程参考LLaVA:先冻结视觉编码器与LLM,仅训练投影器实现跨模态对齐,随后更新全网络参数,训练数据涵盖LLaVA与Cambrian数据集。基于DexboticVLM,Dexbotic进一步提供两类预训练模型:

一是面向通用VLA策略的离散预训练模型(如Dexbotic-Base) ,基于Open-X Embodiment子集、RLBench等仿真数据及UR5真实数据训练,将连续动作离散为256个bin,可直接用于离散或连续动作学习的微调; 二是面向特定策略的连续预训练模型,包括单臂版(如Dexbotic-CogACT,基于8种单臂机器人的52项任务数据训练)与混合臂版(修改噪声token数量至16,支持双臂任务,融入Robomind、AgiBot World数据集及ALOHA双臂数据),以满足不同机器人场景需求。

实验层:轻量化配置加速实验开发

实验层是Dexbotic提升研发效率的核心,采用“基础脚本+参数继承”的设计思路:

先构建base_exp脚本,集成优化器、训练器、数据、模型等基础配置; 用户开发实验时,无需修改完整配置文件,仅需继承base_exp脚本并修改差异化参数(如更换模型、新增任务),即可通过“python xxx_exp.py -task train”直接启动训练或推理。

这种 “只改要改的” 的模式,让算法对比、模型迭代效率提升 50% 以上,比如复现 CogACT 策略时,仅需加载 DexboticVLM 与 Diffusion Transformer 动作头,无需从零搭建训练流程,完全贴合开发者的实际操作习惯。

同时,实验层支持云端(阿里云、火山引擎)与本地消费级GPU(如RTX 4090)的训练与推理,兼顾高校、企业等不同用户的算力需求。下图所示是Dexbotic的训练流程:

Dexbotic的数据输入包括观察、文本指令和机器人状态。文本提示经过token化并输入到文本编码器以生成文本token。 观察图像首先由视觉编码器处理以生成图像token,并通过基于MLP的轻量级投影仪与文本空间对齐。 图像和文本token结合起来,一同输入到LLM中,以生成离散token。 对于离散表示策略,这些token可以直接解码为稀疏动作,而对于连续表示,通常会附加一个动作头来输出连续值动作chunking。 生成的动作序列由使用相应动作损失的动作GT进行监督。

Dexbotic框架同时也考虑到模型部署的需求,如下图所示:

DexClient通过网络向Web API发送请求,基于Flask Service的Web API接收并处理来自DexClient的请求; 从DexClient接收数据后,系统对图像和文本进行数据处理,使数据适配下一次VLA模型推理; VLA模型将图像和文本提示作为输入,并输出连续的动作; 生成的动作序列随后依次发送回Web API和客户端; DexClient根据这些结果执行相应的操作。

3. Dexbotic开源框架解析

统一模块化VLA框架

Dexbotic以VLA模型为核心,兼容主流LLM的开源接口,实现了“操作+导航”的一体化整合——不仅支持当前主流的具身操纵与导航策略,还预留了未来全身控制的接口。

其模块化设计将所有VLA策略统一拆分为“VLM(Backbone)+动作头(Action Head)”两部分:VLM 作为具身大脑负责多模态信息处理,动作头则根据策略需求灵活配置(如CogACT用Diffusion Transformer、用流匹配、MemoryVLA新增记忆模块),既保证了现有策略的兼容性,也为算法开发人员自定义策略(如设计新动作头)提供了灵活扩展空间。目前,Dexbotic的开源计划如下:

| Pretraining Model | ||

| Manipulation Policy | ||

| Navigation Policy | ||

高性能预训练基础模型

如下表所示,针对、CogACT等主流VLA策略,Dexbotic开源的预训练模型能够大幅突破性能上限。

在SimplerEnv(WidowX机器人) benchmark中,DB-CogACT较官方CogACT平均成功率提升18.2%(从51.3%至69.5%),DB-OFT较官方OpenVLA-OFT提升46.2%(从30.2%至76.4%); 在长任务场景CALVIN benchmark中,DB-CogACT的平均任务完成长度达4.06,较官方版本提升0.81; 即使是已达SOTA的MemoryVLA,在Dexbotic预训练模型加持下,也实现了近10%的成功率提升(从71.9%至81.3%)。

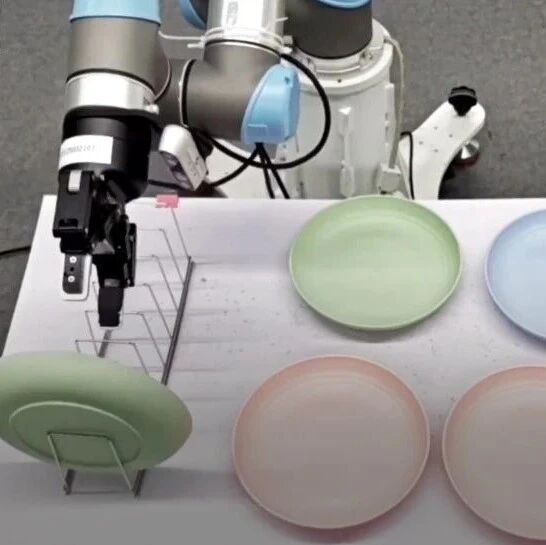

这些提升不仅体现在SimplerEnv、CALVIN等仿真器中,在UR5e、ALOHA等真实机器人任务中同样表现突出。

从真机demo也可以看到,Dexbotic提供的预训练模型在主流仿真器实现了巨大增益!

以实验为中心的开发框架

Dexbotic从开发者视角出发,采用了“分层配置+工厂注册+入口分发”的设计模式,完全贴合软件设计的“开闭原则”——对现有功能(如基础配置、核心模型)关闭修改,对新需求(如新增任务、自定义模型)开放扩展。

用户无需关注底层代码逻辑,仅通过修改实验脚本(Exp)即可实现配置调整、模型更换、任务新增等操作,大幅降低了实验开发的门槛与周期。例如,开发者如需复现CogACT策略,仅需基于base_exp脚本加载DexboticVLM与Diffusion Transformer动作头,无需重新搭建整个训练流程。

云端与本地一体化训练

Dexbotic充分考虑不同用户的算力差异,构建了“云端大规模训练+本地轻量化开发”的一体化支持体系。

云端方面,兼容阿里云、火山引擎等主流云平台,可支撑大规模数据集(如Open-X Embodiment)与复杂模型(如混合臂连续预训练模型)的训练; 本地方面,适配RTX 4090等消费级GPU,满足高校研究者或中小企业的轻量化实验需求(如小规模微调、推理验证)。

这种设计打破了算力对VLA研究的限制,让不同资源条件的用户都能参与到具身智能研发中。

全链路机器人训练与部署

针对UR5、Franka、ALOHA等主流机器人,Dexbotic提供“数据处理-模型训练-部署落地”的全链路支持:

统一的Dexdata格式解决了多机器人数据兼容问题,开源的通用部署脚本允许用户根据需求自定义部署逻辑; 在真实世界场景中,Dexbotic已实现多项日常任务——UR5e摆盘任务成功率达100%,ARX5搜索绿盒子成功率80%,Franka连续按按钮任务也能稳定完成。

未来,Dexbotic还将持续扩展支持的机器人平台,进一步覆盖更多具身应用场景。

4. 开箱即用

Dexbotic的核心优势在于“开箱即用”的研发体验,用户无需面对复杂的环境配置与基础模型构建:通过Git克隆仓库(https://github.com/Dexmal/Dexbotic)后,基于预定义的base_exp脚本,修改几行参数即可启动实验;如需微调模型,可直接加载Dexbotic-Base、Dexbotic-CogACT等预训练 checkpoint,无需从零训练;针对特定机器人,统一的Dexdata格式与部署脚本可快速实现数据适配与真实设备落地。

从学术研究到工业落地,Dexbotic都提供了便捷支持:研究者可基于其对比不同VLA策略性能,开发者可快速迭代自定义策略避免重复造轮子;工业界则能借助Dexbotic降低研发门槛和研发成本,将其应用于真机任务研发,尤其是中小型的创业公司无需组建庞大技术团队。目前Dexbotic官方网站已上线,展示UR5e、ALOHA等机器人的真实任务视频,用户还可将基于Dexbotic开发的算法提交至RoboChallenge,参与公平的真实世界性能对比。

基于此,Dexmal 原力灵机推出的Dexbotic开源框架和RoboChallenge真机测试基准便打通了算法训练、模型部署和真机测试三座大山。简而言之,Dexbotic 的出现标志着具身智能从 “碎片化探索” 进入 “协同创新” 的新阶段 —— 它不再是实验室里的复杂技术,而是能推动机器人走进日常生活的 “基础设施”。而RoboChallenge作为全球首个大规模、多任务的真机基准测试。不仅打破了多真机多任务基准的缺失与现有评测体系的局限,也进一步推动着具身智能从『实验室智能』走向了『现实世界智能』!

而与此同时,Dexmal 原力灵机为了进一步推进具身领域的软硬协同发展,今日也开源首款硬件产品——Dexbotic Open Source - W1(DOS-W1)。该产品采用完全开源的硬件设计,即将开源所有的文档、BOM、设计图纸、组装方案、相关代码;采用大量的快拆结构与可替换模块,这极大地降低了机器人的使用门槛、改造便利性和维护便利性;同时,其符合人体工学的抗疲劳设计,有效提升了操作人员的舒适度与数据采集效率。

未来随着更多开发者加入开源贡献,Dexmal 原力灵机也将与各学术界和工业界的伙伴们一起,持续丰富 Dexbotic Open Source 系列。软硬协同,持续推进具身领域的不断发展,以开源硬件助力具身智能前沿算法研究,加速机器人技术在真实物理世界的落地与应用。我们也诚邀全球开发者共同参与Dexbotic社区建设,通过代码贡献、算法优化、应用案例分享,携手推动具身智能迈向新高度。正如Linux之父林纳斯·托瓦兹所言:「软件进化需要群体的智慧」,Dexbotic正是这一理念在AI时代的具体实践。

10月23日晚 19:00,Dexmal 原力灵机创始团队成员汪天才将现身直播间,讲解开源一站式 VLA 工具箱 Dexbotic,欢迎大家扫描图中二维码预约观看、线上交流。