近日,Google Research宣布推出Coral NPU完整技术栈。这不是简单的硬件迭代,而是针对边缘AI长期存在的三大痛点给出的一套系统性解决方案。

1、

直指边缘AI的三个老问题

云端大模型的能力已经有目共睹,但要把AI搬到手表、耳机这类设备上,问题马上就来了。

第一是性能和功耗的矛盾。这是个根本性的架构选择问题。通用CPU提供了灵活性和广泛的软件支持,但缺乏针对机器学习的专用架构,跑AI模型时性能低、功耗高。专用加速器恰恰相反,机器学习效率高,但灵活性差、编程困难,处理不了通用任务。开发者要么选灵活但低效的CPU,要么选高效但难用的加速器,始终在做取舍。

第二是碎片化严重。硬件问题被软件生态的碎片化进一步放大。CPU和机器学习模块的编程模型完全不同,开发者常常被迫使用各家的专有编译器和复杂的命令缓冲区。这造成了陡峭的学习曲线,也很难把不同计算单元的优势整合到一起。结果就是,业界一直缺乏一个成熟的、低功耗的、能轻松支持多种机器学习框架的通用架构。

第三是隐私问题。个人AI要真正实用,必须在本地跑,不能什么数据都往云上传。但传统架构在安全隔离上做得不够。

Coral NPU直接颠覆了传统芯片设计。它不再把CPU放在中心位置,而是让机器学习矩阵引擎成为核心,标量计算反而成了配角。整个架构从硅片层面开始,就是为AI推理优化的,目标是打造一个专为设备端推理而生的高效平台。

更关键的是,Coral NPU不是一款具体的芯片产品,而是一个完整的参考级神经处理单元架构。它为下一代高能效、ML优化的片上系统提供了标准化的构建模块。芯片厂商可以基于这套架构设计自己的产品,也可以直接使用预配置的NPU方案。这种"开放架构+参考设计"的模式,是Google试图在边缘AI领域建立行业标准的关键一步。

2、

一个完整的技术栈

硬件方面,Coral NPU基于RISC-V指令集,包含三个核心模块:一个轻量级标量核心负责调度,一个向量执行单元处理并行计算,一个矩阵执行单元专门跑神经网络运算。整套设计的功耗控制在几毫瓦级别,可以让设备全天开启AI功能。值得注意的是,矩阵执行单元目前仍在开发完善中,Google计划在今年晚些时候将其发布到GitHub。

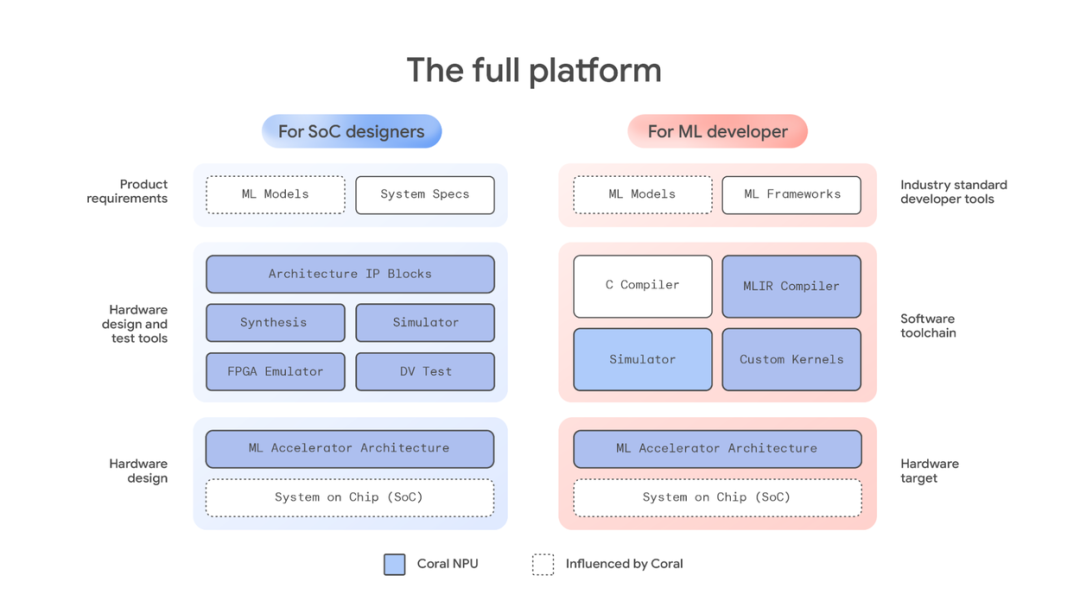

Coral NPU 生态系统的统一视图,展示面向 SoC 设计人员和 ML 开发人员的端到端堆栈。

软件工具链是另一个重点。Google提供了基于IREE和MLIR的通用编译器,开发者可以直接用TensorFlow、JAX、PyTorch这些主流框架。模型训练完,通过StableHLO导入,编译器自动完成优化和降级,最后生成能在设备上高效运行的二进制文件。

Coral NPU 编译器工具链,展示了从 ML 模型创建到优化和编译再到设备上部署的完整流程。

这套流程听起来简单,背后解决的是跨框架、跨硬件的适配问题。一次编写,多平台部署,这对边缘AI开发者来说很实际。

在安全层面,Coral NPU的设计考虑了硬件级隔离。架构支持CHERI等新兴安全技术,可以在硬件层面实现细粒度的内存保护和软件隔离。敏感的AI模型和个人数据能被隔离在硬件强制的沙箱中,防御内存攻击。这种从硬件底层做安全的思路,对处理个人隐私数据的可穿戴设备来说,是个必要的设计。

Google团队还在和自家的Gemma团队合作,专门优化小型Transformer在Coral NPU上的表现。这意味着,未来在手表上跑一个小型语言模型,在技术路径上已经打通了。

可视化从传统设计到 Coral NPU 的架构转变。

3、

第一个落地案例

技术平台要落地,还得看生态。Synaptics成了Coral NPU的首个硅合作伙伴。这家做嵌入式芯片的公司,在自己的新品Astra SL2610处理器里,集成了基于Coral NPU架构的Torq NPU子系统。

Synaptics技术日上的发布不是偶然。他们在物联网、可穿戴领域有现成的客户和供应链。这次合作,让Coral NPU从技术方案变成了可以量产的产品。

应用场景已经很明确:Coral NPU主打始终在线的环境感知能力,包括用户活动检测(走路、跑步)、场景识别(室内外、移动状态)、实时语音翻译、手势识别、本地图像处理等。这些都是可穿戴设备和智能家居的刚需,但以前要么做不了,要么做了掉电太快。Coral NPU的低功耗设计,让设备可以7×24小时感知环境、理解上下文,同时不用担心电量问题。

4、

开源策略背后的考量

Google把Coral NPU的架构、工具链都开源了。这个动作值得琢磨。

边缘AI市场现在是群雄割据,各家方案互不兼容。Google选择开放标准,本质上是想建立一个通用平台。芯片厂商可以基于这套架构做定制,开发者有统一的工具可用,整个产业链的协作成本会降下来。

RISC-V本身就是开放指令集,加上MLIR这些开源编译框架,技术栈的每一层都是可以看得见、改得动的。这对学术界、初创公司都有吸引力。

当然,开源不等于免费的午餐。Google在大模型、AI框架上的积累还在,Coral NPU更像是把自己在边缘AI上的工程经验固化成一套标准。谁用得好,谁就能更快地把新能力推向市场。

5、

边缘智能还有多远

从技术指标看,Coral NPU解决了"能不能跑"的问题。512 GOPS的算力,对小模型来说够用。几毫瓦的功耗,让全天候AI成为可能。

但实际体验还得看软硬结合的程度。一个好用的边缘AI产品,不只是芯片性能到位就行,还要模型优化、系统调度、应用场景设计都跟上。Synaptics的案例是个开始,后面还得看更多厂商怎么用这套平台。

另一个变量是生成式AI在边缘的进展。Coral NPU提到了对Transformer的支持,但小型语言模型在端侧到底能做到什么程度,现在还没有标杆产品。这条路要走通,不光是算力问题,还涉及模型压缩、推理优化、长期记忆管理这些工程细节。

边缘计算和云计算不是替代关系,是分工协作。云端负责重计算、大模型训练,边缘负责低延迟、隐私保护、实时响应。Coral NPU瞄准的就是这个交界地带——既要足够智能,又要足够节能,还得保证数据不出设备。

这个方向是对的。至于能走多远,还得看产品落地后的市场反馈。

文档和开发工具已在 developers.google.com/coral 发布。

参考材料:

https://research.google/blog/coral-npu-a-full-stack-platform-for-edge-ai/

END