论文题目:Emulating Self-attention with Convolution for Efficient Image Super-Resolution

论文地址:https://arxiv.org/pdf/2503.06671

代码地址:https://github.com/dslisleedh/ESC

创新点

研究者们提出了一种名为卷积化自注意力(Convolutional Attention, ConvAttn)的模块,用于替代传统的自注意力机制。该模块通过共享的大卷积核和动态卷积核来模拟自注意力的长距离建模能力和实例依赖加权特性,从而显著减少了对自注意力及其相关内存密集型操作的依赖,同时保持了Transformer的表示能力。

为了进一步优化自注意力的内存使用,研究者们首次将Flash Attention技术引入轻量级图像超分辨率任务中。Flash Attention通过避免显式构建分数矩阵,显著降低了内存占用,使得自注意力的窗口大小可以扩展到32×32,而不会导致内存使用量大幅增加。

方法

本文的主要研究方法是提出了一种名为卷积化自注意力(Convolutional Attention,简称ConvAttn)的模块,并基于此设计了一个高效的轻量级图像超分辨率网络(Emulating Self-attention with Convolution,简称ESC)。研究者首先通过分析自注意力在多层中的重复性和相似性,发现自注意力在不同层之间提取的特征高度一致,这表明可以通过高效的替代方案来减少计算开销而不损失表示能力。基于这一发现,ConvAttn模块被设计为具有两个机制:一是通过在整个网络中共享一个13×13的大卷积核来简化自注意力的长距离交互;二是生成动态卷积核以捕捉输入依赖的加权,模仿自注意力的自适应性。这两个机制结合在一起,显著减少了对内存密集型自注意力的依赖,同时保持了Transformer的表示能力。

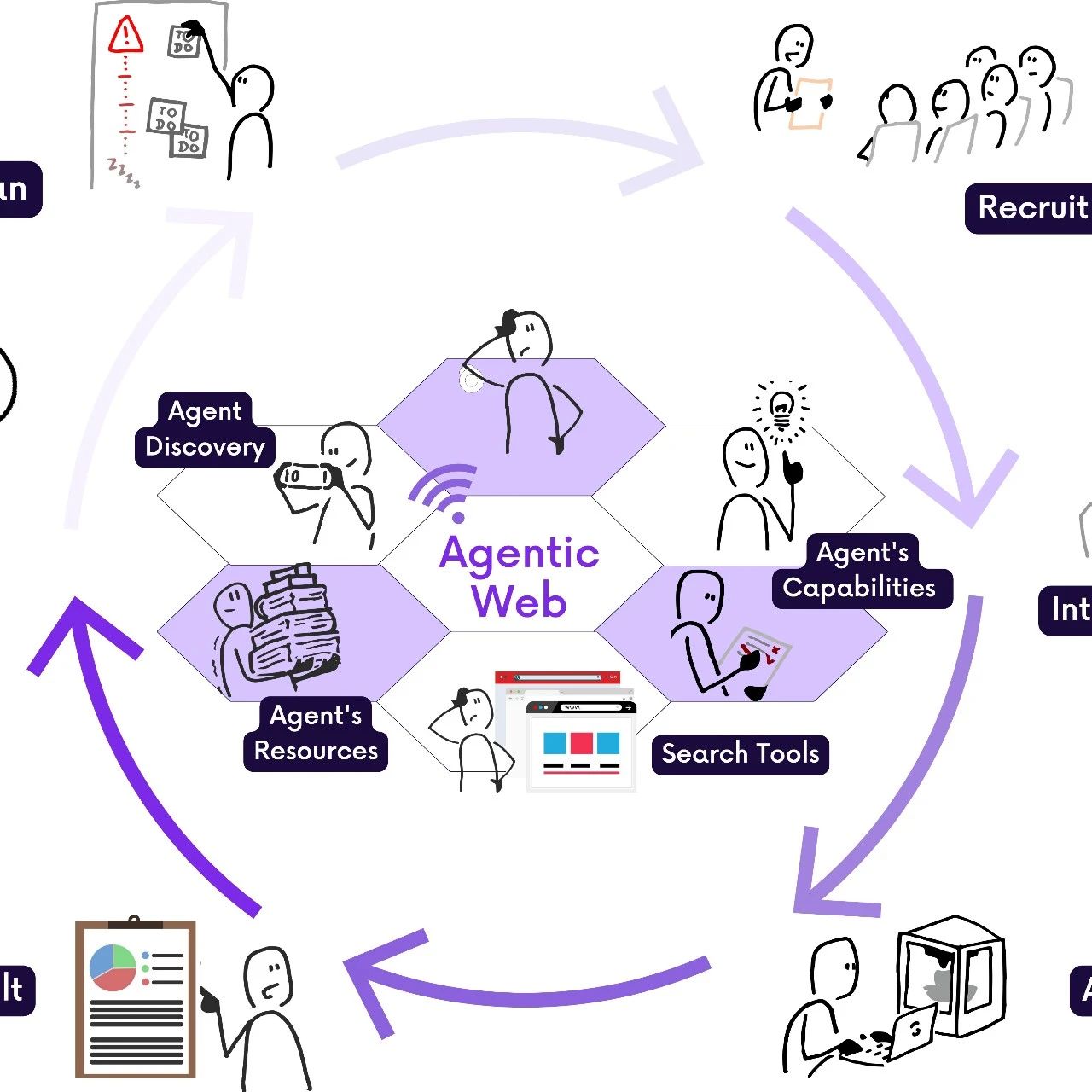

性能、延迟和内存使用对比图

本图展示了本文提出的 ESC 方法与其他代表性超分辨率模型(包括 CNNs、Transformers 和 State-Space Models)在 Urban100×4 数据集上的性能、延迟和内存使用对比。图中显示,ESC 方法在保持较高 PSNR(峰值信噪比)的同时,显著降低了延迟和内存使用。具体来说,ESC 方法在性能上接近甚至超过了现有的 Transformer 模型,但在延迟和内存使用上表现出明显的优势,尤其是在资源受限的设备上更具实用性。

自注意力层间相似性可视化

本图展示了自注意力(Self-Attention)在不同层之间提取的特征(F)和注意力图(A avg )的层间相似性。通过计算 CKA(Centered Kernel Alignment)相似性和余弦相似性,研究者发现自注意力在多个层之间提取的特征高度一致,平均相似性分别为 89% 和 87%。这一发现表明自注意力在不同层之间可能提取了重复的特征,为用高效替代方案减少计算开销提供了理论依据。

整体网络架构图

本图展示了本文提出的 ESC 网络的整体架构。网络由四个主要部分组成:输入图像经过一个 3×3 的卷积层转换为浅层特征,然后与一个共享的大卷积核一起输入到深度特征提取器中,提取的深层特征与浅层特征相加得到最终特征。同时,图像级跳跃模块生成跳跃特征,上采样模块利用最终特征和跳跃特征生成超分辨率图像。整个网络通过多个 ESC 块(ESCBlock)实现深度特征提取,每个 ESC 块包含自注意力层和多个 ConvAttn 模块。

实验结果

本表提供了在经典图像超分辨率任务中,多种轻量级超分辨率方法在 DIV2K 数据集上的性能对比。这些方法包括基于卷积神经网络(CNNs)、Transformer 和状态空间模型(SSMs)的代表性模型。表中详细列出了每种方法在不同放大倍数下的性能指标,包括峰值信噪比(PSNR)和结构相似性指数(SSIM),以及模型的延迟、内存使用、浮点运算次数(FLOPs)和参数数量。表中首先列出了基于 CNN 的方法,如 RDN 和 RCAN,这些方法在图像超分辨率领域有广泛的应用。RDN 以其较高的参数数量和计算复杂度著称,而 RCAN 则通过引入通道注意力机制来提高性能。尽管这些方法在 PSNR 和 SSIM 上表现良好,但它们的延迟和内存使用相对较高,尤其是在处理高分辨率图像时。最后是本文提出的 ESC 系列方法,包括 ESC-FP、ESC-lt 和 ESC。这些方法通过引入 ConvAttn 模块和 Flash Attention 技术,在保持 Transformer 优势的同时,显著降低了延迟和内存使用。本表展示了本文提出的 ESC 方法在保持高性能的同时,显著提高了轻量级图像超分辨率任务的效率,降低了延迟和内存使用,使其更适合在资源受限的设备上应用。

-- END --

关注“学姐带你玩AI”公众号,回复“注意力全新”

领取注意力机制高分论文合集+开源代码