>>直播和内容获取转到→具身智能之心知识星球

点击按钮预约直播

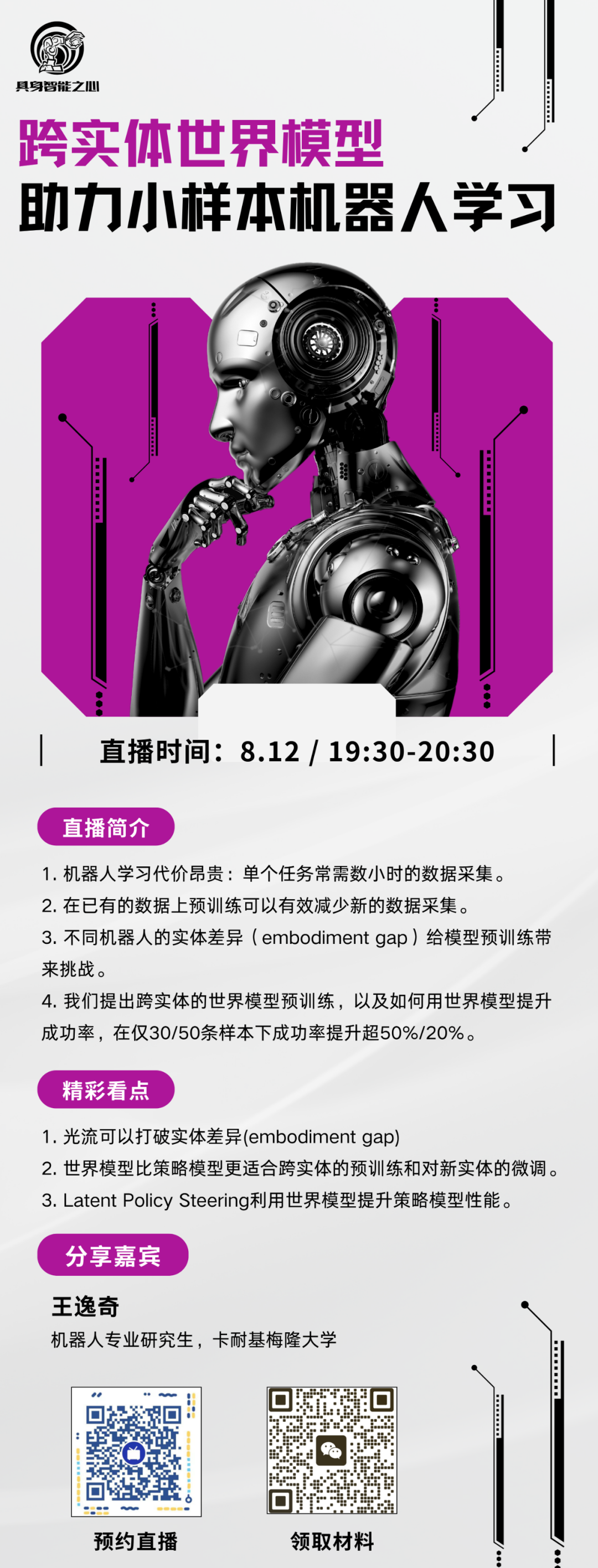

通过模仿学习来训练视觉运动策略(visuomotor policies)在众多机器人领域已被证明是有效的。然而,这些策略的性能严重依赖于训练示范(demonstrations)的数量,而这需要在现实世界中进行昂贵的数据收集。本研究的目标是,在训练视觉运动机器人策略时,通过利用来自各种具身(embodiments)——例如公开的机器人数据集和人类摆弄物体的数据集——的现成或低成本数据,来减少数据收集的工作量。

本文的方法基于两个关键见解:

具身无关的世界模型预训练: 本文使用光流(optic flow) 作为一种具身无关的动作表示(embodiment-agnostic action representation),在跨多个具身的数据集上预训练一个世界模型(World Model, WM),然后仅用少量目标具身的机器人数据对其进行微调(finetune)。

潜在策略引导(LPS): 提出了一种名为潜在策略引导(Latent Policy Steering, LPS) 的方法,通过在世界模型的潜在空间(latent space) 中搜索更优的动作序列,来改进通过行为克隆(behavior cloning)得到的策略输出。

在真实世界实验中,本文观察到:将策略与一个在现成的、包含不同机器人的 Open X-embodiment 数据集(两千个片段)或一个低成本的、来自人类玩耍的数据集上预训练好的世界模型结合后,显著提升了仅用少量数据(30次示范带来超过50%的相对提升,50次示范带来超过20%的相对提升)训练出的策略性能。

论文标题:Latent Policy Steering with Embodiment-Agnostic Pretrained World Models

论文链接:https://arxiv.org/abs/2507.13340

更多精彩回顾

🚀 直播精华看不够?完整版深度内容已独家上线知识星球「具身智能之心」!涵盖所有技术细节、QA及未公开彩蛋。深度解析!

重磅分享!VR-Robo:real2sim2real助力真实场景下的机器人导航和运动控制

重磅直播!CVPR冠军方案BridgeVLA,真机性能提升32%

UniVLA:高效利用多源异构数据,构建通用可扩展的机器人动作空间

干货满满,快来加入