智猩猩Robot整理

编辑:严浠

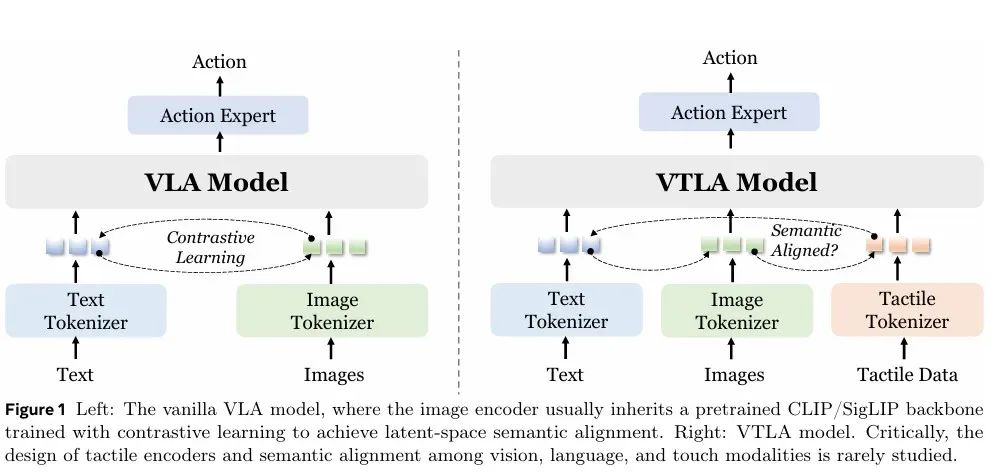

在机器人领域,视觉与触觉感知的融合已成为提升机器人操作能力的一个重要途径。近期,视觉-语言-动作(VLA)模型已在机器人操作任务中取得了显著进展。但大部分VLA模型忽略了触觉感知的重要性,且还存在触觉传感器的异构性以及触觉数据获取难度大的问题,导致其在接触密集型任务中表现不佳。

现有的将触觉融入VLA模型的工作,往往将触觉数据视为低层信号,未能将其与视觉及语言在语义层面对齐。

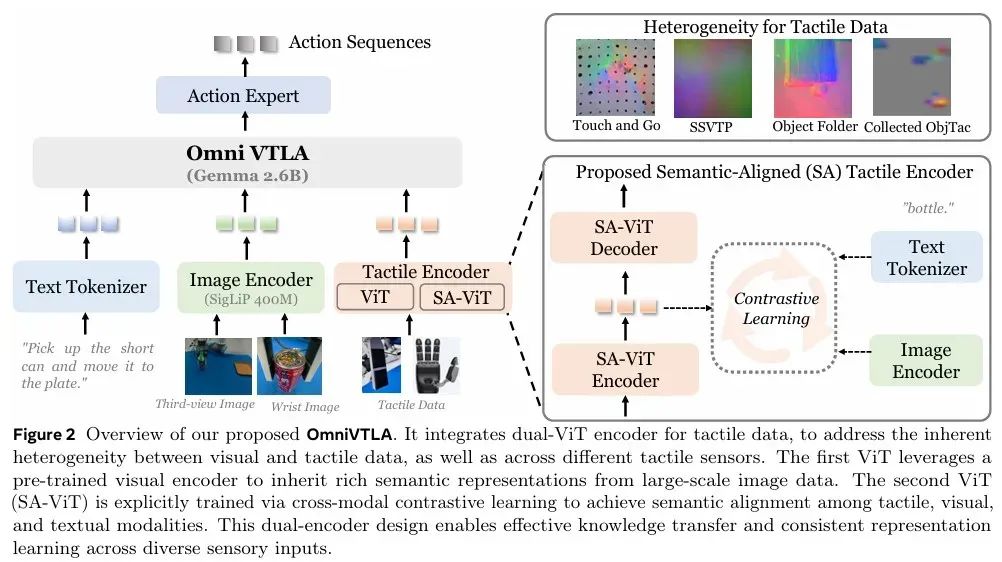

为此,帕西尼感知联合上海交通大学提出一种将视觉、触觉与语言统一到共享语义空间的视觉触觉语言动作模型OmniVTLA。 该模型通过双编码器路径(ViT和SA-ViT)有效整合了不同类型的触觉数据,并将其与视觉和语言数据结合,使机器人能够更好地理解物体的触觉信息,做出更精准的操作决策。

真机实验表明,OmniVTLA的性能优于VLA的基准模型π0。在使用夹爪抓放任务中,成功率达到96.9%比基准VLA模型高出21.9%;在使用灵巧手抓放任务中,成功率高达100%。此外,与现有的VLA模型相比,OmniVTLA显著缩短了任务时间,并产生了更平滑的运动轨迹。

论文标题:《OmniVTLA:Vision-Tactile-Language-ActionModel withSemantic-AlignedTactile Sensing》

论文链接:https://arxiv.org/pdf/2508.08706

1

方法

1.1 采用双路径编码器的整体架构

OmniVTLA模型整体架构如下图所示。该模型在π0的基础上构建,包含三个核心组件:分词器(tokenizers)、主干网络(backbone) 和动作头(action head)。

1)Tokenizers:

语言指令lt:使用PaliGemma分词器(词汇量:257,152)进行处理。

图像观测Iti:使用SigLiP模型进行处理。

触觉观测Ttj:将上述所有模态投影为潜在tokens。

图像处理(包括第三视角和腕部视角):将原始捕获图像调整为224 × 224分辨率,每张图像生成256个tokens。

触觉数据处理:将数据范围归一化为int8格式,并将多传感器输入拼接成单张图像。随后通过一个类ViT编码器处理调整后的224 × 224输入,生成256个tokens。

2)Gemma-2B 主干网络:

Gemma-2B 主干网络处理拼接后的标记,生成动作tokens。

3)动作头:

解码动作tokens,该动作头使用流匹配损失进行训练(遵循π0的设置)。动作表征随末端执行器变化:

两指夹爪:10 tokens(3相对位置 + 6相对角度 + 1夹爪状态)。

四指灵巧手:25 tokens(3相对位置 + 6相对角度 + 16绝对关节位置)

现有工作因触觉与视觉数据间异构性和触觉传感器间的异构性未能充分解决触觉编码器的设计问题。

为此该团队探索了四种方案:

VTLA-FS:触觉编码器从头开始训练,仅依赖有限的遥操作触觉数据。

VTLA-Pre:触觉编码器从一个大规模数据集的预训练视觉编码器初始化,并在少量遥操作数据上微调。

VTLA-SA:触觉编码器首先通过跨模态对比学习实现语义对齐,然后在少量数据上微调。

OmniVTLA:采用双路径编码器,其中一条路径是VTLA-Pre,另一条路径是VTLA-SA。

视触觉传感器通常具有较高的空间分辨率,但时间分辨率较低;而其他的(如Paxini Gen2的多维触觉传感器)则测量力觉信息,虽然空间分辨率相对较低,但能捕获较高的时间分辨率,从而更好地表征。因此,力觉传感器能更好地作为视觉模态的信息补充。

为应对不同触觉传感器的异构性,采用双ViT编码器,通过拼接tokens实现跨传感器理解,解决异构性问题。

1.2 语义对齐的触觉编码器

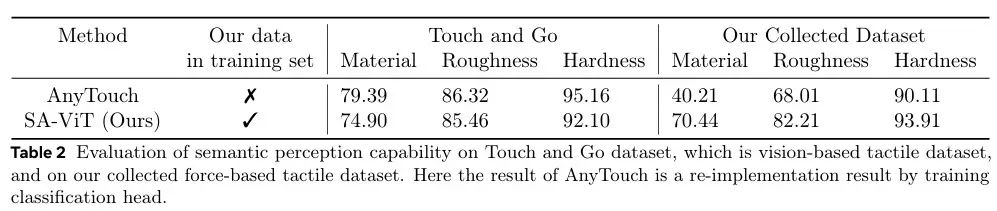

现有工作探索了针对视触觉传感器的统一表征,但无法泛化到力觉传感器。预训练的AnyTouch编码器在力觉传感器数据集上的材料分类准确率仅为 40.21%,存在严重的跨传感器迁移限制。

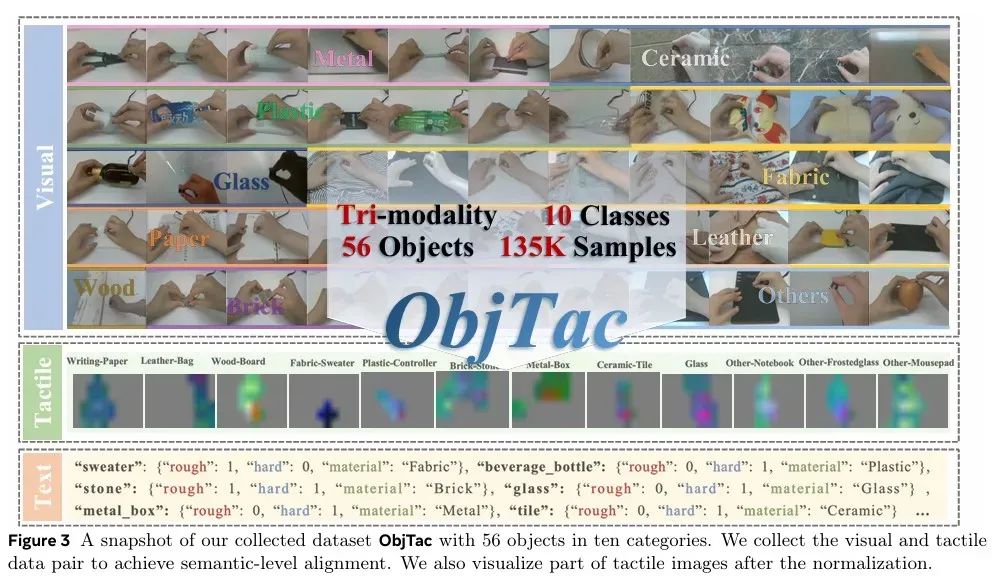

为此,该团队构建了ObjTac数据集,包含对齐的文本、视频和力控型触觉数据,10种类型的56种物体和135K三模态样本,涵盖了视觉、语言和触觉数据。通过这个数据集,OmniVTLA能够学习到更为精准的触觉特征,为机器人提供更加智能化的决策。该数据集的构建通过多次物体交互,记录了大量的触觉和视觉数据,并通过时序同步确保了多模态数据的精确对齐。

2

实验

2.1 实验设置

基准模型:研究人员将OmniVTLA与Diffusion Policy (DP)和π0进行对比,将DP作为非VLM的基准模型,将π0作为VLA的基准模型。

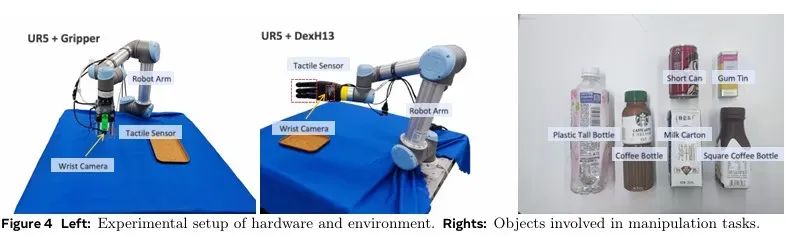

系统与任务配置:实验所用的机器人平台包括一个UR5机械臂、一个两指夹爪(集成2个触觉传感器和1个腕部摄像头)、四指灵巧手(集成11个触觉传感器和1个腕部摄像头)和摄像头。

使用两指夹爪对矮罐、方咖啡瓶、口香糖罐、牛奶盒完成抓取和放置任务;使用四指灵巧手对咖啡瓶、牛奶盒完成抓取和放置任务。每个物体以30Hz频率采集40条遥操作轨迹。

2.2 实验结果

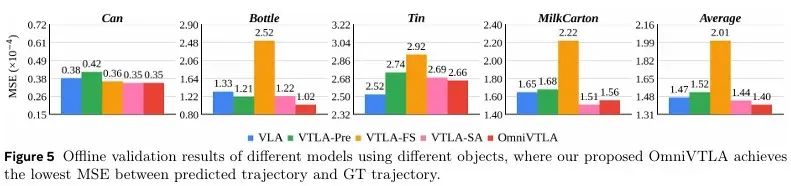

离线验证:

实验结果如下图所示,OmniVTLA在全部对象上取得最低的均方误差(MSE),均值为1.40×10⁻⁴。

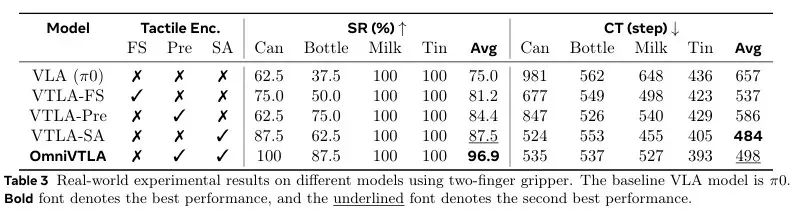

真机实验:

使用两指夹爪对比OmniVTLA与其他模型的实验结果如下表所示。OmniVTLA平均成功率达到96.9%,VLA基准模型π0的成功率为75%,成功率远超π0,高出21.9%。

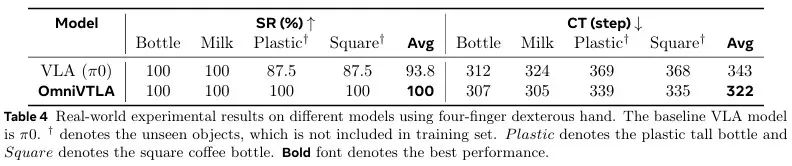

使用四指灵巧手对比OmniVTLA与VLA基准模型π0的实验结果如下表所示。OmniVTLA平均成功率高达100%,π0的成功率为93.8%;且完成时间 (CT) 缩短了6%(从343步减少到322步)。特别是在未经训练的物体(塑料瓶与方瓶)上,OmniVTLA也取得了100%成功率,而π0成功率仅为87.5%。

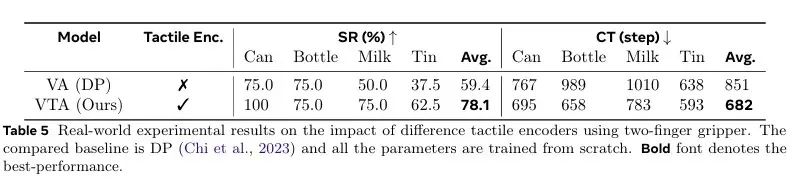

使用两指夹爪对比VTA与非VLM基准模型DP的实验结果如下表所示。VTA平均成功率为78.1%,DP为59.4%,融入了触觉感知将其平均成功率显著提升了18.7%;并将平均完成时间缩短了19.9%(从851步缩短至682步)。这证实了触觉信号能够增强模型性能,且与所采用的基准模型无关。

轨迹平滑度:

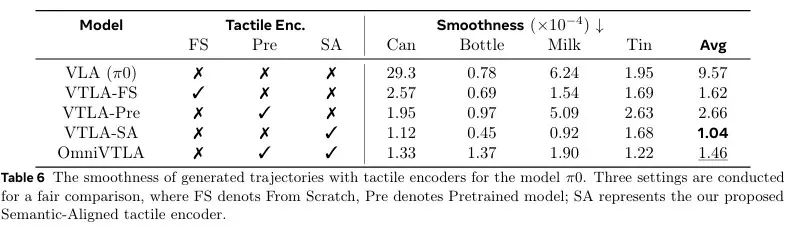

研究人员对比了OmniVTLA与其他模型的轨迹平滑度。VTLA-SA的平均平滑度指标最低为1.04×10⁻⁴,OmniVTLA平均轨迹平滑度为1.46×10⁻⁴,比VLA基准模型π0降低了89.6%。

实验表明,触觉感知能显著提升机器人运动的平滑度,使其更精细地调整抓取动作。还能在缩短任务完成时间的同时,避免接触过程中突兀的急动,这对于抓取易碎物体至关重要。

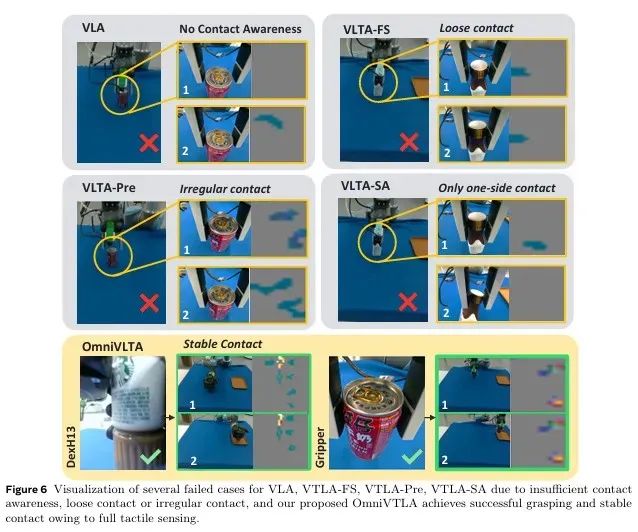

定性结果分析:

任务为“抓起矮罐并将其移动到托盘上”,VLA、VTLA-Pre和OmniVTLA模型的失败与成功案例如下图所示。VLA模型由于接触感知能力不足而常常无法抓起物体,VTLA-Pre模型在持续调整夹爪但无法成功抓取,OmniVTLA模型则能够利用触觉信号稳定抓取且运动轨迹平滑。

3

总结

本论文提出了一个专为密集接触型操作任务设计的视觉-触觉-语言-动作模型OmniVTLA。为应对触觉数据的异构性和不同触觉传感器的异构性,采用双路径编码器(VTLA-Pre+VTLA-SA)和双ViT编码器。此外,该团队还构建了ObjTac数据集,包含对齐的文本、视频和力控型触觉数据,10种类型的56种物体和135K三模态样本。

实验结果表明,OmniVTLA相较于VLA基准模型π0取得了显著提升,使用两指夹爪任务成功率提升21.9%,四指灵巧手任务成功率提升6.2%。此外,OmniVTLA将任务完成时间缩短了约24.2%,且生成的运动轨迹也更加平滑。

END

推荐阅读

训练数据65万条!上海AI Lab联合提出端到端VLA模型InstructVLA,真机实验成功率超OpenVLA

20亿参数+全面超越π0!清华朱军团队&地平线提出全新VLA模型H-RDT,有效从人类操作数据中学习

机器人非抓取操作重大突破!北大&银河通用王鹤团队提出自适应世界动作模型DyWA | ICCV 2025

清华联合生数提出具身视频基座模型Vidar,20分钟真机数据实现跨本体泛化!

星海图联合创始人赵行:定义具身智能的ImageNet | 演讲回顾

点击下方名片 即刻关注我们