Kwai Keye团队 投稿

量子位 | 公众号 QbitAI

在Openai 发布o3后,think with image功能得到了业界和学术界的广泛关注。

Kwai Keye团队提出Thyme (Think Beyond Images)的新范式,并围绕它构建了一整套技术方案。旨在突破现有方法的限制,赋予开源模型一种更强大、更自主、功能更全面的“超越图像思考”的能力。

其主要贡献可以概括为以下几点:

提出了一个全新的多模态交互范式Thyme:

核心思想:让多模态大模型不再局限于被动地“看图”,而是能够主动地通过生成并执行代码,来调用各种工具完成复杂的图像处理和数学计算。

功能丰富:模型可以即时进行裁剪、旋转、缩放、对比度增强等多种图像操作,还能处理复杂的数学问题。

高度自主:模型能自主判断何时需要使用工具、使用何种工具,并动态生成代码来执行,无需人工为特定任务进行干预。

设计了一套高效的两阶段训练策略 SFT + RL:

监督微调 (SFT) 阶段:利用精心构建的约 50 万条高质量样本数据集,快速教会模型生成代码来执行各种操作。这个阶段仅需约 200 GPU 小时,性价比极高。

强化学习 (RL) 阶段:在 SFT 的基础上,通过 RL 进一步优化模型的决策能力。为了解决 RL 阶段的挑战,研究者还:

构建了高质量 RL 数据集:手动收集和标注了 1 万张高分辨率、高难度的图像问答对,以增强模型在复杂场景下的感知能力。

提出了创新的RL算法GRPO-ATS:该算法能为文本生成和代码生成设置不同的采样温度(temperature)。具体来说,为文本使用较高的温度以鼓励探索和创造性,为代码使用极低的温度(0.0)以确保生成代码的精确性和可执行性,巧妙地平衡了推理的灵活性和代码的稳定性。

构建并开源了完整的配套资源:

高质量数据集:开源了用于 SFT 和 RL 阶段的全部数据集,包括超过 400 万的原始数据源和精心筛选标注的数据。

安全的沙箱环境:开发了一个可以安全执行模型生成的代码并返回结果的沙箱。这个沙箱还简化了代码生成的难度,能自动处理格式、变量定义等问题,提高了代码的可用性。

完整的代码库:将所有训练代码、模型和工具链全部开源,旨在推动整个社区在该方向上的发展和应用。

总言,Thyme 通过赋予模型“代码生成与执行”的能力,极大地扩展了多模态模型的工具使用范围和自主决策水平,并在近 20 个基准测试中取得了显著且稳定的性能提升,尤其在处理高分辨率图像和复杂推理任务上表现出色。

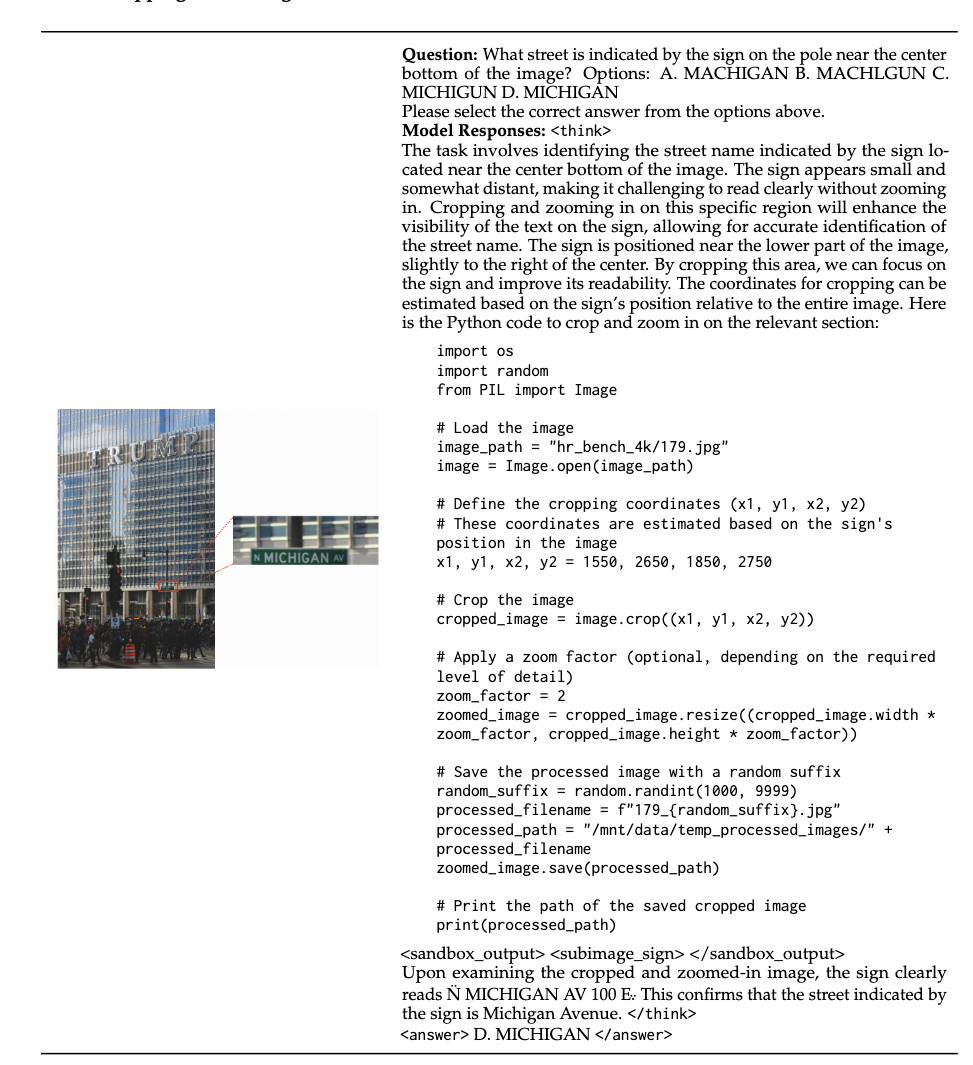

Thyme推理样本展示

裁剪+放大

Thyme首先评估了标志的大小和距离,判断出裁剪并放大对应区域可以提高可见性。接着,它编写代码来裁剪并放大包含标志的区域。最后准确地定位了标志的位置,成功地裁剪并放大了该区域,并正确地回答了问题。

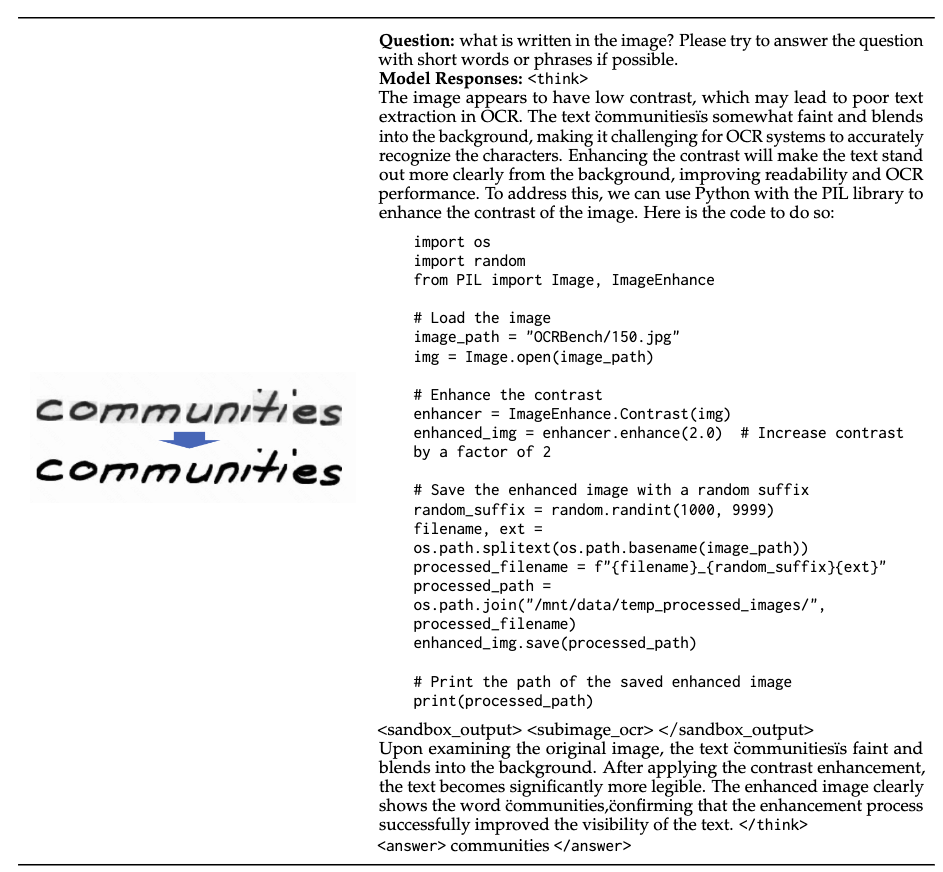

对比度增强

在OCR任务中,Thyme会适时的增强图像对比度,让需要识别的文字更加清晰。

图像旋转

Thyme意识到输入图像的方向不正确,因此它使用Python代码执行旋转操作来调整输入图像的角度,最后进行读取。

复杂计算

Thyme可以将复杂计算操作,转化为代码,避免模型直接预测计算结果。

Thyme工作流程

1 模型接收用户输入问题,输出推理思路。

2 模型判断问题复杂度,决定是否生成Python代码执行图像处理或计算任务。

3 若无需代码(简单问题或先前代码已解决),直接输出答案。

4 生成代码后,交付给外部沙箱安全执行,沙箱负责格式校验、参数调整、错误修正等处理。

5 沙箱返回执行结果(图像或数值),模型基于结果继续推理,多轮交互直至输出最终答案。

在这里作者强调了MLLM的外部沙盒需要做的一些事情,主要包括一些自动纠错机制,来尽量保证代码的可用性。

使用autopep8模块格式化代码,统一缩进和风格。 利用ast解析代码变量,自动调整图像裁剪坐标边界,避免越界错误。 预置必要变量及模块导入(如cv2、image_path),保证环境一致。 记录代码分段变量依赖,解决多段代码执行时上下文丢失问题。

Thyme-SFT

训练数据

SFT主要构造了三类任务:

- 无需代码直接答复:

简单问题直接回答,训练模型判定是否需要代码生成。 - 基于代码的图像操作和计算:

包含裁剪、旋转、对比度增强、数学计算等。 - 多轮交互数据:

针对图像操作失败的错误修正、连续增强等多轮迭代任务。

对代码生成样本进行严格执行与语义审核,剔除不执行或执行结果错误的代码片段,提高训练样本有效性。

手工构建多轮对话数据,教会模型基于上一轮代码执行结果调整策略,具备错误纠正能力。

训练策略

训练过程模型基于输入图片(I)和问题(Q)生成推理流程(T)及可选代码(C),通过沙箱执行代码获得结果(S),多轮循环迭代直到生成最终答案(a):

[X = { (I, Q); ([T_0, C_0, S_0], …, [T_t, a]) }]

使用了一些SFT策略保证多种功能能被成功激活:

强制模型仅学习输出最终一轮的有效推理和代码,早期输出轮次内容被遮蔽,避免模型过度依赖第二轮纠正。 训练时排除沙箱执行输出标签,防止模型直接模仿沙箱结果,提高推理过程质量。 对数学计算数据采用退火训练策略:初始阶段训练图像操作数据,再用较低学习率微调数学推理数据,避免数据不均衡问题。

Thyme-RL

数据构造

出了从开源数据进行搜集和筛选外,额外补充了10k的人工标注数据,标注的任务包括OCR识别、属性识别、数量识别等多种任务,这些任务要求模型能够从高分辨率图像中提取细节信息并正确回答相关问题,增强感知难度。

训练策略 GRPO-ATS

采用on policy的GRPO。

奖励函数包括:

- 结果奖励:

比较模型输出与地面真值答案的匹配程度,确保模型输出的正确性。 - 一致性奖励:

检查推理过程是否与最终答案一致,以确保推理步骤的合理性。 - 格式奖励:

确保输出符合严格的结构规范,增强推理过程的可解释性。

适应性温度采样:

温度调整:对于代码生成任务,如图像处理和计算任务,使用低温度(τ = 0)进行采样,以确保代码生成过程的准确性和一致性。对于推理过程,使用较高的温度(τ = 1)来鼓励模型探索更多的解决方案。

这一策略有效避免了模型在生成代码时的过度多样化问题,提高了代码生成的稳定性,并使得推理过程更加灵活多样。

采样优化:

为了减少计算资源浪费,运用Rabin-Karp滚动哈希算法检测过多重复内容;当重复子串长度超过输出长度50%,立即判定为重复并提前终止当前轨迹采样,有效避免资源浪费。

在训练中还强制限制了最大对话轮次,避免模型陷入无意义的循环,从而提高了训练效率。

实验效果

感知,推理,通用任务全面提升

训练基于32块NVIDIA H800 GPU,强化学习阶段耗时超1200 GPU小时。

在多个基准任务上,Thyme表现出相较于其他多模态模型的优势,尤其是在感知任务上,Thyme即使在与更大规模的模型Qwen-2.5-VL-32B对比时,也依然显示出了显著的优势。这表明,仅仅通过增加模型的规模并不能有效解决感知任务中的挑战,相反,Thyme在测试时的扩展策略对感知任务十分有效。

在推理任务中,通过将复杂的计算转化为可执行代码,Thyme在推理能力上取得了显著的提升。然而,在这一领域,模型规模的扩展带来的优势更为显著,表明推理和逻辑推理能力主要依赖于模型本身的知识量。

由于感知与推理能力的提升,Thyme在许多通用任务中取得了显著的进展,尤其是在减少幻觉现象(hallucination)方面。

深入探讨感知任务

以MME-RealWorld为例,它包括许多现实场景中的高分辨率感知任务。表4展示了Thyme与基线模型在不同任务上的表现。

可以看到,对于基线模型已表现良好的任务,如OCR、图表和表格(准确率超过60%,甚至接近90%),Thyme的提升相对较小。然而,对于更困难的任务,如监控与自动驾驶,在这些任务上Qwen-2.5-VL-7B的感知能力较弱时,Thyme的感知和推理任务的提升超过了25%,尤其是在推理任务中,提升更为显著。

论文链接:https://arxiv.org/abs/2508.11630

一键三连「点赞」「转发」「小心心」

欢迎在评论区留下你的想法!

— 完 —

🌟 点亮星标 🌟