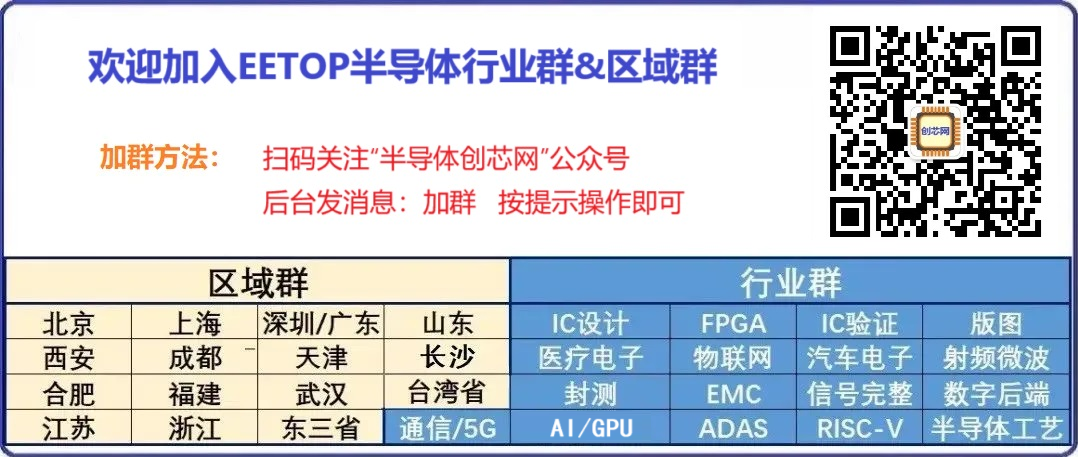

欢迎加入 EETOP 微信群

博通官宣百亿美元 AI 硬件协议,神秘客户疑云引爆业界猜想

博通本周高调宣布,已与某未公开客户签署价值 100 亿美元的 AI 数据中心硬件供应协议。这批硬件不仅包含为客户 workload 深度定制的 AI 加速器,还涵盖该公司其他核心设备。业内盛传该客户正是 OpenAI,据悉其计划将这批 AI 处理器用于推理任务,而订单规模或涉及数百万枚芯片 —— 这一数字相当于重塑数个超大规模算力集群。

博通 CEO 陈福阳(Hock Tan)在财报电话会议上透露:“上季度,其中一位潜在客户向我们释放了量产订单,我们已将其列为 XPU 的合格客户。事实上,基于 XPU 的 AI 机架订单总额已突破 100 亿美元。” 一如既往,博通对客户身份守口如瓶,但 “合格客户” 的认定意味着芯片及配套平台已通过严苛验证,设计方案正式冻结;而 “量产订单” 更标志着客户从原型测试阶段全面转向商业化采购,尽管收入确认可能在硬件交付后才启动。

受此消息影响,昨日美股收盘博通股价大涨9.41%。

2026 年算力交付倒计时:博通 XPU 机架暗藏底层架构革命

根据协议,博通将于 2026 年第三季度(截至 2025 年 8 月初)交付 “基于 XPU 的机架”。但此 “机架” 并非戴尔等厂商的成品机柜,而是集成定制 AI 加速器(XPU)、网络芯片及参考架构的模块化组件,为大客户提供自主搭建规模化 AI 基础设施的核心积木。

若博通在 2026 年 6-7 月完成交付,客户仅需数月即可部署落地(预计 2026 年秋季),这与此前爆料 “OpenAI 联合博通开发的定制芯片将于 2026 年底至 2027 年初首次部署” 的时间线高度吻合。据悉,该芯片将采用脉动阵列架构(类似其他 AI 加速器的矩阵计算优化设计),搭载 HBM 高带宽内存(暂未明确 HBM3E 或 HBM4),并基于台积电 N3 系列(3nm 级)工艺制造。

百亿美元豪赌:OpenAI 剑指算力自主化,或掀芯片厂商价格战

对 OpenAI 而言,100 亿美元的硬件投入堪称 “豪赌”—— 这一数字仅用单季度交付量就直逼超大规模云厂商的算力投入。参考 Meta 2025 年 720 亿美元资本支出中 AI 硬件占大头的比例,以及 AWS、微软每年数百亿美元的 AI 投入,OpenAI 此举无疑在算力赛道吹响冲锋号。

按单颗加速器 5000-10000 美元成本估算,100 亿美元订单或对应 100-200 万枚 XPU,将组建数千个机架、数万个节点的超级集群 —— 规模直接超越当今多数顶级 AI 推理集群,包括 OpenAI 现有的庞大算力网络。更值得玩味的是,这家曾依赖微软 Azure(AMD/Nvidia GPU)的 AI 巨头,正通过博通定制芯片转向自研基础设施,既为控本增效,更暗藏与 AMD、Nvidia 谈判的价格筹码。

尽管目前尚无官方实锤,但这笔足以改写算力版图的世纪大单,已让整个行业屏住呼吸—— 当 OpenAI 手握百万级定制芯片,AI 算力战争的下一幕,或许比想象中更猛烈。

关注我们 设为星标

TI 最新架构DSP+MCU (原厂免费培训)

(线下实操)

北京(9 月 11日)