不圆 发自 凹非寺

量子位 | 公众号 QbitAI

网络搜索Agent效果不好,猛猛投喂一波数据,表现还那样,咋回事?

港科大&MiniMax团队指出问题核心:不是模型参数不够多,而是缺乏足够有挑战性的训练数据。

换句话说,别死记硬背了,来做点“真题”吧。

他们提出了一种构建高质量QA对的方法WebExplorer。

用该方法构建的数据集去训练,即使是较小的模型,也可以在复杂、长程的搜索任务上超越更大的模型。

训练后的8B模型支持高达128K的上下文长度和100次工具调用轮次的长期推理,能在参数量低于10B的模型中取得顶尖结果。

网友评价:用模型驱动的方式做探索,确实比传统图谱方法更能让智能体的浏览行为变灵活。

模型及数据集均已开源,链接可见文末。

优质训练数据稀缺

随着大语言模型(LLM)的快速发展,智能体的能力边界不断扩展。

网络搜索智能体作为这一发展的重要组成部分,能够自主地从广泛的在线资源中检索信息;长视野(Long-Horizon)网络智能体更是需要在多个网站间进行复杂的推理和搜索。

可是呢,现有的开源网络智能体在处理复杂搜索任务时往往表现有限,更强大的商业模型又缺乏透明的训练细节。

港科大联合MiniMax团队提出,开发高能力网络搜索智能体,根本在于提升训练数据的质量。

当前的评测基准已经发展到了极其困难的程度:例如,在BrowseComp-en基准测试中,超过一半的问题连人类标注者都无法在两小时内解决。虽然这样的难题在典型用例中很少见,但构建高质量、困难的QA对,对于开发能够实现超人性能的信息搜索智能体至关重要。

不过目前的常见方法都有局限性,可能带来不自然的查询表达和有限的合成灵活性。

针对上述问题呢,研究团队提出了一个新颖的两阶段方法WebExplorer——

使用创新的探索-演化框架,就能创建出需要多步推理和复杂网络导航的高难度QA对。

该框架的第一阶段是模型驱动的探索(Model-Based Exploration),让模型更自主灵活地探索信息空间。

具体来说,从一个种子实体开始,系统利用强大的LLM,通过迭代搜索和浏览操作来模拟图构建过程。

这种方法能够灵活、动态地探索与种子实体相关的信息空间。然后,基于这个初始的信息空间,模型再来构建初步QA对。

初步QA对相对简单,于是WebExplorer引入了第二阶段的迭代查询演化(Iterative Query Evolution)过程。

这一阶段通过系统地移除明确线索和引入战略性模糊,来提高查询难度。

简单地说,这种方法采用”从长到短”的演化策略,通过以下三个战略方向改进查询:

1、移除显著信息:去掉过于明显的提示 2、引入战略性模糊化:对日期、地点和专有名词等具体细节进行模糊处理 3、寻找替代描述:用模糊的描述符替换原始的明确引用

例如,一个初始查询可能包含“这位球员44岁时去世”这样的明确信息,经过演化后变成模糊的描述如“这位球员于中年去世”,需要更多探索性搜索尝试才能到达正确答案。

通过这个探索-演化过程,研究团队构建了WebExplorer-QA数据集,包含大约4万个演化后的最终问答对。

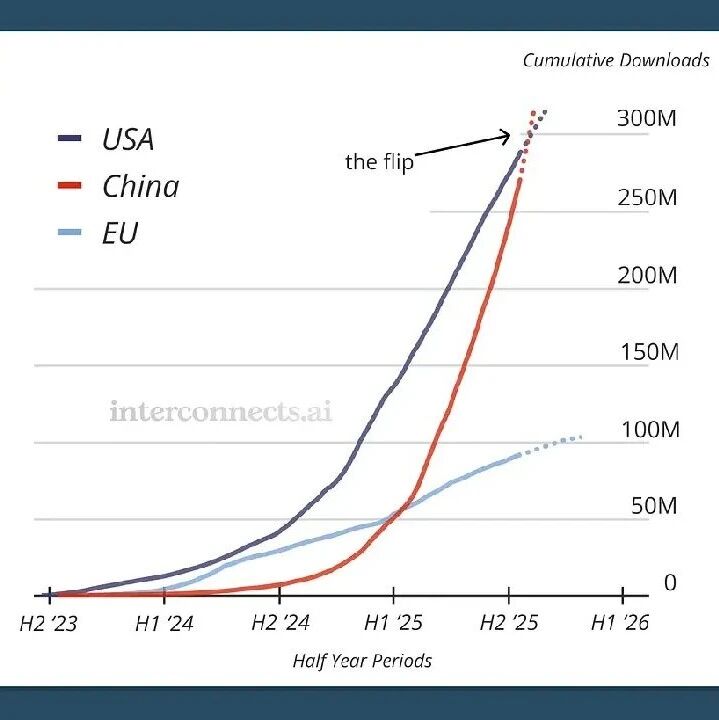

为了验证数据质量,他们使用Claude-4-Sonnet模型进行了全面的比较分析。上图为工具调用次数分布的比较,左边显示初始问答对vs演化问答对,右边显示演化问答对vs BrowseComp-en。

可以看到,演化过程有效增加了解决问题所需的工具调用次数。

演化过程的效果显著:强性能商业模型的准确率从86.6%大幅下降到67.1%,而解决问题的平均工具调用次数从7.9次显著增加到9.9次。这表明演化过程成功创建了需要广泛多步推理和探索的复杂查询。

研究团队使用得到的WebExplorer-QA,用监督微调+强化学习两段式的经典训练法,训练出8B大小的WebExplorer-8B。该模型在多个信息搜索基准测试中取得了同等规模下的最先进性能。

数据质量比模型规模更重要

WebExplorer-8B基于Qwen3-8B模型训练,实现了支持128K上下文长度和100次工具调用的长视野推理。

尽管只有8B参数,WebExplorer-8B在多个基准测试中持续超越了更大的开源模型。

WebExplorer-8B在强化学习训练后能够平均高效搜索16轮,在BrowseComp-en/zh上实现了比WebSailor-72B更高的准确率,并在WebWalkerQA和FRAMES数据集上取得了小于100B参数模型中的最佳性能。

此外,尽管WebExplorer的问答对合成方法受到BrowseComp-en的启发,但该模型在不同基准测试和领域中都表现出了有效的泛化能力。

哪怕训练数据并非专注于STEM领域,该模型在学术前沿基准HLE上也取得了17.3%的成绩,超越了之前的32B模型,进一步验证了这种方法的稳健性和可转移性。

研究团队表示,WebExplorer方法为训练高级网络智能体提供了一条实用的路径。证明了通过精心设计的数据合成方法和训练策略,较小的模型可以在复杂任务上超越更大的模型。

这种参数效率对于AI技术在资源受限环境中的应用和部署具有重要意义。

也有网友表示:这种方法看起来很有前景。

你怎么看?

参考链接:https://x.com/WenhuChen/status/1965537550937792934

论文地址:https://arxiv.org/abs/2509.06501

Github:https://github.com/hkust-nlp/WebExplorer

模型:https://huggingface.co/hkust-nlp/WebExplorer-8B

数据集:https://huggingface.co/datasets/hkust-nlp/WebExplorer-QA

一键三连「点赞」「转发」「小心心」

欢迎在评论区留下你的想法!

— 完 —

🏆 年度科技风向标「2025人工智能年度榜单」评选报名开启啦!我们正在寻找AI+时代领航者 点击了解详情

❤️🔥 企业、产品、人物3大维度,共设立了5类奖项,欢迎企业报名参与 👇

一键关注 👇 点亮星标