在「机器人自主操作」这一核心问题上,自变量正在用自研具身基础模型给出全新的回应……

自变量机器人CTO王昊 和 physical intelligence 的研究员柯丽一鸣(Kay Ke)就「长尾问题、数据采集、缺乏统一维护平台」等问题挑战,展开了一期对谈。

与以往“有限开放”的伪开源不同,自变量此次「真开源」彻底打破了技术壁垒,输入输出支持语言、视频、动作等多模态数据,具备因果推理、空间感知与反思优化能力等。

为什么这一步重要?

这意味着,从“看 Demo”到“跑闭环”,门槛被实打实地压低。无论你是做场景落地,还是做教学与竞赛,WALL-OSS 都更像一块随手可用的“底座”:路线对了(端到端),材料齐了(真开源),路径短了(可复现)。

当然,这也只是自变量以开放姿态推动整个具身智能领域走向成熟的第一步……

论文题目:Igniting VLMs toward the Embodied Space

发文机构:X SQUARE ROBOT TEAM(自变量机器人)

论文地址:https://x2robot.cn-wlcb.ufileos.com/wall_oss.pdf

项目主页: https://x2robot.com/en/research/68bc2cde8497d7f238dde690

代码链接:https://github.com/X-Square-Robot/wall-x

我们开设此账号,想要向各位对【具身智能】感兴趣的人传递最前沿最权威的知识讯息外,也想和大家一起见证它到底是泡沫还是又一场热浪?

端到端已成默认

WALL-OSS补上“可复现”

图1|当前的视觉语言模型(VLMs)在具身智能中的空间理解和动作执行能力上存在不足。这一缺陷源于现有预训练的VLMs能力与具身任务所需的特定知识之间的不匹配。WALL-OSS释放了VLMs的具身潜力,从而增强了具身理解能力,并能够生成复杂的动作©️【深蓝具身智能】编译

WALL-OSS架构与训练方法

WALL-OSS 的核心目标,是打造基于 Transformer 的开源具身基础模型 —— 通过全新架构设计与训练方案,强化空间理解能力并实现高质量动作生成。

模型架构

图2|WALL-OSS的架构©️【深蓝具身智能】编译

统一的跨层级思维链(Unified Cross-Level CoT)

高层次语义推理:精准理解用户指令背后的任务目标,依托具身视觉问答(VQA)数据与多场景指令数据训练强化语义理解能力(开源代码包含对应训练数据与模型权重); 子任务规划:将复杂任务拆解为可执行步骤(如 “清洁桌面” 拆解为 “移开物品→擦拭表面→归位物品”); 细粒度动作生成:输出标准化、细粒度的连续动作轨迹(如关节角度、位置坐标)通过统一硬件形态规范(如坐标帧、控制频率)与动作协议适配逻辑,可适配桌面臂、移动机器人等常见硬件,经具体硬件驱动转换后即可执行。

与现有的管道式或多模块系统不同,WALL-OSS采用了一个端到端的模型,避免了非可微接口的限制,从而减少了错误累积,提升了系统整体性能。在推理过程中,Uni-CoT可以根据任务的不同需求,灵活决定是否需要进行子任务分解或者直接生成动作。

数据组成与训练

为解决具身模型训练中 “数据稀缺、场景单一” 的痛点,WALL-OSS提供了多源融合数据集的构建方案(含数据标注规范、开源数据集的列表和标准化接入协议),开发者可基于此快速扩充训练数据,覆盖更多具身场景。

图3|多源数据集概述。左侧:来自三个来源的组成(自收集动作、开源动作和多模态VQA)。中间(从上到下):自收集动作、开源动作和多模态VQA的示例图像。右上角:我们的代表性机器人硬件©️【深蓝具身智能】编译

自收集的机器人动作数据:涵盖了桌面臂、移动支架、双臂系统等多种平台,涉及厨房清洁、装配、取放物品等任务。通过精细的标注和质量控制,确保了数据的高质量和任务复杂性。

开源动作数据:整合了DROID、BC-Z、BRIDGE等开源数据集,确保了跨形态、跨环境的泛化能力。

多模态VQA数据:通过自收集的轨迹数据生成的VQA,进一步增强了模型在空间-时间和任务推理方面的能力。

通过这些数据的结合,WALL-OSS不仅能够强化模型的空间理解能力,还能提升其长时间任务执行的成功率和指令跟随能力。

训练方法

WALL-OSS的训练过程分为两个主要阶段:启发阶段(Inspiration Stage)和集成阶段(Integration Stage)。

这两个阶段相辅相成,共同帮助模型在具身任务中建立起强大的能力。

视频1|两阶段的训练策略使WALL-OSS能够更好的从多模态数据中学习到动作执行的关键特征,从而提升执行长时间复杂任务的表现,视频为一个清理地面垃圾的演示DEMO;值得注意的是,机器人只接收到了“”清理地面垃圾”的指令(而不是“把垃圾丢进垃圾桶”),一切动作都由WALL-OSS自行决策生成©️【深蓝具身智能】编译

启发阶段:

在这个阶段,WALL-OSS将其与具身视觉问答(VQA)任务相结合,以增强空间推理能力。通过使用掩码语言建模、图像/视频-文本对比学习、指令跟随等多种训练目标,模型在具身场景中获得了强大的VL先验知识。

此外,启发阶段还引入了离散动作建模,通过FAST标记化方法将文本与离散动作标记对齐,使得模型具备了初步的动作理解能力。

集成阶段:

在集成阶段,WALL-OSS通过流匹配方法(flow matching)取代离散动作预测,转向连续动作建模。

集成过程分为两个子阶段:

① 第一阶段冻结VLM,仅训练动作部分的 flow head;

② 第二阶段解冻VLM并联合优化。这一过程中,视觉、语言和动作特征通过注意力机制进行交互,确保模型在执行多模态任务时能够高效整合信息。

通过实验可以看出,在启发阶段,模型通过学习离散动作建模和空间推理,获得粗略的动作理解能力;在集成阶段,模型则进一步通过流匹配方法,进行连续动作的精细建模,从而有效提升了模型的多模态任务执行能力。

实验

在本部分,我们将深入解读WALL-OSS在多个具身任务中的表现,分析其与基准模型的对比结果,突出其在语言理解、推理、长时间任务规划、动作准确性等方面的优势。

实验设置与任务设计

为了全面评估WALL-OSS的能力,自变量作者设计了一个包含具身视觉问答(Embodied VQA)基准和六个机器人操作任务的评估套件。

这个评估套件从三个核心维度来考察模型的表现:语言指令理解、推理与泛化能力;长时间、多阶段任务的规划与执行;以及动作的准确性与鲁棒性。

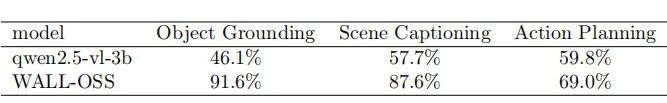

具身视觉问答(Embodied VQA):

包括三个任务,分别为场景描述、物体定位和动作规划。通过这一基准,作者评估了WALL-OSS在具身场景理解方面的优势。

机器人操作任务:

设计了六个操作任务,涵盖了指令跟随、推理能力、长时间规划以及动作准确性等方面,评估模型在实际任务中的表现。

图4|微调过程中使用的评估任务概述。顶部:单一指令任务(拾起垃圾、按颜色放置、指令-拾取-放置、拾取-放置-杯子)。底部:长时间跨度和推理任务(摆放餐具、拼字、整理卧室)©️【深蓝具身智能】编译

例如,Pick-Place任务(拾取并放置任务)测试了模型对新物体的Zero-shot泛化能力;Set-Table和Tidy-Bedroom任务则考察了模型在长时间规划中的表现。

具身场景理解(Embodied VQA)

通过Embodied VQA基准,WALL-OSS展示了其在具身场景理解方面的巨大优势。

在物体定位(Object Grounding)任务中,WALL-OSS表现更为精准;

在场景描述(Scene Captioning)任务中,WALL-OSS能准确描述机器人操作的动作;

在动作规划(Action Planning)任务中,WALL-OSS能提供更具体的响应,展现了其对任务进度的清晰理解。

这些结果表明,WALL-OSS通过预训练策略,成功注入了机器人特定的场景知识,为后续操作任务的执行奠定了基础。

表1|WALL-OSS具身问答任务评估结果©️【深蓝具身智能】编译

Zero-shot指令跟随(Pick-Place系列)

在预训练阶段提升了场景理解后,接下来评估了WALL-OSS在没有任务特定微调的情况下,能否成功跟随新的指令并执行操作。

在Pick-and-Place任务中,WALL-OSS分别在看到过的物体指令和未见过的新物体指令下进行测试。

结果显示,WALL-OSS能够在看到的物体指令上达到85%的任务进度,并在未见过的新物体指令上保持61%的表现。这些失败大多与选择抓取或放置位置的微小姿态不准确有关,而非语义误解。

这一结果表明,WALL-OSS能够有效理解并执行新任务,证明了其强大的Zero-shot泛化能力。

图5|WALL-OSS与最先进策略在所有评估任务中的性能比较。左侧:分布内(ID)性能比较。右侧:分布外(OOD)性能比较©️【深蓝具身智能】编译

动作准确性与泛化能力(与π0、Diffusion-Policy并列)

WALL-OSS在动作准确性和泛化能力方面也表现优异。

在Collect-Waste任务中,预训练模型(WALL-OSS和π0)在入库任务(In-Distribution,ID)上的成功率达到了100%,而未预训练的Diffusion-Policy(DP)模型仅为80%。

然而,随着任务复杂度的增加和数据的减少,预训练模型的表现优势更加明显。

在Pick-Place-Cup任务(500个演示样本)中,WALL-OSS和π0的成功率超过90%,而DP的成功率低于20%。

在Out-of-Distribution(OOD)测试中,当任务环境发生变化时,DP的成功率从80%降到0%,完全未能完成任务。

相比之下,WALL-OSS和π0在新环境下仍能维持较高的成功率(超过80%)。这一结果强调了预训练在提高模型泛化能力和少量数据学习中的重要性。

长时间任务的子任务生成提升表现

长时间任务由于任务复杂性、监督延迟以及执行错误的累积,通常是具身智能模型面临的重大挑战。

WALL-OSS通过动态地将高层目标分解为中间子任务,显著提高了任务成功率和执行稳定性。

在Set-Table和Tidy-Bedroom这两个长时间任务中,WALL-OSS的表现远超其他基准模型(如π0和Diffusion-Policy)。尽管只有1%的训练数据标注了子任务,WALL-OSS依然能高效地生成高质量的子任务指令,并在推理时利用这些子任务来指导动作生成。

与基准模型相比,WALL-OSS能更好地维持任务进度,并避免因缺乏子任务指导而出现的重复和错误动作。

视频2|长时间任务的规划执行演示(给两位客人摆好餐具)©️【深蓝具身智能】编译

思维链(CoT)增强了具身规划与推理

复杂的具身任务常常需要对空间关系、物体属性和连续动作的后果进行推理。为了弥补现有VLA模型在推理和执行之间的鸿沟,WALL-OSS引入了思维链(CoT)机制。

在Place-by-Color和Block-Spell任务中,WALL-OSS能够生成中间推理痕迹,并通过这些推理来指导动作生成。

在Place-by-Color任务中,WALL-OSS在要求文本推理的情况下,显著超过了所有基准模型,达到了更高的任务完成率。相比之下,直接动作模型仅能完成视觉直观的任务,而CoT机制则是解决需要中间推理任务的关键。

视频3|机器人的推理能力展示(机器人需要执行place-by-color任务,把球放到写有对应颜色的纸上)©️【深蓝具身智能】编译

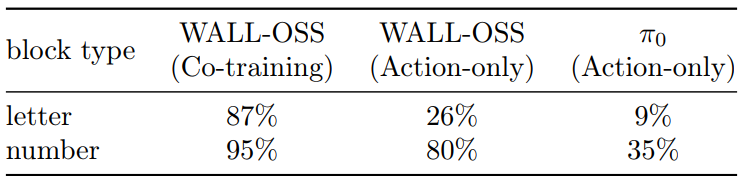

多模态联合训练提升细粒度指令跟随

WALL-OSS通过多模态联合训练,在细粒度指令跟随方面表现出色。

在Block-Spell任务中,WALL-OSS相比π0表现出更高的精度,尤其在正确选择字母块的任务中,WALL-OSS能更好地理解并执行精确的指令。

通过联合训练,WALL-OSS能够更好地理解细粒度的视觉和语言线索,从而提升模型的执行能力。

表2|WALL-OSS在Block-Spell任务中的指令遵循准确率©️【深蓝具身智能】编译

总结

在当下的智能机器人领域,硬件制造有如宇树这样的标杆企业引领方向,而在决定机器人 “思考能力” 的智能大脑研发上,自变量机器人正凭借创新成果崭露头角。

当端到端VLA 已成主流,真正拉开差距的,是模型效果和应用效率。

WALL-OSS的发布远不止是一个具身模型那么简单。它以 “全链路可复现” 为核心,将预训练权重、训练代码、数据集接口和部署文档打包开放,彻底解决了开发者在落地过程中 “缺零件” 的痛点,真正实现了 “拿过来就能用” 的便捷性,让不同资源背景的团队都能在自有机器人上快速验证和迭代技术。

在具身智能这场长期竞赛里,这份开源方案,既是给开发者的实用工具,更是给整个行业的 “加速度”,让具身智能的发展从 “单点突破” 走向 “集体冲刺”,朝着更开放、更高效的未来迈进。

接下来最值得关注的,是与π0.5 的并列量化(长程任务、推理型指令、OOD 与资源效率),以及轻量化部署与课程化实训的打磨:前者决定“跑得多远”,后者决定“落得多深”。

我们拭目以待……

编译|阿豹

审编|具身君

相关视频:《临近机器人GPT-3时刻,具身智能开源模型的加速演进》

工作投稿|商务合作|转载

:SL13126828869(微信号)

>>自主机器人技术研讨会早鸟报名【倒计时8天】<<

为促进自主机器人领域一线青年学者和工程师的交流,推动学术界与企业界的深度交融与产学研合作,中国自动化学会主办了自主机器人技术研讨会(Autonomous Robotic Technology Seminar,简称ARTS)。

基于前两届大会的成功经验和广泛影响,第三届ARTS将继续深化技术交流与创新,定于2025年10月18日-19日在浙江大学(杭州)举办。我们诚挚邀请您参加,并欢迎您对大会组织提供宝贵意见和建议!

【具身宝典】具身智能主流技术方案是什么?搞模仿学习,还是强化学习?|看完还不懂具身智能中的「语义地图」,我吃了!|你真的了解无监督强化学习吗?3 篇标志性文章解读具身智能的“第一性原理”|解析|具身智能:大模型如何让机器人实现“从冰箱里拿一瓶可乐”?|盘点 | 5年VLA进化之路,45篇代表性工作!它凭什么成为具身智能「新范式」?动态避障技术解析!聊一聊具身智能体如何在复杂环境中实现避障

【技术深度】具身智能30年权力转移:谁杀死了PID?大模型正在吃掉传统控制论的午餐……|全面盘点:机器人在未知环境探索的3大技术路线,优缺点对比、应用案例!|照搬=最佳实践?分享真正的 VLA 微调高手,“常用”的3大具身智能VLA模型!机器人开源=复现地狱?这2大核武器级方案解决机器人通用性难题,破解“形态诅咒”!|视觉-语言-导航(VLN)技术梳理:算法框架、学习范式、四大实践|盘点:17个具身智能领域核心【数据集】,涵盖从单一到复合的 7 大常见任务类别||90%机器人项目栽在本地化?【盘点】3种经典部署路径,破解长距自主任务瓶颈!|VLA模型的「核心引擎」:盘点5类核心动作Token,如何驱动机器人精准操作?

【先锋观点】周博宇 | 具身智能:一场需要谦逊与耐心的科学远征|许华哲:具身智能需要从ImageNet做起吗?|独家|ICRA冠军导师、最佳论文获得者眼中“被低估但潜力巨大”的具身智能路径|独家解读 | 从OpenAI姚顺雨观点切入:强化学习终于泛化,具身智能将不只是“感知动作”

【非开源代码复现】非开源代码复现 | 首个能抓取不同轻薄纸类的触觉灵巧手-臂系统PP-Tac(RSS 2025)|独家复现实录|全球首个「窗口级」VLN系统:实现空中无人机最后一公里配送|不碰真机也不仿真?(伪代码)伯克利最新:仅用一部手机,生成大规模高质量机器人训练数据!

我们开设此账号,想要向各位对【具身智能】感兴趣的人传递最前沿最权威的知识讯息外,也想和大家一起见证它到底是泡沫还是又一场热浪?

欢迎关注【深蓝具身智能】👇

【深蓝具身智能】的内容均由作者团队倾注个人心血制作而成,希望各位遵守原创规则珍惜作者们的劳动成果。

投稿|商务合作|转载:SL13126828869(微信)

点击❤收藏并推荐本文