别再只盯着大模型竞技场了!具身智能的“终极排位赛”——Embodied Arena 刚刚上线。

作者丨汤宏垚

具身智能是当前最为火热的研究领域之一,然而,面对海量的模型和基准测试,研究者们常常陷入茫然和困惑——哪些模型的综合具身能力最强?如何客观评价具身AI模型的能力边界?未来具身模型的演进应该朝着什么方向努力?近日,由国内外10余家顶尖院校和研究机构联合推出的Embodied Arena正式发布。

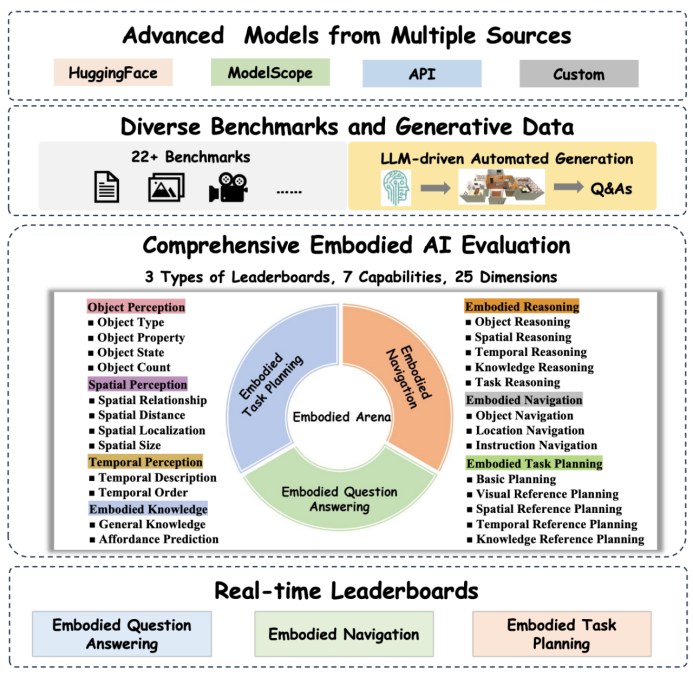

Embodied Arena是一个全面、统一、持续演进的具身AI评测平台,聚焦通用具身大脑能力,涵盖22+基准测试和30+代表性模型,建立基准全面、能力体系完备的综合评估体系,并通过深度分析揭示了七大关键技术洞察,为未来具身模型的发展方向提供了重要指引。

01

具身AI作为通向AGI的关键路径,一直面临三大核心挑战:

1.能力定义不清:缺乏对具身AI核心能力的系统性理解

2.评测标准缺失:各个基准测试标准不一,无法横向对比

3.数据获取瓶颈:缺乏可扩展的自动化数据生成方法

Embodied Arena通过构建系统性具身大脑能力分类、统一具身评测基础设施和LLM驱动的自动化具身数据生成框架,试图解决这三大难题。

02

平台覆盖3大核心任务类型,构建完整评估体系:

具身问答:涵盖2D/3D视觉问答,评估多模态感知、理解、推理能力

具身导航:包含物体导航、位置导航、指令导航,多方面检验具身导航能力

具身任务规划:多层级规划能力评估,考察复杂任务理解、拆分、规划能力

03

Embodied Arena建立了业界首个系统性具身AI大脑能力分类法,涵盖7大核心能力、25个细分维度:

物体感知(Object Perception)

通过视觉输入识别和理解具身环境中的物体。包含物体类型识别、物体属性判断(颜色、形状、材质等)、物体状态检测(开/关、静止等)、物体数量计数四个维度。

空间感知(Spatial Perception)

通过视觉分析理解3D环境中的空间关系和定位。涵盖空间关系判断、空间距离估算、空间位置定位、空间尺寸估计四个维度。

时序感知(Temporal Perception)

理解具身场景中的时序事件和时序关系。包括时序事件描述和时序顺序判断两个维度。

具身知识(Embodied Knowledge)

在具身情境中应用通用知识和具身知识。涵盖通用知识运用和可供性预测两个维度。

具身推理(Embodied Reasoning)

在具身场景中的多维度推理能力。包含物体推理、空间推理、时序推理、知识推理、任务推理五个维度。

具身导航(Embodied Navigation)

在复杂环境中进行不同类型引导的导航能力。涵盖物体导航、位置导航、指令导航三个维度。

具身任务规划(Embodied Task Planning)

复杂具身任务的策略规划和执行能力。包含基础规划、视觉参考规划、空间参考规划、时序参考规划、知识参考规划五个维度。

这一分类法不仅为现有22+基准测试提供了统一的能力映射框架,更为具身AI大脑研究建立了清晰的技术评估标准和技术路线图。

04

Embodied Arena采用模块化设计,实现了从模型接入到结果分析的完整评测流程:

多源模型支持:兼容HuggingFace、ModelScope、API等多种接入方式,已集成30+先进模型

跨基准跨模型统一的评测管线:对齐不同基准集数据与不同模型的评测接入方式,统一计算并呈现对比评测结果

自动化数据生成:基于LLM的场景生成和能力导向数据演进机制,确保评测数据的多样性和时效性

实时排行榜:提供具身基准数据集视角和具身能力视角双重对比,每双周更新,为研究方向提供精准指引

05

传统具身AI评测基准面临数据分布固定、可扩展性与多样性受限的挑战。Embodied Arena引入了LLM驱动的自动化数据生成框架来解决上述挑战,包含两个关键组件:

自动化场景生成:

场景规划:定义房间类型和空间关系

功能分区:将房间划分为活动特定区域

布局优化:放置物体并优化物体布局

能力导向数据演进:

构建数据生成流程:构建仿真驱动的程序化数据生成流程,包含了任务定义,模板构建,场景生成,基于仿真与脚本的数据生成以及数据筛选的关键阶段。

建立难度天梯:从场景复杂度、语言复杂度、任务复杂度三个方向构建数据模板,生成不同难度的数据,提升数据多样性。

动态数据演进:根据模型表现生成特定数据,并通过抽样检测保证数据质量,确保评测集始终具有挑战性。

06

通过对30+模型在22+基准上的全面评测,Embodied Arena揭示了具身AI领域的七大关键洞察:

1. 业界领先的多模态基础模型领跑综合能力评测榜单,专有具身模型凭借针对性具身数据训练在相关特定基准上实现局部反超,但也暴露出针对单一基准的过拟合风险。

业界领先的通用多模态基础模型(如GPT-o3、Gemini-2.5-Pro)凭借其千亿级参数规模和海量预训练数据在多基准测试中相较具身模型取得10%-20%的评测指标领先,充分展现出跨任务的整体性能优势。然而,在相似参数规模下,通过针对性具身数据的训练,专用具身模型可以在特定基准上显著超越通用模型——RoboBrain2.0在Where2Place上准确率达到73.59%,远超GPT-o3的33.46%,专用导航模型在VLN任务上也明显优于同规模通用模型,如StreamVLN达到54.90%成功率,而Claude-3.7-Sonnet仅为18.93%。然而,在这种针对性具身数据增训之下,具身模型往往在特定基准测试中表现出色却在其他任务上大幅下滑,呈现出较大性能波动,暴露出"刷榜式"过拟合而非真正能力提升的问题,为模型的通用性和实际应用带来了潜在挑战。因此,如何在避免特定能力过拟合式优化的同时实现具身智能核心能力的全面均衡提升,将成为未来具身模型研究的重要方向。

2. 具身模型的物体/空间/时间感知和具身知识能力制约其高阶推理能力,物体感知和空间感知是基础能力中的短板。

多基准综合评估结果表明,模型基础具身能力的缺陷直接制约其高阶推理能力表现。具体体现为:模型的基础具身能力(物体感知、空间感知、时间感知、具身知识)与高阶推理能力呈显著正相关,斯皮尔曼等级相关系数ρ达0.80,且各项基础具身能力均与高阶推理能力呈显著正相关(ρ范围为0.68~0.77);同时,模型在高阶推理任务上的表现(平均得分33.64)总体差于其基础具身能力整体表现(平均得分38.84)。其中基础具身能力中,模型的物体感知(平均得分38.33)与空间感知(平均得分28.62)能力尤为薄弱,这些结果共同揭示模型高阶推理能力对基础具身能力的深度依赖性。

3. 具身感知与推理能力与下游任务性能显著正相关。相比端到端框架,任务导向智能体框架更能促进模型具身能力向下游任务性能转化。

模型在具身能力(物体感知、空间感知、时间感知、具身知识和具身推理)和下游任务(具身导航、具身任务规划)的综合排名表明,模型的具身能力与下游任务性能呈显著正相关 (斯皮尔曼等级相关系数ρ=0.80),且各项具身能力均与下游任务性能呈显著正相关 (ρ范围为0.73~0.83.)。框架对比实验进一步验证,采用任务导向智能体框架(即通用模型集成于下游任务专用智能体框架)时,模型具身能力与下游任务性能呈显著正相关(ρ=0.79),导航与任务规划成功率分别达36.21%和40.08%;而端到端框架(即通用模型直接应用于下游任务)仅呈中等相关性(ρ=0.40),导航成功率仅为5.80%,暴露出缺乏任务适配机制的显著能力短板。值得注意的是,当端到端框架因缺乏任务适配机制而表现不佳时,通过针对下游任务的架构创新与领域数据训练可使模型实现性能跃升(VLN专用模型导航成功率最高可达50%以上)。综上,强化具身能力是基础,优化智能体框架的能力转化机制是核心支撑,而构建下游任务专用模型则是实现垂直领域性能突破的有效路径。

4.具身任务下的Scaling Law尚未显现。参数规模的扩展无法带来一致的性能提升;增加具身数据虽可提升特定任务表现,但常伴随过拟合风险。

当前具身任务下尚未观察到明显的Scaling Law。在参数规模层面,部分模型(如InternVL3)在具身问答和任务规划任务中,增大参数规模能够带来性能提升;但在具身导航任务中,增大参数反而可能导致模型性能下降(如RoboBrain2.0-7B优于RoboBrain2.0-32B),这表明参数层面的Scaling Law并未普遍显现。在数据层面,增加具身任务特定数据虽可提升特定任务表现,但往往伴随过拟合风险,难以在所有能力上实现全面提升。例如,Embodied-R1与SpaceR均基于Qwen-2.5-VL-3B-Instruct训练,却均未在所有能力项上取得一致提升。这主要源于当前具身任务数据在多样性、广度和规模方面仍显不足。此外,现有具身模型的架构与训练方式不统一,且多数模型仅有一个或少数几个参数规模的版本,也限制了对具身模型Scaling Law 更全面深入的分析。

5. 推理模型通过RFT在多个基准测试上展现出强大的性能表现。在分布外泛化能力方面,RFT相较SFT的潜在优势有待进一步验证。

RFT能够显著增强推理模型在多项具身基准中的性能,并屡次刷新性能纪录。例如,GPT-o3在多种任务规划基准中表现优异,Space-R在OpenEQA上达到新SOTA,Embodied-R1在Affordance预测任务中实现突破,VLN-R1则进一步验证了RFT对导航成功率的提升作用。这表明,RFT有效促进了模型将基础感知能力整合为高阶推理技能,使其能够胜任多步推理、序列决策与精确操作等复杂任务。此外,经RFT训练的具身模型已展现出一定的分布外泛化潜力。以Embodied-R1为例,在经过RFT训练后,其在不同分布外基准测试中的性能均较仅使用SFT的版本有显著提升。因此,基于RFT的训练范式为具身智能的发展提供了极具潜力的路径,但其泛化能力的深度与广度仍需进一步探索和验证。

6. 原生3D信息处理方法面临多模态对齐的挑战,2D-3D融合框架凭借3D信息与2D视觉-语言基座能力的对齐机制,显著增强具身模型的空间理解与推理能力。

3D表征提供了完整空间结构和精确几何信息,因此是实现精确空间推理和物体交互的关键。然而,直接处理点云或体素的原生3D表征方法缺乏与2D视觉-语言基座能力的对齐,无法充分利用2D基座模型通过大规模视觉-语言预训练获得的丰富语义能力。3D具身问答能力评测表明,依赖原生3D表征的LEO为48.48分,而采用2D-3D表征融合的具身模型——GPT4Scene-HDM达到62.11分,LL3DA获得62.90分。这种显著差异反映出,在当前缺乏通用3D-语言基座模型的情况下,从零构建面向具身的3D几何与语言的对齐关系,不如在已有2D视觉-语言对齐基础上增强3D空间感知高效。尽管2D-3D融合框架已成为兼顾基座模型语义能力与精确空间感知的有效范式,其本质上仍属于目前过渡性质的妥协方案,长远来看,如何通过多阶段训练策略或设计创新性的模型架构,实现原生3D信息与语言的深度对齐,进而构建更为直接、高效的原生3D基座模型,是未来极具挑战性和前瞻性的关键研究方向。

7. 具身指向(Embodied Pointing)作为核心表征,能够驱动基础能力与下游任务的双重提升。然而,其在复杂具身任务中的潜力有待进一步发掘。

具身指向能够有效提升基础能力与下游任务性能,其核心在于充当了基础性的“锚定机制”(Grounding Mechanism)。该机制通过将抽象语言与精确物理坐标紧密关联,统一了感知、推理与规划等原本割离的子任务,显著增强了模型的认知整合能力。这种整合进而提高了模型在看似无关甚至分布外任务上的泛化表现。然而,这一潜力在当前实践中仍面临明显挑战。尽管经过指向数据微调的模型在特定基准测试中表现优异,但在应对复杂指令与动态场景时,其性能显著下滑。这表明模型可能仅仅“过拟合”了简单的指向模式,并未真正习得锚定所必需的综合推理能力,反映出专一化训练与通用推理之间的内在权衡。因此,如何系统掌握具身指向技术并高效运用相关训练数据,已成为推动先进具身智能发展的核心挑战,也为评估与增强模型多模态理解与推理能力提供了重要路径。

07

Embodied Arena采用开放式设计,欢迎全球研究者贡献:

模型提交:支持开源和闭源模型,提供专业技术支持

基准集成:新基准可灵活接入,保持评测体系与时俱进

双周更新:确保排行榜实时反映最新进展

访问地址:https://embodied-arena.com/

08

Embodied Arena通过建立全面的具身大脑能力分类体系、统一的评测基础设施和持续演进的自动化数据生成机制,不仅为当前研究提供了客观评估标准,更为具身AI的未来发展指明了清晰方向。

随着更多模型和基准的加入,Embodied Arena将持续为研究者提供最全面、最便捷的具身AI能力评估,助力构建真正理解和改变物理世界的智能体。

论文地址:http://arxiv.org/abs/2509.15273

平台访问:https://embodied-arena.com/

技术支持:欢迎通过官网联系团队

未经「AI科技评论」授权,严禁以任何方式在网页、论坛、社区进行转载!

公众号转载请先在「AI科技评论」后台留言取得授权,转载时需标注来源并插入本公众号名片。

未经「AI科技评论」授权,严禁以任何方式在网页、论坛、社区进行转载!

公众号转载请先在「AI科技评论」后台留言取得授权,转载时需标注来源并插入本公众号名片。