随着具身智能赛道的大爆发,如何推动人形机器人进化是当前的一大热门研究方向。

目前的主流训练范式是:将人类运动作为运动学参考进行运动重定向,进而训练强化学习(RL)策略。然而,现有运动重定向流程往往难以应对人类与机器人之间巨大的“形态差异”,会产生脚部滑动、(肢体/物体)穿透等不符合物理规律的异常现象。

更重要的是,常规运动重定向方法忽略了人与物体、人与环境之间丰富的交互信息——而这些信息对于机器人实现灵活的移动和移动操作至关重要。

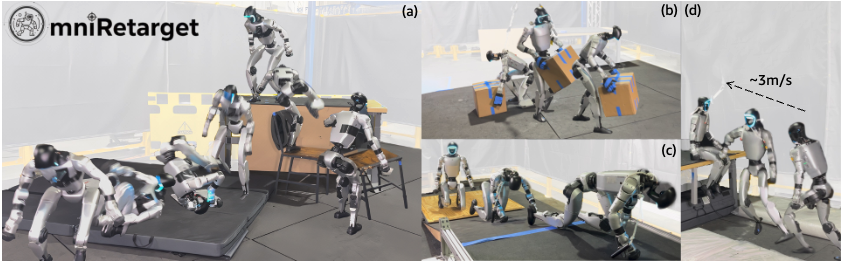

日前,Amazon FAR团队提出了OmniRetarget:一种基于 “交互网格”(interaction mesh)的交互保留式数据生成引擎,该引擎能明确建模并保留人形机器人、地形与被操作物体之间关键的空间关系和接触关系。

相比主流基准方法,该引擎在运动学约束满足度和接触关系保留方面表现更优,借助这类高质量数据,研究人员在宇树G1人形机器人上成功执行长时程(30秒)的跑酷(parkour)及移动操作技能,多名华人研究员主导了这项研究。

这些策略的训练与部署采用了极简且统一的方式:整个过程仅涉及5个奖励项、4个机器人域随机化参数,以及一个纯本体感知观测空间,且所有任务均共享这套设置。

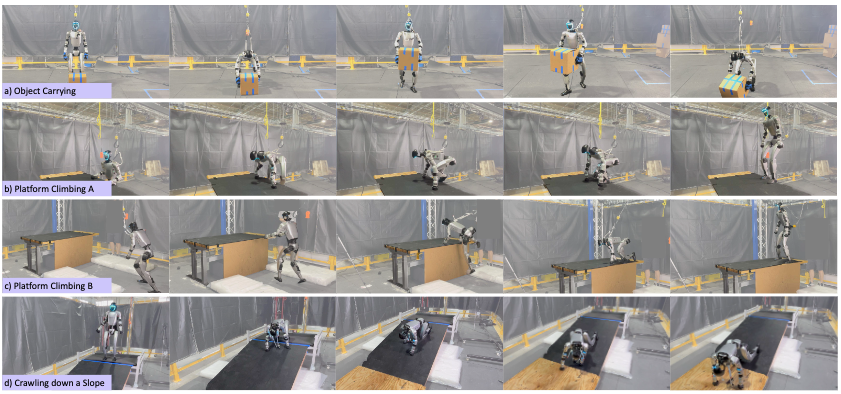

目前可以演示的行为包括:时长30秒的跑酷任务,涵盖移椅子、跨步跨越与支撑跳跃、跳跃翻滚动作;物体搬运;斜坡爬行;快速平台攀爬与坐姿调整等等。

人类演示数据通过基于“交互网格”的约束优化方法,被重定向至机器人端,每一项空间增强与形态增强(操作)均通过求解新的优化问题实现,最终生成多样化的轨迹,这些轨迹可作为强化学习(RL)训练的参考数据,整个训练过程仅需极少的奖励设计与域随机化操作。

在一系列多样化的全身交互任务中,基于OmniRetarget数据集训练的策略,在运动质量和鲁棒性上均优于基于以往重定向方法训练的策略。

总的来看,这项研究的贡献主要体现在四个方面:

1、提出首个具备交互保留特性的类人机器人运动重定向框架:该框架可处理丰富的机器人 - 物体 - 地形交互场景,同时施加严格的物理约束(确保运动符合物理规律)。

2、设计了一套系统化的数据增强流程:能将单一人类演示样本,转化为适用于不同机器人形态的、多样化且大规模的高质量运动学轨迹集合。

3、构建了一个大规模开源数据集:该数据集包含经运动重定向处理、且运动学层面可行的移动操作轨迹,可直接为类人机器人相关算法(如强化学习)的训练提供高质量数据支持。

Xiaoyu Huang是加州大学伯克利分校的博士生,对基于学习的移动(locomotion)/移动操作(loco-manipulation)方向感兴趣。

Yan(Rocky)Duan在FAR实验室开发机器人智能软件和算法,在此之前,曾是covariant.ai的联合创始人兼首席技术官,还曾在OpenAI担任研究科学家,他在加州大学伯克利分校获得博士学位,研究方向包括强化学习、机器人技术、无监督学习和元学习等。

石冠亚是卡内基梅隆大学机器人研究所和计算机科学学院的助理教授,领导LeCAR(敏捷机器人学习与控制)实验室,同时是FAR实验室学者。

其研究兴趣涵盖人工智能、机器人技术和控制的交叉领域,从理论基础、算法设计到现实世界中通用机器人系统(例如人形机器人)的整个领域,致力于为灵活多变的机器人开发可靠、自适应且高效的学习和控制方法,他本科毕业于清华大学,加州理工学院获得博士学位,华盛顿大学的博士后。

长期以来,要让类人机器人执行复杂的全身场景交互与物体交互任务,始终受限于一个核心的数据瓶颈。

研究人员在论文中表示,OmniRetarget体现了一种范式转变:不再依赖复杂的奖励设计去修补低质量参考运动,而是通过有原则的(principled)数据生成从根源上解决问题。