点击下方卡片,关注「3D视觉工坊」公众号

选择星标,干货第一时间送达

来源:深蓝AI

「3D视觉从入门到精通」知识星球(点开有惊喜) !星球内新增20多门3D视觉系统课程、入门环境配置教程、多场顶会直播、顶会论文最新解读、3D视觉算法源码、求职招聘等。想要入门3D视觉、做项目、搞科研,欢迎扫码加入!

导读

在GPS失效或视角巨大变化的场景中,传统机器人定位方法常常失灵。MIT 与 UCSD 团队带来全新方案——ROMAN,它能基于 LiDAR+RGB-D 构建的“对象地图”,在全球尺度上快速配准,即便机器人沿相反方向行进也能互相闭环。更妙的是,它巧妙引入了对象形状、语义信息以及重力方向,利用图论算法在多机器人SLAM中实现稳健闭环,令定位误差降低 35%。在城市、森林甚至异构空地-空中场景都表现出色。

图1|两台机器人在非铺装道路环境中沿相反方向行驶时,各自构建的分段子地图匹配结果。由所提出的方法找到的关联分段通过直线连接,并投影到图像平面上。(上图)每对已匹配的分段以相同颜色绘制,未匹配的分段以随机颜色显示,所有其他背景点以灰色表示。(下图)在原始图像观测中可视化相同的匹配分段及其凸包。更多可视化示例可见于补充视频

论文出处:RSS2025

论文标题:ROMAN: Open-Set Object Map Alignment forRobust View-Invariant Global Localization

论文作者:Mason B. Peterson, Yixuan Jia, Yulun Tian, Annika Thomas, and Jonathan P. How

论文链接:https://www.roboticsproceedings.org/rss21/p029.pdf

全球定位(global localization)是实现长期、无漂移机器人导航的核心组成部分。在没有 GPS 的场景中,机器人通常需要基于之前所见环境的地图来实现重新定位。为了从感知到的场景中恢复机器人在全局坐标系中的位姿,已经开发了多种方法,通常基于图像或 LiDAR 特征来建立场景之间的对应关系。

然而,当视角发生显著变化(例如当机器人沿相反方向移动)或当存在遮挡、动态物体、环境变化(如照明和季节)时,这些传统方法往往容易失效。特别是在大尺度户外环境中,结构化特征(例如角点或边缘)较少出现,使得基于几何特征的定位方法变得不稳定。与此同时,基于图像的端到端回归方法通常难以泛化到训练之外的场景,尤其是在与训练数据分布差异较大的未知环境中。

近年来,随着语义 SLAM 以及使用对象级语义与几何信息来增强建图和定位的技术的兴起,对象成为一个有前景的中间表示。然而,现有工作主要集中在使用对象进行局部约束(如构图优化中的边)或短期闭环检测,而并未充分探索在更大空间尺度、异构环境甚至不同传感器模态下,利用对象地图进行稳健的全球定位。

为此,本文提出了一种基于对象的全局定位框架,称为 ROMAN(Robust Object Map Alignment Anywhere)。其核心思想是将定位问题表述为开放集(open-set)、视角不变的对象地图之间的配准问题,并将其转化为一个基于图论的全局数据关联问题。ROMAN 的关键创新包括:

1. 在对象地图中引入重力方向先验,以提高不同视角下的几何一致性。

2. 融合对象的形状与语义相似性信息,显著增强开放集对象数据关联的鲁棒性。

3. 提出了一种可在多机器人或多时序场景中使用的全局对象地图对齐算法,实现跨大范围、异构场景的定位。

通过在室内、城市以及森林等具有挑战性的环境中进行的全局定位实验,ROMAN 显示了比基于图像的位姿回归方法或基于分段的几何匹配方法更优的定位精度。此外,当将 ROMAN 集成到一个多机器人 SLAM 系统中用作闭环检测模块时,其轨迹估计误差相比于采用传统视觉特征的闭环方法降低了 35%,显著提升了整体地图一致性。

图2|全文方法总览;ROMAN 使用前端建图模块来构建开放集对象的地图,并以对象的重心和特征描述符来表示每个对象。局部的对象集合被聚合为子地图,通过在两个子地图之间匹配对象来实现全局定位。该方法利用图论形式化,结合对象形状与语义相似性以及重力先验,从而实现精确的数据关联。

A. 系统概览

ROMAN 的核心思想是通过对齐基于对象的稀疏地图,实现大范围、视角不变、开放集的全局定位。这一框架分为三个主要步骤:

对象地图生成

首先使用基于 RGB-D 或 LiDAR 的分割和跟踪算法,生成稀疏对象地图。每个对象被表示为其几何体(如体素化的点云或多边形网格)、语义标签(如“树”、“车辆”)以及在地图中的重心位置。该地图可以看作是由多个对象节点及其属性构成的集合。

数据关联建图(Graph Formulation)

将对象地图配准问题建模为图匹配问题。每个对象视为图中的一个节点,对象间的几何和语义相似性用于计算节点之间的匹配权重。通过构建这种图结构,可以有效地将全局定位转化为在两张对象地图间寻找最大匹配子图(maximal matching subgraph)的问题。

优化求解与位姿恢复

在得到的对象匹配对基础上,利用重力方向先验约束,通过最小化对象重心间的平方误差来优化位姿变换。最终求解出两张对象地图之间的 6-DoF 刚体变换,实现全局定位。

图3|改进后的亲和度指标可视化。基于重力的距离分数用于促进与重力方向一致的配对关联,而基于语义和形状的分数分别用于鼓励各个关联在几何形状和语义上的一致性

B. 对象地图与重力方向对齐

为了提升不同视角下对象几何关系的一致性,ROMAN 特别引入了基于 IMU 或 LiDAR 自身推导的重力方向估计,将所有对象地图在生成时即对齐到重力向量,从而显著减少因滚转(roll)或俯仰(pitch)角变化带来的几何偏差。

C. 融合形状与语义的对象匹配

ROMAN 在对象匹配过程中同时考虑对象的几何形状与语义标签信息。具体地:

形状相似性:通过对比对象表面的体素分布、边界框尺寸等几何特征,计算形状一致性分数。

语义一致性:利用对象的语义预测分布,结合类别相似度矩阵,赋予不同标签间合理的匹配权重。

这样可以在开放集场景下处理“未知类别”,例如机器人在新环境中遇到未标记的家具或自然物体时,依然能通过形状匹配建立合理的对应关系。

D. 图论优化求解

在建立对象间的相似性图后,ROMAN 将对象地图配准问题形式化为最大加权匹配子图搜索(maximal weighted subgraph matching):

● 节点之间的边权由形状和语义的相似度综合计算。

● 通过图论优化算法,选出一组最大一致的对象对。

● 在这些匹配的对象对之上,利用最小二乘法求解刚体变换矩阵,实现全局配准。

这种全局视角避免了传统 ICP 那种容易陷入局部最优的问题,并使其在大范围、稀疏对象地图中依然能够稳健工作。

E. 多机器人与异步闭环

ROMAN 的框架天然支持在多机器人系统中实现异步闭环检测:

● 不同机器人在不同时间构建的对象地图可以通过上述机制进行快速对齐。

● 即使机器人沿相反方向行驶,或在完全不同的时间段访问同一地点,也能基于对象结构成功实现全局闭环。

A. 实验设置与测试环境

为全面验证 ROMAN 的性能,作者在多种具有挑战性的环境中开展了大量实验:

● 室内场景:如房间、走廊,主要考察多视角下的小尺度全局配准能力。

● 城市户外:典型的街区与道路,包含车辆、行人等动态物体。

● 森林与自然场景:稀疏的树木、灌木带来非结构化的对象分布,极具挑战。

此外,还专门设置了机器人在沿相反方向行驶的场景,用于检验 ROMAN 在视角完全逆向时的闭环能力。

所有实验均在多模态传感器配置下进行,包括激光雷达(用于生成 LIDAR 对象地图)与 RGB-D 摄像头(提供额外的语义信息与深度补全)。

1) 图像回归与分段配准方法

首先小编带大家一起看看作者的对比实验,作者将 ROMAN 与两大类主流基线进行了比较:

● 基于图像的端到端位姿回归:直接从输入图像预测位姿变化。

● 基于分段的几何配准:例如采用语义分割后做分段 ICP 或点云配准。

结果表明:

● 在不同环境、不同视角间,ROMAN 的配准误差明显低于基线。

● 特别在机器人沿反方向行驶时,图像回归方法几乎失效,而 ROMAN 依然可以依靠对象结构实现全局闭环。

图4|对比实验结果

2)用于多机器人 SLAM 的闭环效果

随后作者还将 ROMAN 集成到一个大规模多机器人 SLAM 系统中,用作闭环检测模块,并与采用视觉特征闭环的传统方法进行了对比。

● 在多个真实部署的多机器人任务中,ROMAN 帮助系统将轨迹估计误差平均降低了 35%。

● 显示出该对象图优化方法在长期运行、多路段重复访问下,比单纯依赖图像特征的方案更具鲁棒性。

图5|多机器人SLAM闭环检测实验结果(上图展示的是定量的结果,下图展示的是轨迹上的可视化)

3)消融实验

为进一步验证设计的有效性,作者开展了多项消融实验:

● 去掉重力方向对齐:配准误差显著增大,表明重力方向在减少滚转、俯仰角不一致带来的匹配误差上起到了关键作用。

● 只用形状或只用语义:都比形状+语义联合要差,说明两者互补对于开放集匹配至关重要。

● 不同对象数量与稀疏度下的效果:ROMAN 在场景对象较稀疏时仍能保持稳定性能,而基于分段的方法容易退化。

图6|消融实验结果

本文提出了 ROMAN(Robust Object Map Alignment Anywhere),这是一种新颖的全局定位框架,能够在具有挑战性的室内、城市以及非结构化自然场景中,通过配准开放集的对象地图来实现稳健定位。ROMAN 将对象地图之间的配准问题形式化为一个基于图论的全局数据关联任务,并巧妙结合了对象形状、语义以及重力方向信息,从而有效提高了对大范围场景以及视角大幅变化的适应能力。

通过在多种具有挑战性的环境中开展的实验,ROMAN 在全局定位精度上超越了现有的基于图像回归和分段几何配准的方法。此外,当将 ROMAN 用作多机器人 SLAM 系统的闭环检测模块时,能够显著减少轨迹估计误差,展示了其在长期、大规模自主导航任务中的实用潜力。

审编|阿蓝

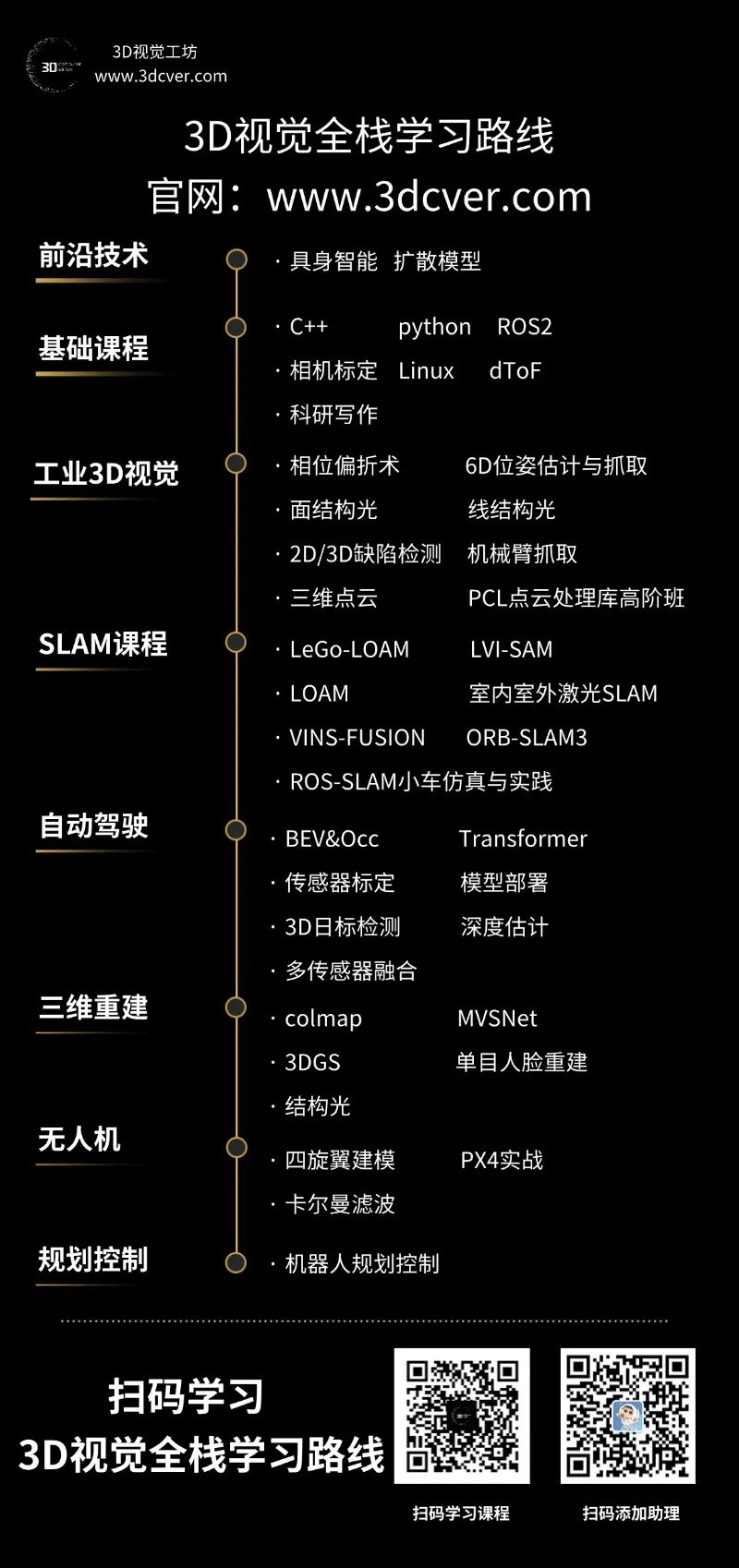

3D视觉硬件,官网:www.3dcver.com

3D视觉学习圈子

「3D视觉从入门到精通」知识星球(点开有惊喜) !星球内新增20多门3D视觉系统课程、入门环境配置教程、多场顶会直播、顶会论文最新解读、3D视觉算法源码、求职招聘等。想要入门3D视觉、做项目、搞科研,欢迎扫码加入!

3D视觉全栈学习课程:www.3dcver.com

3D视觉交流群成立啦,微信:cv3d001