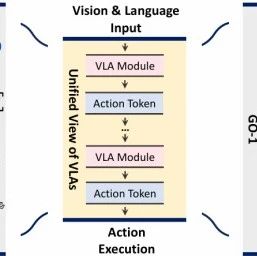

相比单纯的视觉或语言模型,VLA模型不仅能看、能理解,还能把指令落实到真实世界的操作中。

这类能力背后的关键环节,正是「动作token(Action Token)」。

什么是动作token?

简单来说,它是VLA模型把感知信息和语言指令转化为行动的“中间语言”,类似于大语言模型(LLM)中的“语言token”。有了动作token,VLA模型能逐步分解复杂任务,把“你说的话”变成“机器人能做的事”。可以说,动作token是VLA模型架构的核心,也是决定模型效果的关键。

这篇文章,我们来盘一盘VLA中最有代表性的 5 类动作token,总结各个token的优缺点,以及未来的发展方向,让大家读完本文后,能够对VLA中的代表性token有所了解!

▲图1|视觉语言动作模型都统称为“VLA”,但并不意味着它们都是接受相同的输入,产生同样的输出;不同模型往往根据其面向的任务场景,选择不同的action token©️【深蓝具身智能】编译

为什么有这么多token类型?

VLA模型的应用场景非常复杂:既要能理解「高层目标」如“整理房间”,也要能处理「低层动作」如“手臂向前伸5厘米”,中间还要知道环境中的交互点、目标物体位置等细节。

这就决定了:一种token很难搞定所有层次的信息。

“

我们可以简单的理解为:“动作token的设计几乎决定了VLA模型的方方面面,包括可解释性、数据需求、训练效率、跨任务能力等”。

这也是为什么当前研究会探索出多种token类型,来覆盖不同层次的问题。

VLA中4+1类最有代表性的token

动作token的类型其实很多,我们今天挑出最具代表性的4+1类来聊。它们从“高层规划”到“低层执行”形成一个完整链条,既能覆盖主流方法,又能看清趋势:

语言描述(Language Description):用自然语言描述任务或动作,擅长任务分解和高层规划。

可供性(Affordance):定位环境中的交互点或区域,让机器人知道“做什么、在哪做”。

轨迹 / 目标状态(Trajectory + Goal State):直接预测动作轨迹或未来目标状态,关注低层执行。

潜在表征(Latent Representation):用抽象隐变量来压缩信息,支持大规模泛化和端到端学习。

推理(Reasoning):作为“胶水”,贯穿所有token,用多模态链式推理提升整体决策质量。

接下来,我们就按照这个结构,逐一看看这几类token各自的特点、代表工作、优劣势和未来方向。

语言描述(Language Description)

语言描述是目前最直观、最容易理解的一类动作token。顾名思义,它用自然语言来表达任务和动作,让模型把要做的事情“说出来”。

高层级:叫做 Language Plan,比如“拿起茶杯”、“把茶杯放在桌子上”,更像是任务分解。

低层级:叫做 Language Motion,比如“手臂向前伸”、“抓取手柄”,更接近物理动作。

这类token可以直接利用大语言模型(LLM)和多模态大模型(VLM)的强大语言理解与推理能力。这意味着,模型可以像我们一样“边思考边分步骤”,把复杂任务拆解成多个小目标,再逐一完成。

代表性工作:

SayCan、PaLM-E、Hi Robot、π0.5、RT-H

▲图2|语言描述动作token示例©️【深蓝具身智能】编译

在优势方面,语言描述token最突出的特点是可解释性强。

人类用户和研究者可以直接通过生成的自然语言看到模型的计划,这让模型决策过程更透明。其次,它非常适合长时序、多步骤任务,因为自然语言本身天生具备分解任务、表达因果关系的能力。此外,语言数据极为丰富,VLA模型能够直接利用互联网级的大量开源数据完成预训练,这也是语言描述token的一大好处。

不过,语言描述token也存在挑战。

首先,它的表达精度有限,尤其是遇到复杂、细腻的操作时,自然语言的抽象描述可能过于模糊,容易带来执行歧义;其次,这类token的生成通常是逐步进行的,导致执行延迟较高,在需要实时响应的高频控制任务中显得不够高效。

未来的研究方向在于两方面:

一方面,语言描述token需要与视觉和环境状态更深融合,避免出现“说得出来却做不到”的情况;

从长远来看,语言描述token可能更偏向于承担高层决策和任务分解的角色,再与其他低层token(例如轨迹或潜在表征)形成分层体系,提升整体执行效率。

可供性(Affordance)

如果说语言描述token是“会思考”,那么可供性token就是“会看环境”。

它直接回答两个问题:做什么和在哪里做。换句话说,模型需要理解环境中有哪些物体可以交互、哪些部位适合操作,并把这些信息编码成token传递下去。

可供性token有几种典型表现形式:

关键点(Keypoint):比如茶杯的手柄,是交互的最佳位置;

目标框(Bounding Box):用方框锁定目标物体的大致区域;

分割Mask(Segmentation Mask):精确到像素级别,把物体或交互区域“抠”出来;

可供性图(Affordance Map):更密集地标注环境中每个区域可以做什么动作。

代表性工作

VoxPoser、DexGraspVLA、ROCKET-1、ManiFoundation、CoPa

▲图3|Affordance动作token示例©️【深蓝具身智能】编译

这类token的最大优势是和环境状态绑定紧密,位置感知能力很强。机器人不仅知道自己和目标物体的位置关系,还能直接利用可供性信息指导交互操作。

但是,可供性token也面临一些挑战。

首先,它对感知质量高度依赖,容易受到视觉噪声、遮挡或光照变化的影响而出错。其次,动态场景处理困难,如何实时更新可供性信息仍是难点。第三,大部分方法停留在2D图像层面,对真实3D空间结构的理解不够深入,这会限制机器人在复杂环境中的操作能力。

未来的改进方向主要有三点:

一是提升3D建模能力,让机器人对环境有更真实的空间理解;

二是融合时序信息,预测环境中未来可能的交互机会,而不仅仅是静态判断当前状态;

三是与其他token深度联动,例如先通过语言描述确定目标,再用可供性token选择最优交互点,最后生成轨迹完成动作,这样能提升整个体系的稳定性和泛化能力。

轨迹 / 目标状态(Trajectory + Goal State)

轨迹(Trajectory)和目标状态(Goal State)这两类token紧密相关,都与“未来预测”有关。它们代表了机器人如何在低层执行动作的不同思路:「轨迹」是直接预测动作路径,而「目标状态」是预测未来应该到达的状态。

从定义上看,轨迹token就是一串按时间排序的空间状态,描述机器人或物体的运动路径;目标状态token则是预测未来的目标图像、点云或视频帧,作为中间目标引导规划器执行。

这两类token都有一个共同特点:可执行性强。

代表性工作

RT-Trajectory、FLIP、HAMSTER、3D-VLA、CoT-VLA

▲图4|Trajectory与Goal动作token示例©️【深蓝具身智能】编译

轨迹和目标状态token的优势主要体现在以下几个方面:

首先,它们和控制器对接天然契合,预测结果可以直接转化为低层动作指令,这让机器人在执行任务时更加高效;

其次,这类token有助于长时序动作规划,尤其是在需要跨越多个状态才能达成目标的任务中,轨迹或目标状态提供了清晰的参考路径。

然而,这类token也有明显的挑战。

轨迹token语义信息较弱,通常只是物理路径,并不能表达为什么要这么走,容易在遇到未知场景时“迷路”。目标状态token虽然引入了视觉语义,但生成高质量、连续性强的目标状态本身非常困难,尤其是在长时序和开放环境下,预测误差会不断累积,导致机器人执行失败。

未来的发展方向包括两方面:

一是与世界模型(World Models)深度结合。通过学习对环境动态的预测,模型能够更准确地生成轨迹和目标状态,减少误差累积;

二是强化多模态语义约束,让轨迹和目标状态不仅仅是几何上的合理,还要符合任务语义。例如结合语言描述token确定任务目标,再用可供性信息选择合理交互点,最后用轨迹或目标状态引导执行。

可以预见,轨迹和目标状态token未来仍会是低层执行环节的主力,尤其是在需要真实机器人控制的应用中。

潜在表征(Latent Representation)

潜在表征(Latent Representation)是动作token中抽象程度最高的一类。

它试图用一组高维的隐变量把感知、语言和动作信息压缩在一起。这类token通常通过专门的预训练方法获得,能够在不同任务和场景中泛化使用。

代表性工作

GO-1、UniVLA、GROOT-2、QueST

▲图5|Latent Representation动作token示例©️【深蓝具身智能】编译

潜在表征token的优势非常突出:

首先,它具备极强的数据利用能力。由于训练时可以直接用大量“无动作标签”的人类视频或跨任务数据,数据成本远低于标注轨迹或语言计划;

其次,它的表示能力很强,可以同时融合感知和动作信息,支持跨任务、跨机器人形态的迁移,这对开放世界任务尤其有价值。

不过,潜在表征token最大的短板是可解释性差。

这些隐变量是经过神经网络学习的抽象表示,人类很难理解它们具体含义,因此当模型出错时,几乎无法定位问题。此外,目前的潜在空间粒度和任务对齐性不足,容易出现信息过于稀疏或与任务目标脱节的情况。

未来的研究方向主要集中在三个方面:

一是提升潜在空间的粒度和任务对齐性,让隐变量更细致、更符合任务逻辑;

二是加强多模态融合,潜在表征不只是“视觉+动作”,还要能够融合语言、触觉甚至音频信息,从而提升泛化性;

三是探索潜在表征和其他token的联动,用它来作为“核心信息中枢”,再结合语言描述、高层规划或轨迹token来构建分层的VLA架构。

潜在表征token的方向与大模型的发展趋势高度契合,它像是VLA领域的“端到端黑箱”。虽然挑战仍多,但一旦潜在空间设计得当,模型将拥有极强的泛化能力和训练扩展性,这也是为什么很多前沿工作正在加大这方面投入。

推理(Reasoning)

在前面几类token中,我们介绍了语言描述、可供性、轨迹/目标状态和潜在表征,它们各自承担着任务分解、环境理解、动作执行和信息抽象等不同角色。但实际上还有一类更“隐形”的token贯穿其中,它就是推理(Reasoning)。

推理token并不直接输出动作,而是通过类似“思考链条”的方式,帮助模型生成更合理的决策。它可以用自然语言、逻辑步骤,甚至是多模态信息的组合来表达模型的思考过程,目的就是让决策过程更稳健、更具适应性。

代表工作:

ECoT、DriveVLM、RAD、Inner Monologue

▲图6|Reasoning动作token示例©️【深蓝具身智能】编译

推理token的价值可以体现在三个方面:

提升高层规划质量:通过多步推理,模型能够更准确地理解任务目标并制定计划,避免“一步到位”的草率决策;

增强低层执行的鲁棒性:推理token能动态结合环境反馈调整决策,让轨迹或目标状态预测更符合实际;

提供自我修正机制:在执行过程中,推理token可以充当“检查员”,帮助模型发现并修正偏差,这在动态或不确定环境中尤其关键。

同样的,推理token也面临诸多挑战:

首先是计算延迟,链式推理往往意味着更多步骤和计算量,这对于实时任务来说是个不小的负担。其次,如何设计一种既灵活又高效的推理机制仍是研究难点,尤其是要能自适应地决定何时深入推理、何时直接执行。

未来的发展方向包含三个方向:

推理token将从单一语言推理扩展到多模态推理,结合视觉、语言、动作等信息形成更完整的决策链条;

模型会更多引入Test-time Adaptation(测试时自适应),即根据环境反馈动态调整推理深度和内容,以在保持效率的同时提升鲁棒性;

更重要的是,推理token不再是孤立存在,而会成为连接高层规划和低层执行的“胶水”,让不同类型token更好地协同工作。

可以说,Reasoning是帮助VLA模型“更像人类思考”的关键。它本身不是单独的输出形式,而是贯穿在任务分解、环境理解、动作生成的各个阶段,使整个VLA体系更加可靠和智能。

总结

通过对语言描述、可供性、轨迹/目标状态、潜在表征四大类token,以及贯穿全局的推理(Reasoning)token的分析,可以发现:

不同token类型并不是彼此割裂的,而是互为补充,共同构成了VLA模型的“感知—规划—执行”闭环。

语言描述token擅长高层语义规划;

可供性token强于环境交互定位;

轨迹和目标状态token直接驱动低层执行;

潜在表征token则以抽象的隐空间整合多模态信息;

而Reasoning token就像“胶水”,贯穿各个环节,让模型在执行任务时具备多步思考与自我修正的能力。

未来,VLA模型的发展方向将更加多元化和融合化:

多种token深度融合:高层用语言描述或代码进行任务分解,中间层结合可供性、目标状态增强对环境的理解,底层用轨迹或潜在表征直接驱动执行。这样的多层级token架构能提升整体鲁棒性和泛化能力。

从模型走向智能体(Agent):VLA模型不再只是被动接收指令,而会逐渐具备主动探索、记忆、规划和反思能力,形成完整的认知闭环。这意味着未来的VLA系统将更像“智能体”,能够长期自主运行、持续适应新环境。

与世界模型和强化学习结合:未来的VLA需要更好地预测环境动态,并通过自我探索不断提升性能。世界模型将提供长期预测能力,而高效的强化学习算法能帮助模型从真实环境中习得更多行为策略。

模型、数据和硬件协同进化:现实世界极为复杂,仅靠模型突破是不够的。大规模高质量的具身数据和更灵活的机器人硬件是推动VLA落地的必要条件,三者需要同步发展。

安全与人类价值对齐:随着VLA模型能力提升,其决策过程和执行行为必须更透明、可控,未来研究应更多考虑安全性与对齐问题。

可以预见,VLA模型正在从“单一任务解决方案”演变为“通用智能体”,它们将在开放世界中学习、探索并自主完成复杂任务。而动作token作为贯穿感知、语言、决策和执行的核心机制,将继续是未来VLA研究和应用的焦点。

编辑|阿豹

审编|具身君

参考文献:

A Survey on Vision-Language-Action Models: An Action Tokenization Perspective

【深蓝具身智能读者群】-参观机器人:

【深蓝具身智能读者群】-参观机器人:

我们开设此账号,想要向各位对【具身智能】感兴趣的人传递最前沿最权威的知识讯息外,也想和大家一起见证它到底是泡沫还是又一场热浪?

欢迎关注【深蓝具身智能】👇

点击❤收藏并推荐本文