点击下方卡片,关注“具身智能之心”公众号

作者丨Yongjie Bai等

编辑丨具身智能之心

本文只做学术分享,如有侵权,联系删文

更多干货,欢迎加入国内首个具身智能全栈学习社区:具身智能之心知识星球(戳我),这里包含所有你想要的。

研究背景与动机

现有视觉-语言-动作(VLA)模型在多任务机器人操作中,常依赖固定视角和共享视觉编码器,这会限制3D感知能力并引发任务干扰,影响鲁棒性和泛化性。

固定视角在复杂场景中问题突出:在杂乱或动态环境中,固定相机易导致目标物体或末端执行器被遮挡,使场景理解不完整,进而导致动作预测不准确。例如“把糖放进橱柜”的任务中,固定摄像头的前视图可能只拍到橱柜,左右肩视图只拍到被夹持的糖,无法同时覆盖关键信息,可能导致操作失败。

共享编码器的局限同样明显:即使是语言条件的 Transformer 方法(如 RVT、RVT-2),其共享编码器在处理视觉和语义差异大的任务(如“摘苹果”与“开抽屉”)时,会因任务干扰限制模型在多任务中的泛化性和扩展性。

核心方法:TAVP 框架

为解决上述问题,我们提出任务感知视图规划(TAVP)框架,整合主动视图规划与任务特定表征学习,核心包括 TaskMoE 模块和 MVEP 策略,整体流程见 Figure 2。

TaskMoE:任务感知混合专家模块

针对多任务学习中复杂操作任务的异质性,设计 TaskMoE 模块,通过两个关键创新提升多任务准确性和泛化性(Figure 3):

动态专家路由机制:不依赖单一任务标识符,而是融合指令和场景线索引导专家选择。通过跨模态模块的交叉注意力机制建模指令与视觉信息的交互,再经 Feature-wise Linear Modulation(FiLM)层与任务标识符融合,实现更自适应的任务敏感专家选择。

解耦门控策略:将路由门数量()与任务总数()解耦(),促进语义相似任务的参数共享,同时隔离语义差异大的任务路由。例如“打开抽屉”类任务可共享同一门控,而与“转动水龙头”等差异大的任务使用不同门控,增强对未见任务的泛化性。

MVEP:多视角探索策略

旨在选择能最大化捕获操作目标相关信息区域的 K 个视角,提升机器人动作预测准确性:

输入与表征:以重建的点云和 RGB 特征为输入,拼接为,经多层感知器(MLP)预测 K 个相机姿态参数。

相机姿态参数化:采用“look-at”模型,通过球坐标解耦相机位置和方向,每个相机姿态用 5 维向量表示,其中定义相机中心相对原点的球坐标,定义上向量方向。

可微分采样:将相机姿态参数建模为高斯分布样本,网络输出均值和对数标准差,通过重参数化技巧采样:

再用 sigmoid 函数将采样姿态约束在球坐标的有效范围内。

训练策略

训练过程分三阶段:

阶段1:训练 TAVP 的固定视角变体,使用前、左、顶三个默认视角。损失函数包括:

其中、分别为粗/细接地模块热图的交叉熵损失,为末端执行器旋转损失,和分别为 gripper 状态和碰撞指示的二分类损失。

阶段2:优化 MVEP,以阶段1训练的固定视角模型为基准,采用 PPO 算法。引入伪环境交互机制减少物理环境交互成本,定义三个奖励项:

任务损失奖励:,其中为基准模型损失,为动态视角下的损失 置信度奖励:,基于细接地模块热图的负平均熵 多样性奖励:,基于相机位置的平均 pairwise 余弦距离 总奖励为各归一化项的加权和:。

阶段3:微调除 MVEP 外的整个 TAVP 模型,使用与阶段1相同的损失函数。

实验结果

在 RLBench 的 18 个任务上进行实验,验证 TAVP 的有效性。

主要结果

与采用固定视角的密集模型(RVT2、ARP、ARP+)相比,TAVP 在所有任务中成功率更高。在易受遮挡或需细粒度感知的任务(如“放进橱柜”“插入钉子”)中,成功率提升达 56%;即使在较简单任务(如“关罐子”“滑动方块”)中,也有 4% 的提升。平均成功率从 ARP+ 的 84.9% 提升至 86.7%,证明主动视图规划与任务感知特征路由的协同作用(Table 1)。

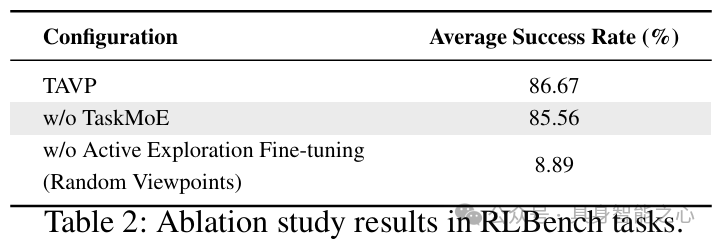

消融实验

Table 2 显示:

移除 TaskMoE 后,平均成功率从 86.67% 降至 85.56%,说明其在多任务表征学习中的重要性 用随机视角替代主动探索视角后,成功率仅 8.89%,证明任务感知视图规划是性能提升的主要因素。

敏感性分析

视角数量(K):在径向约束(0.75∼1.3m)下,K 从 2 增至 4 时,平均成功率从 27.2% 提升至 55.2%,尤其在“把钱放进保险箱”等易遮挡任务中提升显著(Table 3)。

径向约束(r):相比基准范围(0.75∼1.3m),更紧凑的约束(0.90∼1.04m)使平均成功率从 49.6% 提升至 56.0%,而更宽松的约束(0.60∼1.56m)导致性能轻微下降(Table 3)。

效率与泛化分析

性能-效率权衡:TAVP 平均成功率(86.67%)高于 ARP+(84.90%),推理延迟增加约 10.7%(0.436s vs 0.394s),平衡了性能与效率(Table 4)。

零样本泛化:TaskMoE 显著提升对未见任务的泛化性。在“打开抽屉”任务中,带 TaskMoE 时成功率 12.0%,无 TaskMoE 时为 0;在已见任务中,带 TaskMoE 平均成功率(49.6%)是无 TaskMoE(24.0%)的两倍多(Table 5)。

参考

[1]Learning to See and Act: Task-Aware View Planning for Robotic Manipulation