相较于更早年工业自动化时代的机器人,现在很流行的“具身智能”与之较大差别就在于开始全面应用AI技术:尤其是LLM大语言模型、VLM视觉大模型,乃至VLAM视觉语言动作模型。相较于以往从感知到驱动,对每个问题做建模、并寻求数学求解方法,“具身智能”达成了更高的智能程度。

前不久的SIGGRAPH顶会上,NVIDIA也提到对AI机器人而言,至少有两个模型非常重要:“VLM能够理解指令、规划行动,而VLAM让机器人实现了快速的‘条件反射’和‘肌肉记忆’”。

但关键问题在于:没有那么多高质量的数据用于模型训练,以及即便有了模型,其面对未知场景(尤其一些长尾场景)解决问题的能力仍然很差。去年的ROSCon之上,我们和现场的NVIDIA工程师聊了聊,对方告诉我们NVIDIA所倡导的“三台计算机”生态的其中第二台计算机能就此问题,有效降低机器人的开发成本。

我们当时对于这个说法的理解是:对机器人这种高成本、操作失误就可能具备危险性的设备而言,如果是在现实中直接训练、试错,则成本会变得不可控;转而借助Omniverse这样的虚拟世界去做模拟仿真,对AI模型做反馈和强化训练,显然更为高效和低成本。

但在今年看完GTC、SIGGRAPH相关发布之后,我们发现可能这“第二台计算机”的价值也不单是这么简单;顺道更多机器人开发工具的涌现,也让我们有机会进一步窥探机器人“学文化”所在的这个虚拟世界究竟长什么样……

再看“第二台计算机”对机器人的价值

关注NVIDIA在机器人领域相关动作的读者应该知道,NVIDIA这两年一直在Physical AI领域推“三台计算机”的概念——机器人也属于Physical AI的一大类:

(1)第一台计算机用于训练Physical AI模型——比如NVIDIA的DGX, HGX系统;

(2)第二台计算机作为模拟引擎存在——Physical AI在虚拟环境中学习,或者更具体地说它能模拟仿真、测试Physical AI模型,也负责合成数据生成——比如众所周知的Omniverse就提供这样的虚拟环境;

(3)第三台计算机部署到机器人本体、作为机器人大脑存在——Jetson产品线就用在这个方向。

和其他垂直领域的策略相似,NVIDIA除了提供这三台计算机的硬件——包括芯片、系统,也提供软件和整个平台,如开放的AI模型、开源模拟框架、公开的数据集、开发可参考的工作流等。

当然第一、第三台计算机也很重要,毕竟它们是产生以及部署Physical AI模型所必需的。但为什么现在很多人把注意力放在了第二台计算机?用NVIDIA在SIGGRAPH媒体会上的话来说,归根到底,在于目前机器人领域面临最大的问题可能就是数据的挑战。

相对于LLM大语言模型开发者有整个互联网的数据可用于训练,Physical AI作为更垂直的AI应用本身就面临缺数据的问题。因为真实世界数据的获取成本高昂;而且Physical AI应用的容错率很低,毕竟很多场景涉及到生产力甚至人身安全,所以还需要大量长尾场景的数据。这也是模拟仿真对机器人如此重要的根本原因:其基本理念是,让机器人在虚拟世界训练和学习技能。

与此同时,今年GTC期间NVIDIA Omniverse与模拟技术副总裁Rev Lebaredian说了这样一番话:很多短视频里头的机器人那么厉害,但在实际应用于生产时,真正的问题往往在于能力的“泛化(或通用化,generalizing)”,即从原本机器人只能以某种设定做某个特定工作,走向它也能够在不同环境下、做其他相似的工作负载。

“其中缺失的一块拼图,就是能够给予机器人通用智能的技术。它们能够在不同的情况下实现通用化。这原本就是Transformer、LLM(大语言模型)所能达成的。”生成式AI、Agentic AI是实现机器人智能泛化、通用智能的基础技术,“现在最大的挑战也就变成了,这样的技术需要海量的数据示例”。“我们认为唯一的解决方案就是模拟出足够准确的现实世界,也就有了无穷的数据源,用以构建机器人大脑。”

这就是第二台计算机正在尝试解决的问题。

虚拟世界的重构

NVIDIA Omniverse作为一个遵循诸多物理定律的虚拟世界,且还发展了好些年,也就成为机器人训练的理想场所——黄仁勋在近两年的多次主题演讲中将Omniverse称作Physical AI的操作系统。但Omniverse不是第二台计算机的全部,对开发者而言,这其中似乎还有不少问题没有解决。更进一步探究虚拟世界,也有助于我们理解机器人开发生态现在的发展阶段。

从算力基础的角度来看,今年SIGGRAPH上NVIDIA发布了最新Blackwell版的RTX PRO服务器——单系统内可扩展8个RTX PRO 6000服务器版GPU,面向企业用户也新增了紧凑版2U服务器方案。媒体会上NVIDIA基本确认了RTX PRO服务器接替此前的OVX系统。当然在NVIDIA基础设施家族产品中,RTX PRO并非唯一承载Omniverse的硬件平台,比如现在也有能跑Omniverse的DGX云,它们都可以视作“第二台计算机”的具象形态。

但这不是本文要谈的重点,有了设备作为硬件基础,有了Omniverse这一“操作系统”,实际上NVIDIA还提供一系列开放的库、框架、模型,可融入到开发者的工具和工作流之中。这些也成为机器人在虚拟世界学习技能的基础要素。NVIDIA表示,机器人要在虚拟世界学习技能至少需要3个步骤:世界重构(world reconstruction)、世界生成(world generation)、世界理解(world understanding)。

所谓的世界重构,也就是基于现实世界,去捕捉、组建和重构一个虚拟世界,提供具备模拟仿真现实世界能力的环境;而世界生成,则是指去对世界做加强和随机,生成各种不同版本、不同状况的场景;世界理解,即为Physical AI提供先验知识、常识和逻辑推理基础。

针对这三个不同的环节,NVIDIA也在不断做内容和工具填充。在世界重构这一步上,常规方案应该是由3D艺术家来手动打造模型资产,应用各种材料、物理特性。而且“在诸如CARLA或Isaac Sim这样的模拟器中组建虚拟训练场,需要面对不同类型的数据——从现实世界抓取到的,还有来自不同CAD工具,以及MuJoCo、Gazebo等机器人模拟框架的”。

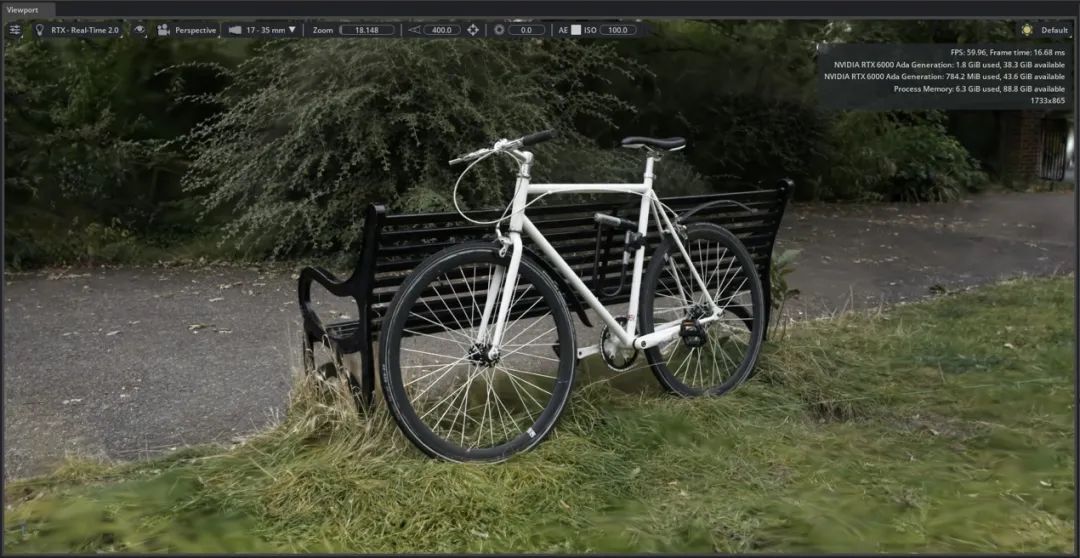

所以NVIDIA这次在SIGGRAPH上着重谈到了Omniverse NuRec——全拼是Neural Reconstruction(神经重构)。Omniverse NuRec之中包含了用于重构渲染和加强的库与AI模型。开发者借助这款工具,可以把现实世界的传感器数据(包括图像、视频、LiDAR等),通过3D Gaussian Splattering(3DGS,3D高斯点染)转为可交互的模拟仿真。这里的3DGS是一种将场景重构为大量可移动、操控粒子的技术。

随后,“我们针对真实光照和传感器行为,用Omniverse RTX渲染来增加光线追踪,这对机器人感知很重要。”

与此同时,NVIDIA这次还推出了新的OpenUSD库,可实现MuJoCo和其他USD应用的数据互操作性。MuJoCo是来自Google Deepmind的机器人学习框架——在行业内相当流行;USD(Universal Scene Description)在我们此前介绍Omniverse的文章里详细谈过,是3D数据表达的某种标准,也是NVIDIA构建虚拟世界的数据格式,或者说在本文探讨的场景中是机器人在虚拟世界中学习的标准数据格式。

NVIDIA过去这两年一直在积极组建OpenUSD生态。这里提到的支持USD的应用也不单是NVIDIA自己的,还包括诸如Intrinsic、Visual Components这类合作伙伴的应用。NVIDIA期望更多工具接入到USD生态内;接通不同的生态,也让真实世界的数字孪生构建更容易,也就能更好地够满足机器人开发的世界重构要求。

“我们在开源机器人模拟仿真框架Isaac Sim和Isaac Lab中,都启用了NuRec和新的USD库,现在也已经在Github上公开了。”这些是NVIDIA这次针对“世界重构”部分的主要技术发布。

世界的生成与理解

世界重构一次是不够的,因为Physical AI要学习的场景、环境远不止一种。为了实现机器人技能的泛化和通用,还需要多种多样的场景与数据,也就涉及到世界生成了——这一步也是产生海量合成数据的关键。前不久电子工程专辑撰文谈到了Omniverse与Cosmos的互补,Cosmos即为这一环节中理解物理世界的生成式AI模型。

今年GTC主题演讲中,黄仁勋就提到了“用Omniverse来训练(condition)Cosmos,用Cosmos生成不计其数的(虚拟)环境,构建的数据是基于现实、受控的(grounded)”。NVIDIA此前宣传说Cosmos是全球首个“世界基础模型(world foundation model)”或者世界基础模型开发平台。

今年NVIDIA在推的Cosmos新模型包括Cosmos Predict, Cosmos Transfer, Cosmos Reason。今年SIGGRAPH之上,基于前述三个步骤,NVIDIA将Cosmos Transfer和Cosmos Predict放在了“世界生成”步骤之中。

Cosmos Transfer是典型的,给开发者做数据加强的模型——它能基于视频和文字输入,来生成海量随机场景——Omniverse作为基础,基于经典模拟仿真算法为Cosmos Transfer提供生成真实环境的支持。Rev说Cosmos Transfer以低成本的方式,基于用户输入来生成多样化的合成数据。

而对于Cosmos Predict模型,更早的时候NVIDIA提到给它输入起始帧和结束帧,它就能生成中间视频序列的所有帧;现在输入的条件要求应该是更简单了:仅需起始图像或视频片段,配上文字引导,就能生成后续的视频内容——名副其实的未来“Predict”,也是合成数据生成的典型工具。

NVIDIA表示,今年1月份这两款模型发布至今,下载次数已经超过了200万次;目前则还在和合作伙伴一起,基于不同需求来进一步提升模型的能力。

OpenAI四年前发布了名为CLIP的VLM模型;随后VLM视觉语言模型在CV计算机视觉领域变得越来越流行。只不过早期的这些模型仍然无法对一些未见过的、多样的长尾场景做理解和处理。所以对于“三个步骤”的最后一步“世界理解”,Cosmos Reason模型就尝试弥补传统非逻辑推理型VLM的不足:“像人类一样,基于先验知识,包括对物理学、物理交互的理解,及各种不同的常识”做推理,成为“开放的商业级逻辑推理(reasoning)VLM”。

从“Cosmos Reason”的名字来看,“reason”一词点明了它具备现在不少Agentic AI的“深度思考”、分步骤解决问题的能力。Rev说Cosmos Reason借助逻辑推理,就能在复杂动态环境下处理各种模糊问题,以及未曾见过的场景、未曾有过的经验,这是传统VLM模型所不具备的。开发者可对该模型做后训练和定制;而7B参数量,也决定了它很适合用于Physical AI边缘或者该场景下的机器人部署。

比如说下达指令让机器人“做几片烤面包片”:基于逻辑推理的VLM,看到烤面包机、面包以后,有能力将模糊指令转为符合常识的具体理解和行为,包括“几片”可以是切两片,以及一般情况下设置烤面包炉在中档火力,并且理解下达指令的人可能想要吃个简餐,所以要准备好盘子并呈到他面前。简而言之,Cosmos Reason让机器人具备复杂问题的决策能力。

与此同时NVIDIA认为,Cosmos Reason对于解决Physical AI面临的数据挑战问题,是真正的规则改变者(game changer),尤其在数据策管(data curation)和标注(annotation)的问题上——这部分工作原本是由人工和非逻辑推理型VLM配合完成的——耗费时间、质量还低。所以Cosmos Reason着眼于进行规模化、高质量的多样化训练数据集的curation和annotation。

另外,Cosmos Reason也是视频分析AI agent。这款模型现在在NVIDIA的视频搜索、总结型Blueprint(参考工作流)之中很流行,开发者能用它来打造视觉AI agent,从大量视频数据、直播内容中提取关键信息,乃至执行根因分析。所以Cosmos Reason本身对于很多行业应用,如智慧交通、智能制造也都很有价值。

模拟仿真的最后一公里

总的来说,Cosmos Reason要做到的是让机器人足够智能、对世界有更强的理解能力,并泛化这种智能,“就像在科幻电影里看到的那样”。于是,在Omniverse中重构世界,在Cosmos中生成多样化的世界和场景,并让机器人更智能地去理解世界,也就形成了NVIDIA在SIGGRAPH上所说的机器人在虚拟世界学习技能的3个步骤。

当然这些并非NVIDIA开发工具的全部,毕竟涉及解决Physical AI的三台计算生态时,全栈生态的搭建本来就不是件易:比如说作为开发者模拟仿真平台的Isaac Sim、机器人学习框架Isaac Lab;比如说建基于其上的Isaac GR00T人形机器人开发平台,及对应的基础模型;比如说几个月前上NVIDIA发布的Isaac GR00T-Dreams,这是个基于Cosmos的Blueprint,用于大规模合成轨迹数据生成;再比如说年初开源的Physical AI数据集,其中就有不少人形机器人和机械臂动作轨迹数据......

而Omniverse和Cosmos皆为其中的关键与基础组成部分,尤其体现在“第二台计算机”的生态下。2021年电子工程专辑着重介绍Omniverse之时,将其称作元宇宙的一种呈现方式——当时大概很少有人会想到,它能成为机器人“学文化”的虚拟世界基础;不知道老黄着眼布局Omniverse之初,是否就已经预想到了2025年机器人与具身智能的现在。

“Omniverse里面做了不少基础级别的模拟。”Rev在媒体会上说,“(AI技术)发展到一定阶段,我们会得到强大的世界基础模型——从不同角度,去完整地理解物理定律,包括牛顿力学、流体力学、电磁学等各种模态,最终合为一个大模型。” “只不过我们还没有发展到那个程度,做不到一个模型就理解这一切。”

所以“将其注入到Cosmos,做最后一公里的模拟仿真工作(last mile of simulation),令其做到photoreal,看起来更加的物理级精准。”“用Cosmos接过基础级别的模拟。而且还能通过快速更改提示词,将一种模拟转为不同的变体(variation),转为上万、百万量级的数据。”“而不需要在传统模拟器里头做大量工作。”

“将Omniverse和Cosmos做了结合,利用Cosmos的能力,借助世界基础模型,把它叠加在Omniverse已有的传统模拟仿真技术之上”。原本这“最后一公里的模拟仿真”成本高昂、难度巨大,Cosmos模型的产生正是期望解决这些问题。最终通过在虚拟世界里学习的方式,降低机器人的开发成本,也让机器人更加智能、更快落地。这正是“第二台计算机”价值的充分体现。

THE END

2025-08-24

2025-08-24

2025-08-23

2025-08-23

2025-08-22