机器人界的“爱马仕”——HERMES,从“灵巧手”到“全身协同”

如何实现机器人“移动中的灵巧操作”?这要求机器人不仅要有“巧手”完成精细动作,还要能随时进行自主导航与全身协调。

为此,清华大学TEALab最新工作,提出了HERMES框架:

把多种来源的人类动作数据(遥操作、动作捕捉、视频)转化为可执行的机器人策略;

通过深度图驱动的端到端sim2real迁移,让机器人学会在现实世界中稳定执行;

再结合导航基础模型+闭环定位,实现从“走到目标”到“完成操作”的一体化流程。

一次性解决数据之困、仿真gap、场景复杂,这三重挑战。

我们开设此账号,想要向各位对【具身智能】感兴趣的人传递最前沿最权威的知识讯息外,也想和大家一起见证它到底是泡沫还是又一场热浪?

具体方法与实现

HERMES 的方法部分完整覆盖了从硬件-仿真搭建,到人类动作转化+RL学习,再到 Sim2Real 策略迁移,最后到导航与操作闭环融合的全链条。

它的设计不仅减少了数据和人工成本,还保证了策略在现实世界中可用,为移动双手操作机器人提供了一条通用范式。

系统设计:从硬件到仿真

HERMES 的目标是让机器人能真正做到“移动 + 双手操作”。为此,作者在现实和仿真里搭建了一套统一的平台:

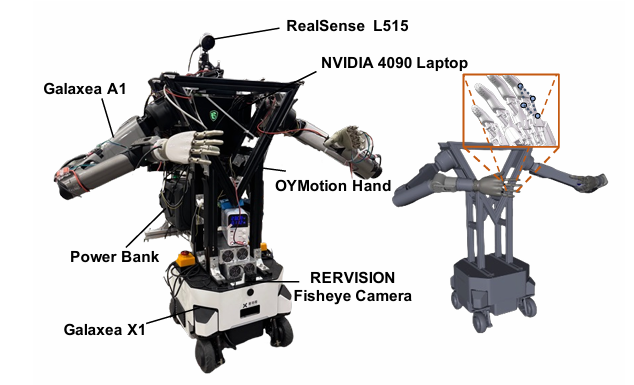

硬件部分:

一个 X1 移动底盘;

两个 6 自由度的机械臂(Galaxea A1);

两个 6 自由度的灵巧手(OYMotion);

搭配 RGB-D 相机(RealSense L515)和鱼眼相机做导航感知;

搭载 RTX 4090 笔记本进行推理和控制。

仿真部分:

使用 MuJoCo 与 MJX 平台,精确复现了机器人各个关节和手指的物理特性;

特别针对灵巧手的被动关节,采用高保真建模,保证仿真和现实的动作一致性;

碰撞检测采用几何体近似,提高稳定性。

这样一来,仿真和现实之间建立了高度一致的“数字孪生”,为后续的 sim2real 迁移打下基础。

强化学习方法:把人类动作转化为机器人策略

HERMES 的核心是用强化学习把人类动作变成机器人能执行的行为。

(1) 任务建模

每个任务都建模为一个带有参考轨迹的 MDP(马尔可夫决策过程)。

输入包含两部分:机器人本体状态(proprioception)和人类动作轨迹。

奖励函数统一设计,不需要为每个任务单独写。

(2) 人类动作的三种来源

遥操作:直接在仿真中操控机器人,采集手臂和手部数据。

动作捕捉 (mocap):利用 OakInk2 数据集,采集到的动作需要先做 retargeting,再通过 RL 学习精细化。

视频提取:用 WiLoR 提取手部关键点,FoundationPose 提取物体轨迹,通过 PnP 算法对齐到机器人坐标系。

HERMES 的一个亮点是:只需要一条人类演示轨迹,就能通过轨迹增强(随机平移、旋转物体位置)生成更多数据,从而大幅降低数据采集成本。

(3) 通用奖励设计

论文提出了三个关键的奖励:

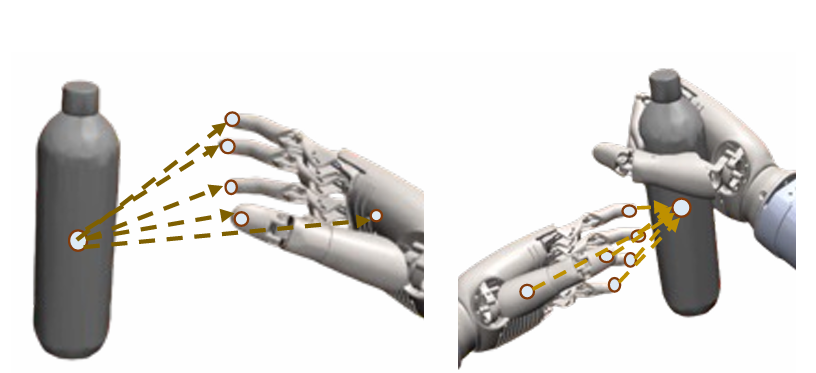

① 手-物体距离链 (object-centric distance chain):鼓励手指和物体保持合理接触,只有在检测到物理接触时才激活;

② 物体轨迹跟踪:确保机器人能跟随目标物体的参考位置和姿态;

③ 能量惩罚:抑制手部动作抖动,让动作更平滑。

(4) 残差动作学习

对手臂:先用人类动作提供一个粗糙的引导,再用网络输出的 residual 微调动作;

对手部:由于映射误差大,完全交给网络来输出。

这种 coarse-to-fine 的分工,让机器人既能继承人类演示的整体意图,又能学到操作中的细节。

(5) RL 算法

采用 DrM(off-policy,效率高)和 PPO(on-policy,配合 GPU 并行加速)。

在 MuJoCo 和 MJX 中同时跑,提高训练速度和泛化性。

Sim2Real 迁移:让仿真策略跑进现实

要让学到的策略能在现实执行,HERMES 提出了三大技巧:

(1) 深度图输入

用深度图代替 RGB,避免因纹理、光照差异导致的迁移失败。

在仿真中加入噪声、模糊、随机缺失像素,并和 NYU Depth 数据集的真实深度图混合(mixup),逼近现实分布。

(2) DAgger 蒸馏

教师:基于状态的 RL 策略(仿真里能拿到全部信息)。

学生:视觉策略,只用深度图输入。

蒸馏过程逐步减少对教师的依赖,让学生学会独立决策。

(3) 混合控制

现实执行时:用真实图像推理出动作 → 在仿真中算关节角度 → 再映射到真实机器人执行。

这样保证了仿真和现实的动力学一致,缩小 sim2real 差距。

导航方法:移动与操作的闭环结合

在真实世界,机器人不仅要“动手”,还要“动脚”。HERMES 把导航和操作结合在了一起。

(1) ViNT 导航模型

这是一个通用的图像目标导航模型,只需要 RGB 图像就能找到目标位置;

支持长距离、零样本导航,不需要额外微调。

(2) 闭环 PnP 精定位

问题:ViNT 导航到达目标后,往往还有几厘米甚至几度的偏差,而双手操作对精度要求极高。

解决:HERMES 用闭环 PnP 算法进行位置修正:

(1)先用 Efficient LoFTR 提取图像特征;

(2)通过 PnP 算法计算当前位姿与目标位姿的差异;

(3)再用 PID 控制器逐步调整位置,直到误差足够小。

这样一来,机器人能先“走到目标附近”,再“对齐到最佳位置”,为后续的操作做好准备。

实验

为了验证 HERMES 的有效性,作者在仿真和真实世界中做了一系列实验,主要围绕四个问题展开:

1. 能不能高效地把人类动作转成机器人行为?

2. 学到的策略是否比传统方法更强?

3. 在真实世界里能否稳定执行?

4. 移动和操作结合后效果如何?

下面逐个来看:

样本效率:一条演示也能学会

HERMES 只需要一条人类演示轨迹,通过轨迹增强和 RL 训练,就能学出泛化策略。

实验结果显示:无论是遥操作数据、mocap 数据还是视频提取的数据,HERMES 都能成功转化为机器人动作。

和现有的ObjDex方法对比,HERMES 在所有任务上都更快收敛,尤其是在涉及多物体交互的复杂任务中,ObjDex 完全失败,而 HERMES 依然学得很好。

对比实验:RL 是必不可少的,它让机器人不只是模仿动作,而是真正理解并适应任务

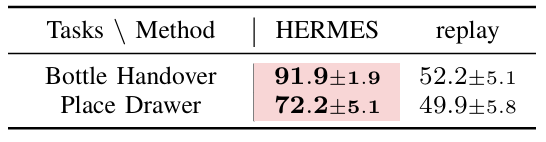

作者把 HERMES 和两种“非学习”方法做了对比:

运动学重定向:直接把人类动作映射到机器人手上。结果几乎全失败,因为没有考虑手与物体的接触信息。

直接回放轨迹:把采集到的动作轨迹稍微编辑后直接执行。结果在物体位置稍有变化时就会失败。

而 HERMES 的 RL 策略则能学习残差动作,在环境变化时灵活调整,成功率显著更高。

▲图12|HERMES 与重放编辑轨迹(Replay Edited Trajectories)的比较©️【深蓝具身智能】编译

▲图13|仿真训练可视化。借助单条参考轨迹结合通用奖励设计,HERMES 能够通过强化学习训练,将多样化的人类运动数据转化为机器人可执行的行为©️【深蓝具身智能】编译

Sim2Real:真正实现了零样本迁移 + 少量微调泛化

这是整篇论文的核心贡献之一。

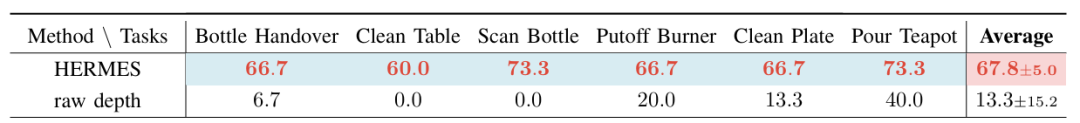

在 6 个真实任务上(如传递瓶子、擦盘子、倒茶),HERMES 的平均成功率达到67.8%,相比直接用 raw depth 输入的基线方法提升了+54.5%。

有些任务(如倒茶、熄灭酒精灯)因为物体透明或轨迹噪声大,需要少量额外的真实数据微调,但整体依然能保持高成功率。

导航与定位:闭环定位是移动操作的关键桥梁

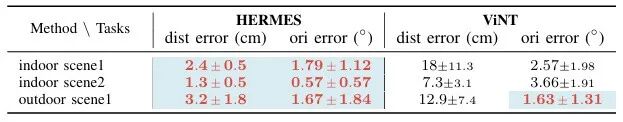

单独用 ViNT 导航,机器人能大致到达目标,但存在几厘米的位姿误差,对双手操作来说往往是致命的。

加入闭环 PnP 定位后,误差降到厘米级,保证了操作精度。

在无纹理的场景下,传统 SLAM (RTAB-Map) 完全失败,而 HERMES 的 PnP 依然能对齐位置。

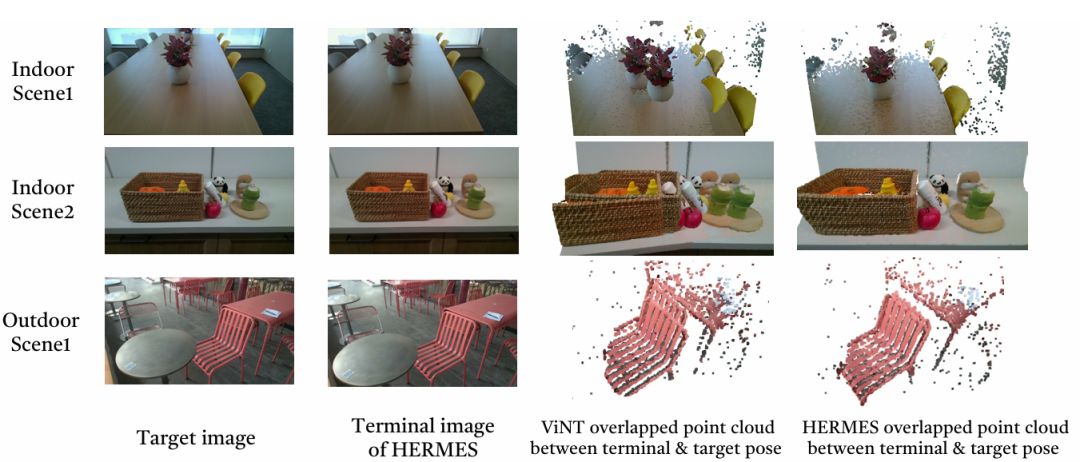

▲图15|导航结果可视化。左侧两列展示了目标图像与使用HERMES方法获得的最终图像的对比。右侧两列则呈现了导航结束时由 ViNT 和 HERMES 捕获的点云,并与目标位置的点云进行对比。©️【深蓝具身智能】编译

▲图16|导航定位误差实验结果©️【深蓝具身智能】编译

移动操作:证明了导航与操作的融合是真正可行的

最后,作者把所有模块整合起来,让机器人在真实场景完成“移动+操作”的完整任务:

任务包括:递瓶子、清理桌面、扫描瓶子、倒茶等。

结果显示:有了 PnP 定位加持的 HERMES,任务成功率比单纯依赖 ViNT 导航高出 +54%。

总结

HERMES 展示了一种“人机之间的信使”式框架:

从人类动作到机器人执行,从仿真学习到真实世界迁移,再到移动与双手操作的融合,形成了一条完整的技术链路。

它的价值在于:数据成本低、策略泛化强、任务执行稳定,让机器人终于能在真实场景中展现出接近人类的灵巧操作。

当然,如论文中提到的,目前的任务多为准静态,未来要走向更高动态、更复杂的操作,还需要在硬件和仿真精度上持续提升。

Ref:

论文题目:HERMES: Human-to-Robot Embodied Learning from Multi-SouRce Motion Data for MobilE DexterouS Manipulation

论文地址:https://arxiv.org/pdf/2508.20085

论文作者:Zhecheng Yuan, Tianming Wei, Langzhe Gu , Pu Hua, Tianhai Liang, Yuanpei Chen, Huazhe Xu

编辑|阿豹

审编|具身君

工作投稿|商务合作|转载

:SL13126828869(微信号)

>>>第三届自主机器人技术研讨会早鸟报名中<<<

ABOUT US|关于ARTS

为促进自主机器人领域一线青年学者和工程师的交流,推动学术界与企业界的深度交融与产学研合作,中国自动化学会主办了自主机器人技术研讨会(Autonomous Robotic Technology Seminar,简称ARTS)。

基于前两届大会的成功经验和广泛影响,第三届ARTS将继续深化技术交流与创新,定于2025年10月18日-19日在浙江大学(杭州)举办。我们诚挚邀请您参加,并欢迎您对大会组织提供宝贵意见和建议!

我们开设此账号,想要向各位对【具身智能】感兴趣的人传递最前沿最权威的知识讯息外,也想和大家一起见证它到底是泡沫还是又一场热浪?

欢迎关注【深蓝具身智能】👇

>>>现在成为星友,特享99元/年<<<

【深蓝具身智能】的内容均由作者团队倾注个人心血制作而成,希望各位遵守原创规则珍惜作者们的劳动成果。

投稿|商务合作|转载:SL13126828869(微信)

点击❤收藏并推荐本文