本文主要基于SemiAnalysis最新发布的《Co-Packaged Optics (CPO) Book – Scaling with Light for the Next Wave of Interconnect》研究报告,其中深入探讨了该技术的核心优势、市场机遇、技术挑战以及供应链格局。

1. 什么是 CPO,为什么大家如此兴奋?

CPO integrates optical engines directly within the same package or module as high-performance computing or networking ASICs. CPO(共封装光学,Co-Packaged Optics)将光学引擎直接集成在与高性能计算或网络 ASIC 相同的封装或模块中。光学引擎可以将电信号转换为光信号,从而通过光链路实现高速数据传输。

目前,大多数电到光的转换仍通过可插拔光模块(pluggable optical transceivers)完成。在这种情况下,电信号会从交换机或处理芯片经过几十厘米或更长的 PCB 路径,传输到机箱前板或后板的物理光模块插槽中。光模块接收电信号,并通过光学 DSP(Digital Signal Processor)芯片对信号进行调理,然后送入光学引擎组件,将电信号转换为光信号。光信号随后通过光纤传输到链路另一端,在那里另一个光模块执行逆过程,将光信号转换回电信号,最终送达目标硅片。

来源:SemiAnalysis

为什么会有CPO的需求?

在这个过程中,电信号在到达光链路之前,需要经过相对较长的铜线距离,并经过多个信号转换点。这会导致信号退化,同时需要大量功率和复杂电路(SerDes)来驱动和恢复信号。即对于超过几米的通信距离,必须使用光链路,因为铜线上的高速电信号无法传输超过几米。

为了解决这个问题,我们需要缩短电信号的传输距离。这就引出了“共封装光学(CPO)”的概念,将原本位于可插拔光模块中的光学引擎,与主芯片共同封装。这样,电信号传输长度从几十厘米缩短到几十毫米,因为光学引擎离 XPU 或交换 ASIC 更近。

这种做法显著降低了功耗,提高了带宽密度,并通过减少电互连距离和缓解信号完整性问题来降低延迟。

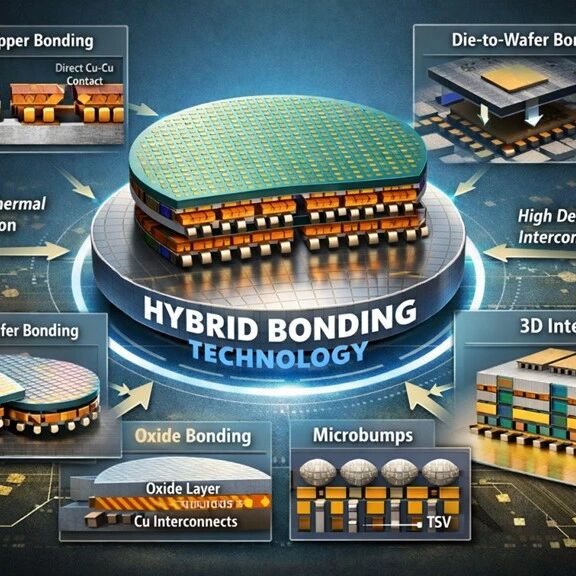

下图展示了 CPO 的实现示意图,其中光学引擎位于与计算芯片或交换芯片相同的封装上。前期(上图所示),光学引擎(Optical Engine)将放置在基板(Substrate)上,未来(下图所示)则会置于互连基片(interposer)上。

来源:SemiAnalysis

此外,还存在介于 CPO 与传统前插拔光学器件之间的中间实现方案,例如近封装光学(NPO)和板载光学(OBO)。

在 NPO 方案中,光引擎并非直接置于专用集成电路(ASIC)的基板上,而是与其他部件共封装至另一基板。光引擎仍采用可插拔设计,可从基板上拆卸。电信号仍需从 XPU 封装上的串行解串器(SerDes),通过铜质通道传输至光引擎。

来源:SemiAnalysis

板载光模块(OBO)同样将光学引擎集成到机箱内部的系统 PCB 板上,使其更靠近主控 ASIC。然而,OBO 继承了共封装光学(CPO)的诸多挑战,同时在带宽密度和节能方面并没有带来多少优势。

来源:SemiAnalysis

CPO 的另一替代方案是"Co-packaged Copper 共封装铜缆"。该技术采用从基板连接器直接引出的铜缆布线,目标绕开 PCB 走线。虽然该方案仍使用铜介质,但在信号完整性方面具有关键优势。

2. 为何 CPO 现在很重要

尽管CPO技术优势明显,但大面积推广应用仍有诸多挑战:

-

封装和制造的复杂性(其成本甚至超过光学引擎本身),以及由此引发的可靠性、良率问题,还有光电组件紧密集成带来的热管理难题。

-

缺乏行业通用的标准化规范

-

从客户的角度看,客户对可维护性的顾虑也延缓了从传统可插拔光模块向 CPO 解决方案的过渡。此外另一个关键客户的担忧在于,采用CPO技术可能会让他们失去对成本的控制权。与数量较少、议价能力更强的交换机供应商相比,向众多光模块公司施压以降低成本要容易得多。

然而,AI 工作负载所带来的高强度网络需求意味着这一次情况已经不同。随着 AI 网络带宽路线图不断推进,互连在速度、传输距离、端口密度以及可靠性等方面的要求,很快就会超出现有可插拔光模块所能提供的能力上限。

CPO(共封装光学)确实能够为 scale-out(横向扩展)网络带来一定收益,并提供更多可选方案,但它的真正核心价值将体现在 scale-up(纵向扩展)网络中。

在本十年后半段乃至更长远的未来,CPO 将成为 scale-up 网络带宽持续提升的最主要驱动力。

3. CPO Scale-out 与 Scale-up 的 TAM 对比

1)Scale-up 与 Scale-out 在“做什么”这件事上,本质就不一样

Scale-out(后端网络)的核心作用,是将大量相对独立的计算节点连接起来,这些节点通常是多台服务器或多颗 GPU,各自拥有完整的计算与内存空间。Scale-out 网络主要服务于分布式计算场景,其典型工作包括参数同步、梯度 All-Reduce 以及批量数据交换等。这类通信往往发生在计算阶段之间,具有明显的阶段性特征,并不处在单次算力执行的关键路径上。因此,Scale-out 网络对时延的要求相对宽松,通常不需要纳秒级响应,GPU 之间也不需要共享统一的内存语义。在这种模式下,网络稍慢一些,GPU 可以等待;带宽不够,也可以通过增加通信轮次来弥补,对整体系统的可用性影响有限。

相比之下,Scale-up 的目标完全不同。Scale-up 并不是简单地“把更多 GPU 连在一起”,而是试图将多颗 GPU 组织成一个逻辑上的单一加速器。在这种架构中,GPU 之间需要像访问本地内存一样访问远端 GPU 的内存,并在硬件或系统层面实现缓存一致性(cache coherence)或内存一致性(memory coherence)。这意味着 GPU 之间的通信是持续发生、实时进行的,并且直接处在算力执行的关键路径上。任何额外的时延,都会直接转化为算力浪费;任何时延抖动,甚至可能引发系统级的不稳定问题。在 Scale-up 场景中,GPU 之间必须保持一致性的视图,网络不再只是“数据通道”,而是算力系统本身的一部分,网络慢,GPU 就会空转;网络不稳定,系统就可能失效。

2)scale-up 架构三个物理约束

首先是带宽密度的物理极限。GPU 内部算力可以通过制程和架构不断提升,但对外通信的出口却受限于封装边缘的物理尺寸。随着 scale-up 域规模扩大,每颗 GPU 需要对外提供的互连带宽快速提升,单位封装边缘所承载的数据速率被推高到 Tb/s 级别。芯片的周长是有限的(Shoreline),传统的电信号 SerDes 需要占用大量的金属引脚。当带宽达到 $1.6T 甚至更高时,芯片四周根本排不下那么多引脚。

CPO 的解法是: 光纤的带宽密度远高于铜线。通过 CPO,我们可以直接在芯片上方或边缘布置光引擎,这相当于把原本窄窄的“校门口”变成了 360 度全方位开放的“巨型航站楼”。

与此同时,功耗问题开始从工程细节演变为系统性约束。电信号跑得越快、越远,发热就越恐怖,甚至会吃掉 GPU 本身的供电。这是目前最痛的点。在传统的“可插拔光模块”方案中,信号从 GPU 出来要经过很长的 PCB 走线,为了保证信号不衰减,必须加 Retimer 芯片。这些中间环节的功耗加起来,可能占到整个系统功耗的 20%-30%。

CPO 的解法: 取消了长距离电传输和 Retimer。电信号只走几毫米就变光,光传输几乎不产生热量。这把互连功耗降低了 50% 以上,把省下来的电留给 GPU 算力。

更为根本的是信号完整性问题。在百 Gbit/s 级别的高速传输条件下,封装内走线、PCB 走线、过孔和连接器都会成为信号衰减、反射和抖动的来源。对于 scale-up 这种要求高度确定性和一致性的互连架构而言,铜互连在超过几十毫米后所引入的复杂性和不稳定性已不再是“成本问题”,而是系统可靠性问题。随着规模扩大,仅通过材料升级或算法补偿来延长电互连距离,工程难度和失败风险都会呈指数级上升。

CPO 的解法: 光具有天生的抗干扰性和极低的损耗。用光替代铜,Scale-up 就不再局限于一个小箱子,而是可以扩展到整个机柜甚至机柜阵列。

正是在这三个物理约束,带宽密度、功耗和信号完整性同时逼近极限的情况下,CPO 的角色发生了根本变化。

通过将光学引擎直接与 GPU 或交换芯片共封装,电信号只需在极短距离内完成传输即可转换为光信号,从而绕开电互连在距离、功耗和稳定性上的先天限制。

对于 scale-up 架构而言,这并不是一种“更先进的实现方式”,而是继续扩大算力规模所必须采用的技术路径。

3)也正因如此,scale-up 场景会直接放大 CPO 的总体可服务市场(TAM)。

随着 scale-up 域不断变大、单颗 GPU 所需互连带宽持续提升,每一代算力平台都会刚性地消耗更多高密度、低功耗的光互连能力。CPO 不再只是对传统可插拔光模块的渐进式替代,而是成为 scale-up 架构得以成立和演进的前置条件。这使得 CPO 的 TAM 不仅随网络规模增长,更与算力密度和系统架构升级深度绑定,最终由 scale-up 场景主导。

来源:SemiAnalysis

来源:SemiAnalysis、Miss LN,侵删

为了加强产业链上下游交流,艾邦建立有光模块产业链交流群,通讯设包括AI服务器,备,光芯片,光模块,零部件,光学元件,封装设备,材料,光模块连接器,高速铜缆,光纤等等;欢迎大家识别下方二维码申请加入。

包括但不仅限于以下议题

更多相关议题征集中,演讲及赞助请联系李小姐:18823755657(同微信)

报名方式一:扫码添加微信,咨询会议详情

李小姐:18823755657(同微信)

邮箱:lirongrong@aibang.com

注意:每位参会者均需要提供信息

方式二:长按二维码扫码在线登记报名

或者复制网址到浏览器后,微信注册报名

https://www.aibang360.com/m/100272

![2025年全球及中国服务器PCB行业产业链、发展背景、市场规模及未来趋势分析:行业规模迅速扩张,核心增量集中于AI服务器领域[图]](https://xtechcon-static.oss-cn-chengdu.aliyuncs.com/xtimes/xtimes/images/2026-02-03/69814903db082.jpeg)