导航是具身智能体的核心能力,体现了根据语言指令感知环境并与之交互的智能水平。尽管VLM在通用视觉语言任务上展现出卓越的零样本性能,但其在具身导航中的泛化能力仍局限于狭窄的任务场景与特定具身本体。

为此,北京大学王鹤老师团队联合银河通用、中国科学技术大学等提出跨具身形态、跨任务的导航基础模型NavFoM。该模型基于1270万个实例样本进行训练,包括802万个导航样本,涵盖了四足机器人、无人机、轮式机器人和车辆等多种具身形态,涉及视觉语言导航、目标搜索、目标追踪和自动驾驶等多样化任务。

在公开基准测试中表明,NavFoM模型在无需任务特定微调的情况下,能在多任务导航与跨具身本体中达到SOTA性能。并在真实场景中进一步验证了模型的泛化性和实际应用价值。

论文标题:《EMBODIED NAVIGATION FOUNDATION MODEL》

论文链接:https://arxiv.org/pdf/2509.12129

项目主页:

https://pku-epic.github.io/NavFoM-Web/

1

方法

1.1 基本架构

将基于视频的VLM扩展为一个用于导航和问答的双分支架构。对于导航分支,首先使用视觉编码器和一个跨模态投影器对观测图像进行编码,以获得视觉tokens。同时,文本指令按照现有语言模型中的常见做法进行嵌入,以生成语言tokens。接着,通过时序视角指示符和预算感知时序采样对视觉tokens进行组织,将其与语言tokens拼接后,输入到一个LLM中,以预测动作tokens。该动作tokens随后由一个规划模型解码,生成基于路径点的轨迹:

对于问答任务,遵循现有方法,以自回归的方式预测下一个tokens。

1.2 导航基础模型

该团队致力于构建一个跨任务、跨本体的具身导航基础模型NavFoM,该模型在800万个涵盖多种形态和任务的样本上进行训练。受人类主要依靠视觉感官输入完成导航任务以及近期纯视觉导航方法取得显著进展的启发,研究人员将通用导航任务定义为:处理由机器人搭载的一个或多个摄像头捕获的视频以及语言指令,并预测后续轨迹以完成人类指令。

为了使模型能够泛化到不同的摄像头配置,引入了时序视角指示tokens (TVI tokens),用于标识摄像头视角信息以及导航过程中的时间信息。通过动态调整这些TVI tokens,本论文提出的方法能够实现对不同摄像头设置的协同调优,并支持图像问答和视频问答样本的联合训练。

此外,为了解决实际部署中的硬件内存成本和推理速度等限制,提出了一种预算感知时序采样策略,该策略基于tokens预算约束下的遗忘曲线,动态地对导航历史tokens进行采样。这种tokens采样的方法平衡了性能与推理速度,提升了NavFoM在实际部署中的实用性。

1.3 数据

为了微调NavFoM,该团队收集并处理了大量全面且多样化的训练样本,总计1270万个实例样本。这些样本包括802万个导航样本,315万个基于图像的问答样本,以及161万个基于视频的问答样本,训练样本数量超过了先前的方法。

导航样本是在多样化的移动具身本体(轮式机器人、四足机器人、无人机和汽车)上收集和处理的,涵盖了包括视觉语言导航、物体目标导航、主动视觉跟踪和自动驾驶在内的多种任务。所有导航数据都以统一的方式收集,包括先前收集的来自单摄像头和多摄像头的视频、指令和预测的轨迹路径点。问答样本,遵循现有的基于视频的VLM,从现有的数据集中收集了基于图像的问答和基于视频的问答数据。

802万个导航样本中包括VLN样本337万,目标物体导航样本102万,主动视觉跟踪样本89.7万,自动驾驶样本68.1万,互联网视频导航数据203万。

2

实验

2.1 实验探究的关键问题

为评估NavFoM的性能开展了全面的实验,重点探究三个关键问题:

(1) NavFoM在不同基准测试的多样化导航任务中表现如何?

(2) NavFoM在真实环境中的性能优劣?

(3) NavFoM是否有效?在各基准测试中均将NavFoM与强基线模型进行对比。

2.2 实验结果及分析

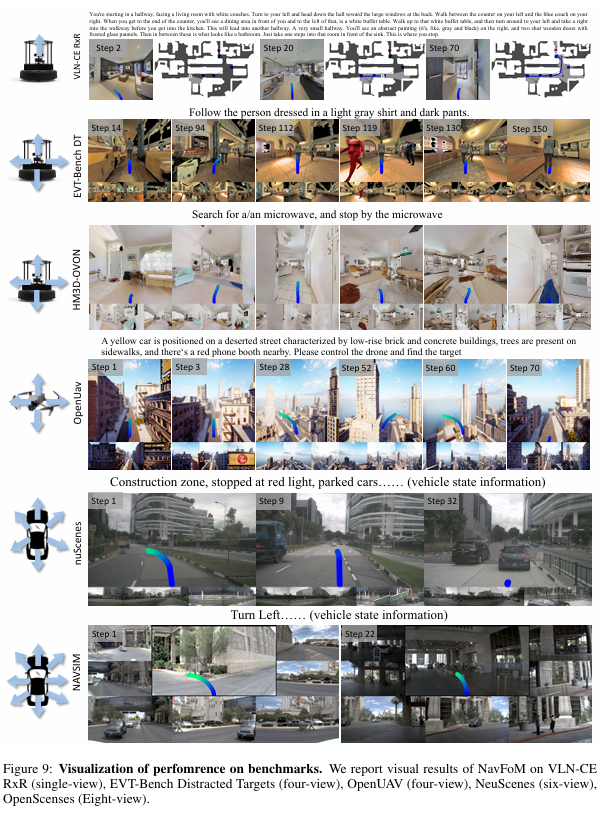

VLN-CE性能:首先在视觉语言指令基准VLN-CE R2R和VLN-CE RxR上评估NavFoM,实验结果如表1所示。

实验展示了模型在单相机和四相机设置下的性能。NavFoM模型未针对任何特定相机配置进行微调;但视觉tokens是直接使用时序视角指示符tokens进行组织的。NavFoM在不同相机设置下的这两个基准上均达到了SOTA性能。在最具有挑战性的条件单视角VLN-CE RxR上,NavFoM的成功率是57.4%比StreamVLN-RGB-only的51.8%高出5.6%。与其他基线方法不同,NavFoM在RxR上的表现优于在R2R上的表现,尽管RxR涉及到更长程和更复杂的指令。这是因为RxR指令中有更具体和详细的描述,提供了更强的上下文线索,有助于模型更好地区分目标地点。

OpenUAV性能:在一个具有挑战性的无人机场景中验证了模型的性能,该场景要求无人机遵循自然语言指令,执行长时序轨迹,以在户外环境中到达描述的目标。NavFoM直接使用从TravelUAV训练划分中收集的轨迹,因为当时没有可用的强基线模型来收集专家轨迹。尽管如此,与先前如TravelUAV等无人机专用基线方法相比,NavFoM取得了SOTA性能,且不依赖其他方法中使用的下视相机。这证明了NavFoM的有效性以及从多样化导航任务中学习的优势。

OVON搜索性能:遵循先前工作,在零样本设置下评估模型在开放词汇基准上的搜索能力。结果如表3所示,包括单相机和四相机配置下的性能。在单相机设置下,NavFoM在零样本评估设置中,在VALSEEN和VALSEENSYNONYMS上取得了不错的性能。在更具挑战性的VALUNSEEN上,NavFoM达到了SOTA性能,将成功率从40.8%提升至43.6%。此外,当从单相机设置过渡到四相机设置时,各个指标均得到了提升。

EVT-Bench追踪性能:在EVT-Bench上评估了NavFoM的表现。结果表明,NavFoM在单视角设置下达到了SOTA性能,优于先前专门针对追踪数据微调的基线方法TrackVLA。此外,当相机设置从单视角增加到四视角时,NavFoM性能持续提升。

NAVSIM与nuScenes自动驾驶性能:该团队评估了NavFoM在6视角和8视角设置下的表现。我们观察到,NavFoM在两个基准测试上均取得了与最先进方法相媲美的性能,且未显式建模驾驶相关信息。

基准测试结果可视化:图9所示提供了NavFoM在上述基准测试上的可视化结果,图中绘制了预测轨迹、相机视图及对应指令。

3

总结

北京大学王鹤老师团队联合银河通用、中国科学技术大学等提出跨具身形态、跨任务的导航基础模型NavFoM。该模型基于1270万个实例样本进行训练,包括802万个导航样本,涵盖了四足机器人、无人机、轮式机器人和车辆等多种具身形态,涉及视觉语言导航、目标搜索、目标追踪和自动驾驶等多样化任务。

该团队引入了时序视角指示符tokens,以增强LLM对导航任务中不同摄像头配置和不同时间跨度的理解,同时实现了导航数据与问答数据的协同训练。此外,采用了预算感知时序采样策略,以平衡导航性能与效率,促进了在不同摄像头设置和任务跨度下实现统一的tokens采样方法。

在公开基准和真实环境中的大量实验表明,NavFoM模型在多导航任务与具身形态中达到SOTA性能。

END

智猩猩矩阵号各专所长,点击名片关注